Pytanie 1

Która usługa pozwala na zdalne zainstalowanie systemu operacyjnego?

Wynik: 21/40 punktów (52,5%)

Wymagane minimum: 20 punktów (50%)

Która usługa pozwala na zdalne zainstalowanie systemu operacyjnego?

Jakie są korzyści płynące z użycia systemu plików NTFS?

Jakie przyporządkowanie: urządzenie - funkcja, którą pełni, jest błędne?

Do zrealizowania macierzy RAID 1 wymagane jest co najmniej

Jakie narzędzie w systemie Windows pozwala na kontrolowanie stanu sprzętu, aktualizowanie sterowników oraz rozwiązywanie problemów z urządzeniami?

Aby zmontować komputer z poszczególnych elementów, korzystając z obudowy SFF, trzeba wybrać płytę główną w formacie

Która edycja systemu operacyjnego Windows Server 2008 charakteryzuje się najuboższym interfejsem graficznym?

Które z poniższych urządzeń jest przykładem urządzenia peryferyjnego wejściowego?

Osoba pragnąca wydrukować dokumenty w oryginale oraz w trzech egzemplarzach na papierze samokopiującym powinna zainwestować w drukarkę

Użytkownik systemu Windows wybrał opcję powrót do punktu przywracania. Które pliki powstałe po wybranym punkcie nie zostaną naruszone przez tę akcję?

Jakie informacje można uzyskać na temat konstrukcji skrętki S/FTP?

Narzędzie diagnostyczne tracert służy do ustalania

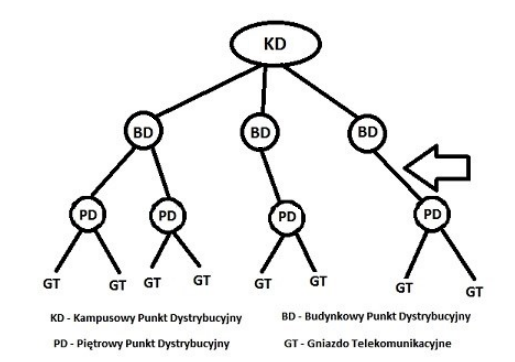

Strzałka na diagramie ilustrującym schemat systemu sieciowego według normy PN-EN 50173 wskazuje na rodzaj okablowania

NAT64 (Network Address Translation 64) to proces, który dokonuje mapowania adresów

Podaj prefiks, który identyfikuje adresy globalne w protokole IPv6?

Urządzeniem wykorzystywanym do formowania kształtów oraz grawerowania m.in. w materiałach drewnianych, szklanych i metalowych jest ploter

W systemach Windows XP Pro/ Windows Vista Bizness/Windows 7 Pro/Windows 8 Pro, rozwiązaniem zapewniającym poufność danych dla użytkowników korzystających z jednego komputera, których informacje mogą być wykorzystywane wyłącznie przez nich, jest

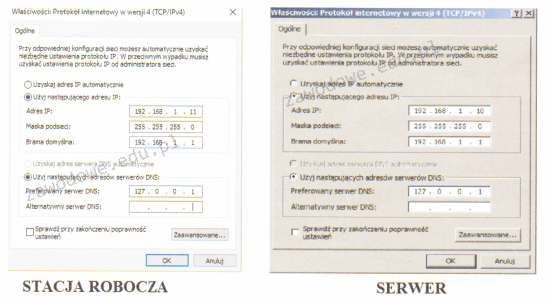

Na rysunku widać ustawienia protokołu TCP/IP serwera oraz komputera roboczego. Na serwerze działa rola serwera DNS. Wykonanie polecenia ping www.cke.edu.pl na serwerze zwraca wynik pozytywny, natomiast na stacji roboczej wynik jest negatywny. Co należy zmienić, aby usługa DNS na stacji pracowała poprawnie?

Aby zintegrować komputer z siecią LAN, należy użyć interfejsu

Który protokół zamienia adresy IP na adresy MAC, używane w sieciach Ethernet?

Jakie stwierdzenie dotyczące konta użytkownika Active Directory w systemie Windows jest właściwe?

Lista sprzętu kompatybilnego z systemem operacyjnym Windows, publikowana przez firmę Microsoft to

Jakie oprogramowanie nie jest przeznaczone do diagnozowania komponentów komputera?

W sieciach bezprzewodowych Ad-Hoc (Independent Basic Service Set) wykorzystywana jest fizyczna struktura

Wskaż błędny podział dysku MBR na partycje?

Jak nazywa się serwer Windows, na którym zainstalowano usługę Active Directory?

W przypadku adresacji IPv6, zastosowanie podwójnego dwukropka służy do

Konwencja zapisu ścieżki do udziału sieciowego zgodna z UNC (Universal Naming Convention) ma postać

Thunderbolt jest typem interfejsu:

Na podstawie filmu wskaż z ilu modułów składa się zainstalowana w komputerze pamięć RAM oraz jaką ma pojemność.

Gdy system operacyjny laptopa działa normalnie, na ekranie wyświetla się komunikat o konieczności sformatowania wewnętrznego dysku twardego. Może to sugerować

Sieć lokalna posiada adres IP 192.168.0.0/25. Który adres IP odpowiada stacji roboczej w tej sieci?

Równoważnym zapisem 232 bajtów jest zapis

Jakie narzędzie w systemie Windows Server umożliwia zarządzanie zasadami grupy?

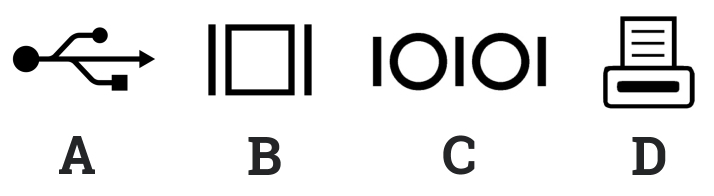

Wskaż ilustrację ilustrującą symbol stosowany do oznaczania portu równoległego LPT?

Podczas skanowania reprodukcji obrazu z magazynu, na skanie obrazu ukazały się regularne wzory, zwane morą. Jakiej funkcji skanera należy użyć, aby usunąć te wzory?

Diagnostykę systemu Linux można przeprowadzić za pomocą komendy

| Thread(s) per core: | 1 |

| Core(s) per socket: | 4 |

| Socket(s): | 1 |

| NUMA node(s): | 1 |

Polecenie Gpresult

Do akumulatora w jednostce ALU wprowadzono liczbę dziesiętną 253. Jak wygląda jej reprezentacja binarna?

Aby osiągnąć optymalną prędkość przesyłu danych, gdy domowy ruter działa w paśmie 5 GHz, do laptopa należy zainstalować kartę sieciową bezprzewodową obsługującą standard