Pytanie 1

Graficzny symbol ukazany na ilustracji oznacza

Wynik: 11/40 punktów (27,5%)

Wymagane minimum: 20 punktów (50%)

Graficzny symbol ukazany na ilustracji oznacza

Protokół pakietów użytkownika, który zapewnia dostarczanie datagramów w trybie bezpołączeniowym, to

Urządzenie przedstawione na ilustracji, wraz z podanymi danymi technicznymi, może być zastosowane do pomiarów systemów okablowania

Użytkownicy z grupy Pracownicy nie mają możliwości drukowania dokumentów za pośrednictwem serwera drukarskiego w systemie operacyjnym Windows Server. Przysługuje im jedynie uprawnienie 'Zarządzanie dokumentami'. Co należy uczynić, aby rozwiązać przedstawiony problem?

Komputer K1 jest połączony z interfejsem G0 rutera, a komputer K2 z interfejsem G1 tego samego urządzenia. Na podstawie adresacji przedstawionej w tabeli określ właściwy adres bramy dla komputera K2.

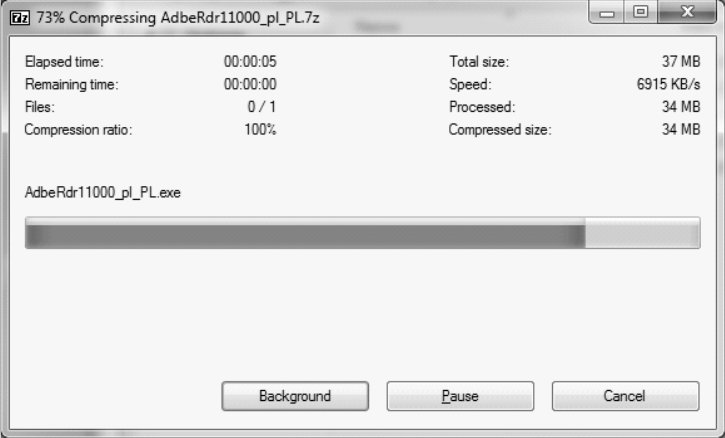

Płyta główna z gniazdem G2 będzie kompatybilna z procesorem

Licencja Windows OEM nie umożliwia wymiany

Który z poniższych programów nie służy do diagnozowania sieci komputerowej w celu wykrywania problemów?

Aby zrealizować alternatywę logiczną z negacją, konieczne jest zastosowanie funktora

W nagłówku ramki standardu IEEE 802.3 w warstwie łącza danych znajduje się

Która operacja może skutkować nieodwracalną utratą danych w przypadku awarii systemu plików?

Podczas próby nawiązania połączenia z serwerem FTP, uwierzytelnienie anonimowe nie powiodło się, natomiast logowanie za pomocą loginu i hasła zakończyło się sukcesem. Co może być przyczyną tej sytuacji?

Po podłączeniu działającej klawiatury do jednego z portów USB nie ma możliwości wyboru awaryjnego trybu uruchamiania systemu Windows. Klawiatura działa prawidłowo dopiero po wystartowaniu systemu w trybie standardowym. Co to sugeruje?

W nagłówku ramki standardu IEEE 802.3, który należy do warstwy łącza danych, znajduje się

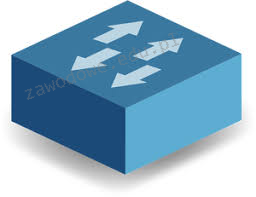

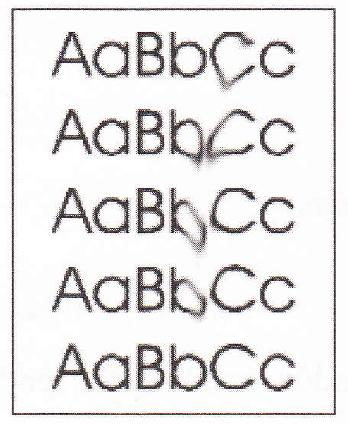

Na dołączonym obrazku ukazano proces

Aby uzyskać listę procesów aktualnie działających w systemie Linux, należy użyć polecenia

Instalacja serwera stron www w rodzinie systemów Windows Server jest możliwa dzięki roli

Licencja Windows OEM nie zezwala na wymianę

Jakie urządzenie pozwoli na połączenie kabla światłowodowego zastosowanego w okablowaniu pionowym sieci z przełącznikiem, który ma jedynie złącza RJ45?

Jaki procesor powinien być zastosowany podczas składania komputera stacjonarnego opartego na płycie głównej Asus M5A78L-M/USB3 AMD760G socket AM3+?

Jakie zastosowanie ma przedstawione narzędzie?

Który zakres adresów pozwala na komunikację multicast w sieciach z użyciem adresacji IPv6?

Dane dotyczące kont użytkowników w systemie Linux są przechowywane w pliku

W komputerze użyto płyty głównej widocznej na obrazku. Aby podnieść wydajność obliczeniową maszyny, zaleca się

Jakie narzędzie jest używane w systemie Windows do przywracania właściwych wersji plików systemowych?

Zwiększenie zarówno wydajności operacji (zapis/odczyt), jak i bezpieczeństwa przechowywania danych jest możliwe dzięki zastosowaniu macierzy dyskowej

Aby sprawdzić minimalny czas ważności hasła w systemie Windows, stosuje się polecenie

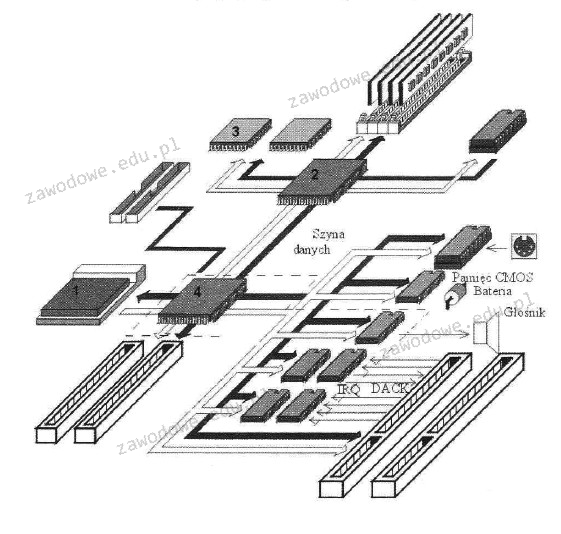

Jaką liczbą oznaczono procesor na diagramie płyty głównej komputera?

Jakie urządzenie powinno być użyte, aby poprawić zasięg sieci bezprzewodowej w obiekcie?

Aby zabezpieczyć system przed atakami z sieci nazywanymi phishingiem, nie powinno się

Aby skonfigurować i dostosować środowisko graficzne GNOME w różnych dystrybucjach Linux, należy użyć programu

Nośniki informacji, takie jak dysk twardy, gromadzą dane w jednostkach określanych jako sektory, których rozmiar wynosi

Na przedstawionym rysunku widoczna jest karta rozszerzeń z systemem chłodzenia

Do wykonania końcówek kabla UTP wykorzystuje się wtyczkę

W systemie Linux zarządzanie parametrami transmisji w sieciach bezprzewodowych jest możliwe dzięki

Aby zminimalizować główne zagrożenia dotyczące bezpieczeństwa podczas pracy na komputerze podłączonym do sieci Internet, najpierw należy

Jakie medium transmisyjne w sieciach LAN zaleca się do użycia w budynkach zabytkowych?

Najczęstszą przyczyną niskiej jakości wydruku z drukarki laserowej, która objawia się widocznym rozmazywaniem tonera, jest

Jakie polecenie w systemie Windows powinno być użyte do sprawdzania aktywnych połączeń karty sieciowej w komputerze?

Aby uporządkować dane pliku zapisane na dysku twardym, które znajdują się w nie sąsiadujących klastrach, tak by zajmowały one sąsiadujące ze sobą klastry, należy przeprowadzić