Pytanie 1

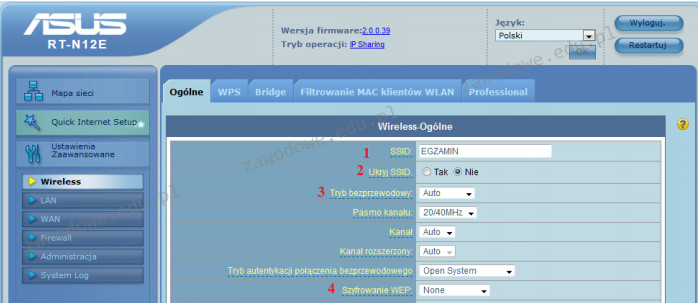

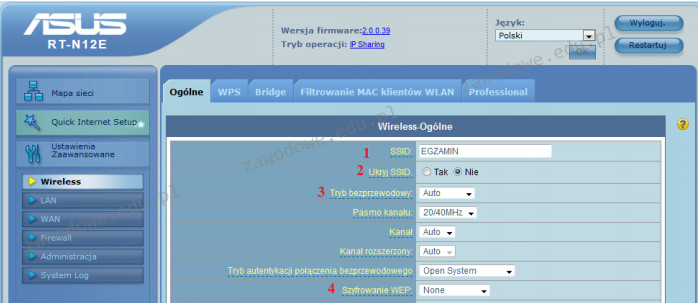

Aby zatuszować identyfikator sieci bezprzewodowej, należy zmodyfikować jego ustawienia w ruterze w polu oznaczonym numerem

Wynik: 19/40 punktów (47,5%)

Wymagane minimum: 20 punktów (50%)

Aby zatuszować identyfikator sieci bezprzewodowej, należy zmodyfikować jego ustawienia w ruterze w polu oznaczonym numerem

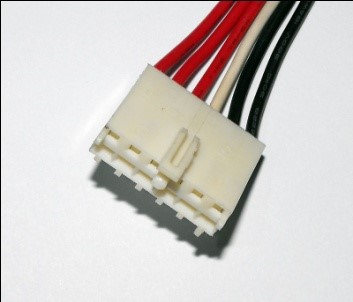

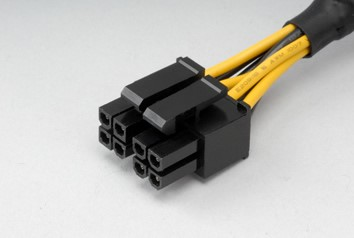

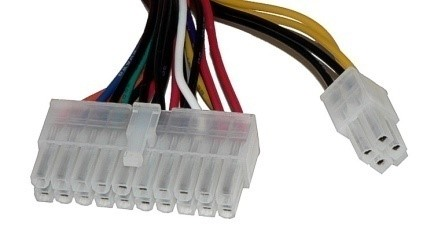

Wskaż wtyk zasilający, który podczas montażu zestawu komputerowego należy podłączyć do napędu optycznego.

Jakie informacje o wykorzystywaniu pamięci wirtualnej można uzyskać, analizując zawartość pliku w systemie Linux?

Do przeprowadzenia ręcznej konfiguracji interfejsu sieciowego w systemie Linux konieczne jest użycie polecenia

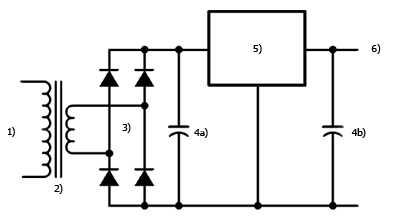

Na schemacie blokowym przedstawiającym zasadę działania zasilacza liniowego numerem 5) oznaczono

Do konfiguracji i personalizacji środowiska graficznego GNOME w różnych systemach Linux należy wykorzystać program

Przy zgrywaniu filmu kamera cyfrowa przesyła na dysk 220 MB na minutę. Wybierz z diagramu interfejs o najniższej prędkości transferu, który umożliwia taką transmisję

NAT64 (Network Address Translation 64) to proces, który przekształca adresy

Który protokół należy do bezpołączeniowych protokołów warstwy transportowej?

Okablowanie pionowe w sieci strukturalnej łączy jakie elementy?

W systemie Windows, aby założyć nową partycję podstawową, trzeba skorzystać z przystawki

Po podłączeniu działającej klawiatury do jednego z portów USB nie ma możliwości wyboru awaryjnego trybu uruchamiania systemu Windows. Klawiatura działa prawidłowo dopiero po wystartowaniu systemu w trybie standardowym. Co to sugeruje?

Na którym z domyślnych portów realizowana jest komunikacja protokołu ftp?

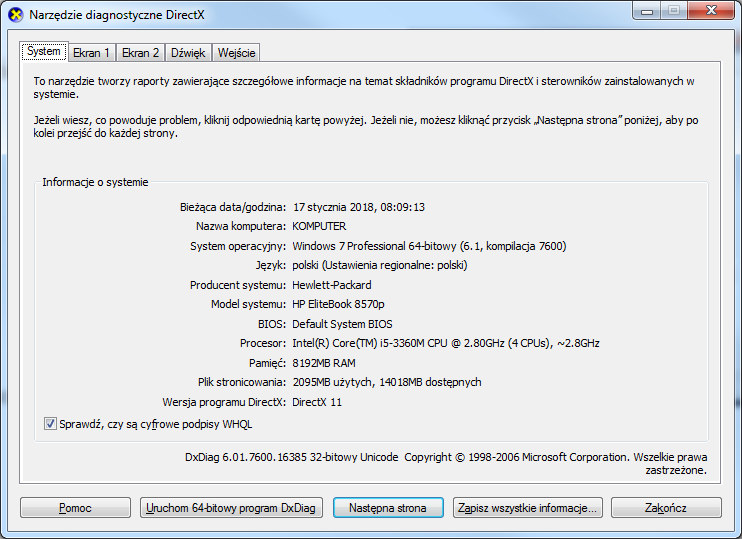

Aby uruchomić przedstawione narzędzie systemu Windows, należy użyć polecenia

Ile hostów można zaadresować w podsieci z maską 255.255.255.248?

Zestaw komputerowy, który został przedstawiony, jest niepełny. Który z elementów nie został wymieniony w tabeli, a jest kluczowy dla prawidłowego funkcjonowania zestawu?

| Lp. | Nazwa podzespołu |

|---|---|

| 1. | Zalman Obudowa R1 Midi Tower bez PSU, USB 3.0 |

| 2. | Gigabyte GA-H110M-S2H, Realtek ALC887, DualDDR4-2133, SATA3, HDMI, DVI, D-Sub, LGA1151, mATX |

| 3. | Intel Core i5-6400, Quad Core, 2.70GHz, 6MB, LGA1151, 14nm, 65W, Intel HD Graphics, VGA, BOX |

| 4. | Patriot Signature DDR4 2x4GB 2133MHz |

| 5. | Seagate BarraCuda, 3.5", 1TB, SATA/600, 7200RPM, 64MB cache |

| 6. | LG SuperMulti SATA DVD+/-R24x,DVD+RW6x,DVD+R DL 8x, bare bulk (czarny) |

| 7. | Gembird Bezprzewodowy Zestaw Klawiatura i Mysz |

| 8. | Monitor Iiyama E2083HSD-B1 19.5inch, TN, HD+, DVI, głośniki |

| 9. | Microsoft OEM Win Home 10 64Bit Polish 1pk DVD |

Do bezprzewodowego przesyłania danych pomiędzy dwoma urządzeniami, z wykorzystaniem fal radiowych w paśmie ISM 2,4 GHz, służy interfejs

Fragment pliku httpd.conf serwera Apache przedstawia się jak na diagramie. W celu zweryfikowania prawidłowego funkcjonowania strony WWW na serwerze, należy wprowadzić w przeglądarkę

| Listen 8012 |

| Server Name localhost:8012 |

W przypadku awarii którego urządzenia w sieci lokalnej, cała sieć przestaje działać w topologii magistrali?

W wyniku wykonania komendy: net user w terminalu systemu Windows, pojawi się

Jakie jest właściwe IP dla maski 255.255.255.0?

Aby stworzyć nowego użytkownika o nazwie egzamin z hasłem qwerty w systemie Windows XP, należy wykorzystać polecenie

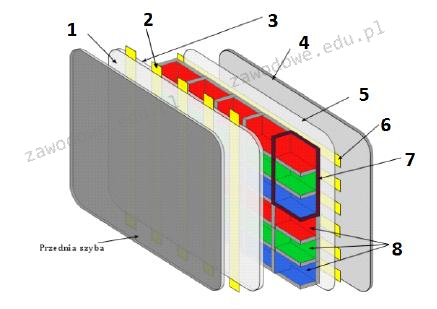

Na diagramie przedstawiającym zasadę funkcjonowania monitora plazmowego numer 6 zaznaczono

Wydruk z drukarki igłowej realizowany jest z zastosowaniem zestawu stalowych igieł w liczbie

Jaką maksymalną prędkość przesyłania danych osiągają urządzenia zgodne ze standardem 802.11g?

Router Wi-Fi działający w technologii 802.11n umożliwia osiągnięcie maksymalnej prędkości przesyłu danych

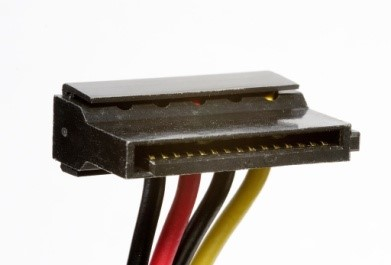

Wtyczka zasilająca SATA ma uszkodzony żółty przewód. Jakie to niesie za sobą konsekwencje dla napięcia na złączu?

Jaką usługą można pobierać i przesyłać pliki na serwer?

Aby móc zakładać konta użytkowników, komputerów oraz innych obiektów i centralnie gromadzić o nich informacje, należy zainstalować rolę na serwerze Windows

Którego z poniższych zadań nie wykonują serwery plików?

Aby w systemie Windows ustawić właściwości wszystkich zainstalowanych urządzeń lub wyświetlić ich listę, należy użyć narzędzia

Licencja na Office 365 PL Personal (1 stanowisko, subskrypcja na 1 rok) ESD jest przypisana do

Na ilustracji ukazano kartę

Wskaż efekt działania przedstawionego polecenia.

net user Test /expires:12/09/20

Domyślnie dostęp anonimowy do zasobów serwera FTP umożliwia

Jaką normę wykorzystuje się przy okablowaniu strukturalnym w komputerowych sieciach?

Układ na karcie graficznej, którego zadaniem jest zamiana cyfrowego sygnału generowanego poprzez kartę na sygnał analogowy, który może być wyświetlony poprzez monitor to

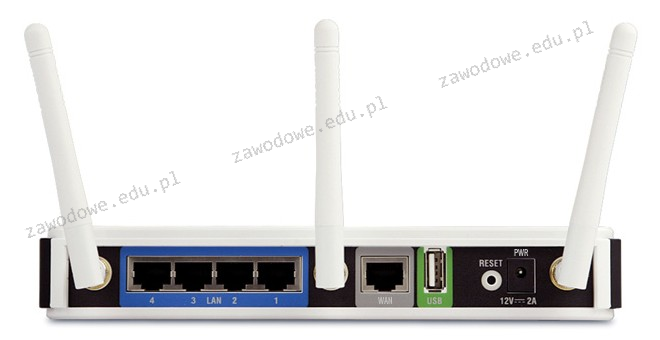

Do jakiego portu należy podłączyć kabel sieciowy zewnętrzny, aby uzyskać pośredni dostęp do sieci Internet?

W strukturze sieciowej zaleca się umiejscowienie jednego punktu abonenckiego na powierzchni wynoszącej

Jakie urządzenie sieciowe zostało zilustrowane na podanym rysunku?