Pytanie 1

Który z poniższych systemów operacyjnych jest systemem typu open-source?

Wynik: 29/40 punktów (72,5%)

Wymagane minimum: 20 punktów (50%)

Który z poniższych systemów operacyjnych jest systemem typu open-source?

Kluczowe znaczenie przy tworzeniu stacji roboczej dla wielu wirtualnych maszyn ma

Aby uniknąć uszkodzenia sprzętu podczas modernizacji komputera przenośnego polegającej na wymianie modułów pamięci RAM należy

Gniazdo w sieciach komputerowych, które jednoznacznie identyfikuje dany proces na urządzeniu, stanowi kombinację

W systemie operacyjnym Fedora foldery domowe użytkowników znajdują się w folderze

Jak nazywa się protokół bazujący na architekturze klient-serwer oraz na modelu żądanie-odpowiedź, który jest używany do transferu plików?

Narzędzie systemów operacyjnych Windows używane do zmiany ustawień interfejsów sieciowych, na przykład przekształcenie dynamicznej konfiguracji karty sieciowej w konfigurację statyczną, to

System S.M.A.R.T. jest używany do nadzorowania funkcjonowania i identyfikowania problemów

Użytkownik napotyka trudności z uruchomieniem systemu Windows. W celu rozwiązania tego problemu skorzystał z narzędzia System Image Recovery, które

Który z podanych programów pozwoli na stworzenie technicznego rysunku ilustrującego plan instalacji logicznej sieci lokalnej w budynku?

Narzędzie pokazane na ilustracji jest używane do weryfikacji

Aby usunąć konto użytkownika student w systemie operacyjnym Ubuntu, można skorzystać z komendy

Trudności w systemie operacyjnym Windows wynikające z konfliktów dotyczących zasobów sprzętowych, takich jak przydział pamięci, przerwań IRQ oraz kanałów DMA, najłatwiej zidentyfikować za pomocą narzędzia

Minimalna odległość toru nieekranowanego kabla sieciowego od instalacji elektrycznej oświetlenia powinna wynosić

Który z wymienionych adresów należy do klasy C?

Czym jest dziedziczenie uprawnień?

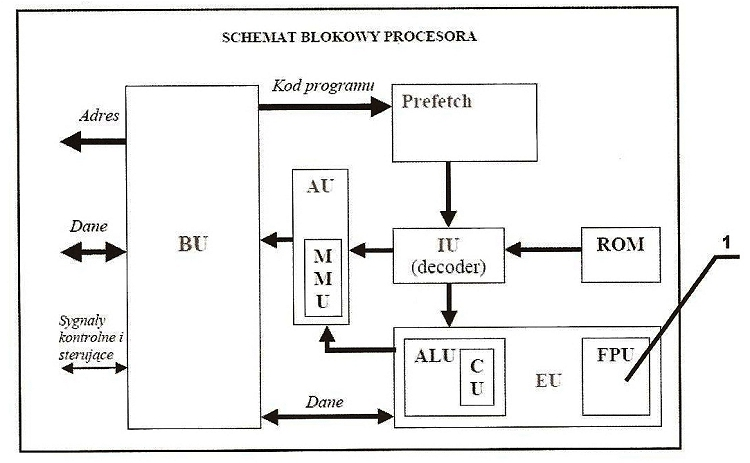

Element oznaczony numerem 1 w schemacie blokowym procesora pełni funkcję

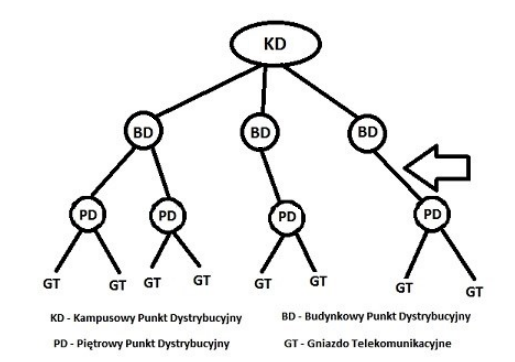

Strzałka na diagramie ilustrującym schemat systemu sieciowego według normy PN-EN 50173 wskazuje na rodzaj okablowania

W filmie przedstawiono konfigurację ustawień maszyny wirtualnej. Wykonywana czynność jest związana z

Procesem nieodwracalnym, całkowicie uniemożliwiającym odzyskanie danych z dysku twardego, jest

Po stwierdzeniu przypadkowego usunięcia ważnych danych na dysku twardym, aby odzyskać usunięte pliki, najlepiej

Wskaż błędny sposób podziału dysku MBR na partycje?

Sieci lokalne o architekturze klient-serwer są definiowane przez to, że

Jakie urządzenie służy do połączenia 6 komputerów w ramach sieci lokalnej?

Najefektywniejszym zabezpieczeniem danych firmy, której siedziby znajdują się w różnych, odległych od siebie lokalizacjach, jest zastosowanie

Wskaż podzespół niekompatybilny z płytą główną o przedstawionych w tabeli parametrach.

| Podzespół | Parametry |

|---|---|

| Płyta główna GIGABYTE | 4x DDR4, 4x PCI-E 16x, RAID, HDMI, D-Port, D-SUB, 2x USB 3.1, 8x USB 2.0, S-AM3+ |

Aby serwerowa płyta główna mogła działać poprawnie, potrzebuje pamięci z rejestrem. Który z poniższych modułów pamięci będzie z nią zgodny?

Aby osiągnąć optymalną prędkość przesyłu danych, gdy domowy ruter działa w paśmie 5 GHz, do laptopa należy zainstalować kartę sieciową bezprzewodową obsługującą standard

Menedżer urządzeń w systemie Windows pozwala na wykrycie

Aby uzyskać optymalną wydajność, karta sieciowa w komputerze stosuje transmisję szeregową.

W komputerach stacjonarnych zamontowane są karty sieciowe Ethernet 10/100/1000 z gniazdem RJ45. Jakie medium transmisyjne powinno się zastosować w celu zbudowania sieci komputerowej zapewniającej najwyższą przepustowość?

Na podstawie tabeli wskaż, który model przełącznika Cisco Catalyst, zawiera 48 portów i możliwość doposażenia o wkładki światłowodowe.

| Configurations of Cisco Catalyst 2960 Series Switches with LAN Base Software | ||

|---|---|---|

| Cisco Catalyst 2960 Switch Model | Description | Uplinks |

| 1 Gigabit Uplinks with 10/100 Ethernet Connectivity | ||

| Cisco Catalyst 2960-48PST-L | 48 Ethernet 10/100 PoE ports | 2 One Gigabit Ethernet SFP ports and 2 fixed Ethernet 10/100/1000 ports |

| Cisco Catalyst 2960-24PC-L | 24 Ethernet 10/100 PoE ports | 2 dual-purpose ports (10/100/1000 or SFP) |

| Cisco Catalyst 2960-24LT-L | 24 Ethernet 10/100 ports | 2 Ethernet 10/100/1000 ports |

| Cisco Catalyst 2960-24TC-L | 24 Ethernet 10/100 ports | 2 dual-purpose ports |

| Cisco Catalyst 2960-48TC-L | 48 Ethernet 10/100 ports | 2 dual-purpose ports (10/100/1000 or SFP) |

| Cisco Catalyst 2960-24TT-L | 24 Ethernet 10/100 ports | 2 Ethernet 10/100/1000 ports |

| Cisco Catalyst 2960-48TT-L | 48 Ethernet 10/100 ports | 2 Ethernet 10/100/1000 ports |

Jaki adres IP został przypisany do hosta na interfejsie sieciowym eth0?

[root@ipv6 tspc]# ifconfig

eth0 Link encap:Ethernet HWaddr 00:A0:C9:89:02:F8

inet addr:128.171.104.26 Bcast:128.171.104.255 Mask:255.255.255.0

inet6 addr: fe80::2a0:c9ff:fe89:2f8/10 Scope:Link

UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1

RX packets:663940 errors:0 dropped:0 overruns:0 frame:0

TX packets:67717 errors:0 dropped:0 overruns:0 carrier:0

collisions:7797 txqueuelen:100

RX bytes:234400485 (223.5 Mb) TX bytes:17743338 (16.9 Mb)

Interrupt:10 Base address:0xef80

lo Link encap:Local Loopback

inet addr:127.0.0.1 Mask:255.0.0.0

inet6 addr: ::1/128 Scope:Host

UP LOOPBACK RUNNING MTU:16436 Metric:1

RX packets:3070 errors:0 dropped:0 overruns:0 frame:0

TX packets:3070 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:0

RX bytes:153813 (150.2 Kb) TX bytes:153813 (150.2 Kb)

sit1 Link encap:IPv6-in-IPv4

inet6 addr: 3ffe:b80:2:482::2/64 Scope:Global

inet6 addr: fe80::80ab:681a/10 Scope:Link

UP POINTOPOINT RUNNING NOARP MTU:1480 Metric:1

RX packets:82 errors:0 dropped:0 overruns:0 frame:0

TX packets:78 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:0

RX bytes:8921 (8.7 Kb) TX bytes:8607 (8.4 Kb)Dysk zewnętrzny 3,5" o pojemności 5 TB, służący do przechowywania lub tworzenia kopii zapasowych, posiada obudowę z czterema interfejsami komunikacyjnymi do wyboru. Który z tych interfejsów należy wykorzystać do połączenia z komputerem, aby uzyskać największą prędkość transmisji?

Adresy IPv6 są reprezentowane jako liczby

Na ilustracji przedstawiono ustawienie karty sieciowej, której adres MAC wynosi

Ethernet adapter VirtualBox Host-Only Network:

Connection-specific DNS Suffix . :

Description . . . . . . . . . . . : VirtualBox Host-Only Ethernet Adapter

Physical Address. . . . . . . . . : 0A-00-27-00-00-07

DHCP Enabled. . . . . . . . . . . : No

Autoconfiguration Enabled . . . . : Yes

Link-local IPv6 Address . . . . . : fe80::e890:be2b:4c6c:5aa9%7(Preferred)

IPv4 Address. . . . . . . . . . . : 192.168.56.1(Preferred)

Subnet Mask . . . . . . . . . . . : 255.255.255.0

Default Gateway . . . . . . . . . :

DHCPv6 IAID . . . . . . . . . . . : 134873127

DHCPv6 Client DUID. . . . . . . . : 00-01-00-01-1F-04-2D-93-00-1F-D0-0C-7B-12

DNS Servers . . . . . . . . . . . : fec0:0:0:ffff::1%1

fec0:0:0:ffff::2%1

fec0:0:0:ffff::3%1

NetBIOS over Tcpip. . . . . . . . : EnabledDo sprawdzenia, czy zainstalowana karta graficzna komputera przegrzewa się, użytkownik może wykorzystać program

W jakim typie skanera stosuje się fotopowielacze?

Który symbol wskazuje na zastrzeżenie praw autorskich?

Aby podłączyć kasę fiskalną wyposażoną w złącze komunikacyjne DB-9M do komputera stacjonarnego, należy zastosować przewód