Pytanie 1

Najlepszym sposobem na zabezpieczenie domowej sieci Wi-Fi jest

Wynik: 19/40 punktów (47,5%)

Wymagane minimum: 20 punktów (50%)

Najlepszym sposobem na zabezpieczenie domowej sieci Wi-Fi jest

Przynależność komputera do konkretnej wirtualnej sieci nie może być ustalona na podstawie

W systemie Linux, jakie polecenie służy do zmiany hasła użytkownika?

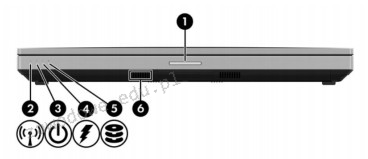

Na ilustracji zaprezentowane jest oznaczenie sygnalizacji świetlnej w dokumentacji technicznej laptopa. Podaj numer kontrolki, która świeci się w czasie ładowania akumulatora?

Do efektywnego zrealizowania macierzy RAID 1 wymagane jest minimum

Wskaż nazwę modelu przechowywania i przetwarzania danych opartego na użytkowaniu zasobów dyskowych, obliczeniowych i programowych, udostępnionych przez usługodawcę za pomocą sieci komputerowej.

Jaką usługę należy zainstalować na systemie Linux, aby umożliwić bezpieczny zdalny dostęp?

Cechą charakterystyczną transmisji w interfejsie równoległym synchronicznym jest to, że

Jak nazywa się serwer Windows, na którym zainstalowano usługę Active Directory?

Aby bezpiecznie połączyć się z firmowym serwerem przez Internet i mieć dostęp do zasobów firmy, należy wykorzystać odpowiednie oprogramowanie klienckie

Która z poniższych informacji odnosi się do profilu tymczasowego użytkownika?

Zakres operacji we/wy dla kontrolera DMA w notacji heksadecymalnej wynosi 0094-009F, a w systemie dziesiętnym?

Po podłączeniu działającej klawiatury do któregokolwiek z portów USB nie ma możliwości wyboru awaryjnego trybu uruchamiania systemu Windows. Jednakże, klawiatura funkcjonuje prawidłowo po uruchomieniu systemu w standardowym trybie. Co to sugeruje?

Który standard z rodziny IEEE 802 odnosi się do sieci bezprzewodowych, zwanych Wireless LAN?

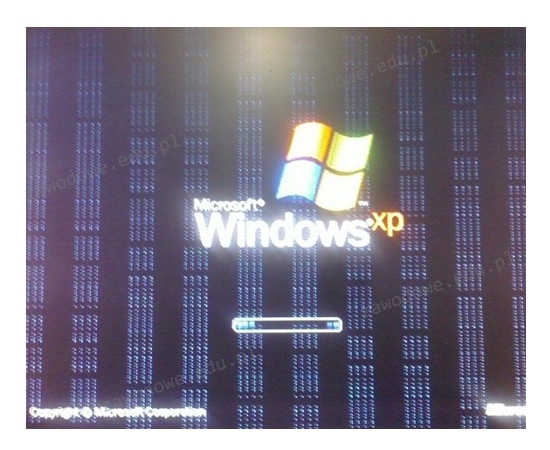

Usterka zaprezentowana na ilustracji, widoczna na monitorze, nie może być spowodowana przez

Aby uzyskać adres IPv4, za pomocą usługi DHCP, komputer kliencki wysyła żądania z portu

Które z poniższych wskazówek jest NIEWłaściwe w kontekście konserwacji skanera płaskiego?

Do usunięcia kurzu z wnętrza obudowy drukarki fotograficznej zaleca się zastosowanie

Na podstawie filmu wskaż z ilu modułów składa się zainstalowana w komputerze pamięć RAM oraz jaką ma pojemność.

Który standard w połączeniu z odpowiednią kategorią kabla skrętki jest skonfigurowany w taki sposób, aby umożliwiać maksymalny transfer danych?

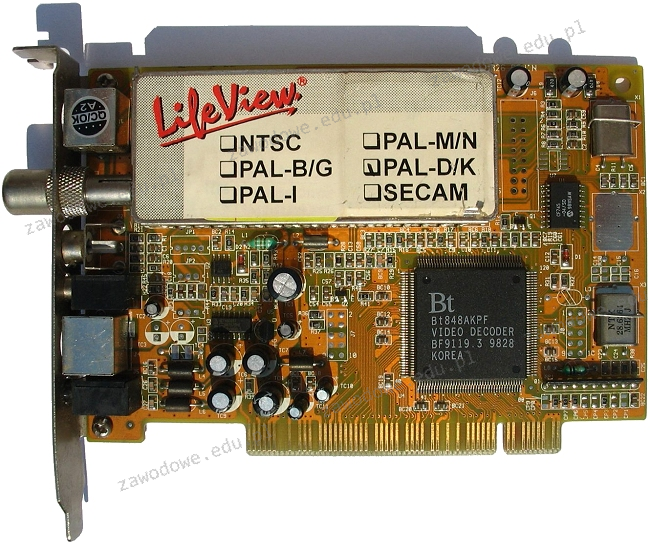

Zainstalowanie w komputerze przedstawionej karty pozwoli na

Granice domeny kolizyjnej nie są określane przez porty takich urządzeń jak

Typ profilu użytkownika w systemie Windows Serwer, który nie zapisuje zmian wprowadzonych na bieżącym pulpicie ani na serwerze, ani na stacji roboczej po wylogowaniu, to profil

Jaki protokół jest używany przez komendę ping?

Która z opcji konfiguracji ustawień konta użytkownika o ograniczonych uprawnieniach w systemie Windows jest dostępna dzięki narzędziu secpol?

Aby serwerowa płyta główna mogła działać poprawnie, potrzebuje pamięci z rejestrem. Który z poniższych modułów pamięci będzie z nią zgodny?

Na ilustracji ukazano narzędzie systemu Windows 7 służące do

Jakie protokoły przesyłają regularne kopie tablic routingu do sąsiednich ruterów, nie zawierając pełnych informacji o odległych urządzeniach routujących?

Po włączeniu komputera wyświetlił się komunikat: Non-system disk or disk error. Replace and strike any key when ready. Co może być tego przyczyną?

Na ilustracji złącze monitora, które zostało zaznaczone czerwoną ramką, będzie współdziałać z płytą główną posiadającą interfejs

W zestawieniu przedstawiono istotne parametry techniczne dwóch typów interfejsów. Z powyższego wynika, że SATA w porównaniu do ATA charakteryzuje się

| Table Comparison of parallel ATA and SATA | ||

|---|---|---|

| Parallel ATA | SATA 1.5 Gb/s | |

| Bandwidth | 133 MB/s | 150 MB/s |

| Volts | 5V | 250 mV |

| Number of pins | 40 | 7 |

| Cable length | 18 in. (45.7 cm) | 39 in. (1 m) |

Jakie polecenie w systemach Linux służy do przedstawienia konfiguracji interfejsów sieciowych?

Aby możliwe było zorganizowanie pracy w wydzielonych logicznie mniejszych podsieciach w sieci komputerowej, należy ustawić w przełączniku

Jakie złącze powinna mieć karta graficzna, aby mogła być bezpośrednio podłączona do telewizora LCD, który ma tylko analogowe złącze do komputera?

Najczęstszą przyczyną niskiej jakości wydruku z drukarki laserowej, która objawia się widocznym rozmazywaniem tonera, jest

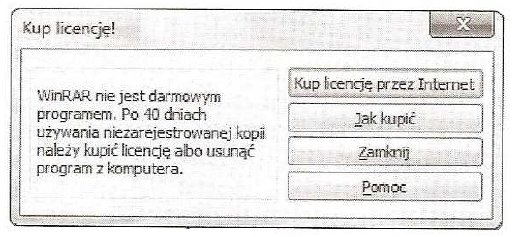

Program WinRaR pokazał okno informacyjne przedstawione na ilustracji. Jakiego rodzaju licencję na oprogramowanie użytkownik stosował do tej pory?

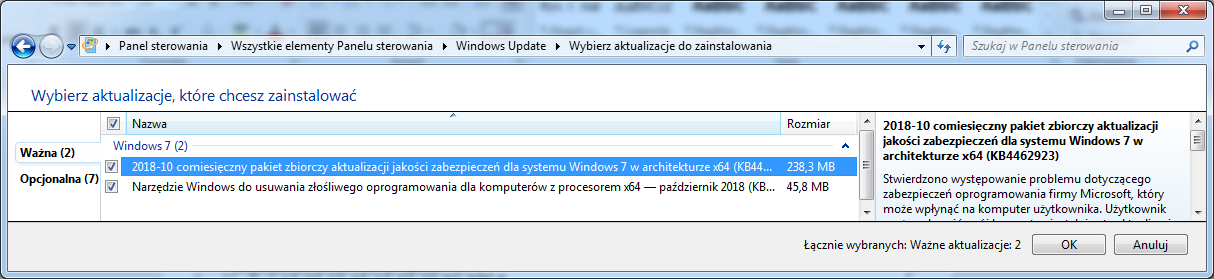

Głównie które aktualizacje zostaną zainstalowane po kliknięciu na przycisk OK prezentowany na zrzucie ekranu?

Jaką przepustowość określa standard Ethernet IEEE 802.3z?

Który z parametrów czasowych w pamięci RAM określany jest jako czas dostępu?

Ile bitów trzeba wydzielić z części hosta, aby z sieci o adresie IPv4 170.16.0.0/16 utworzyć 24 podsieci?