Pytanie 1

Które polecenie systemu Linux służy do wyświetlenia informacji o zainstalowanych podzespołach?

Wynik: 16/40 punktów (40,0%)

Wymagane minimum: 20 punktów (50%)

Które polecenie systemu Linux służy do wyświetlenia informacji o zainstalowanych podzespołach?

Jaki protokół umożliwia terminalowe połączenie zdalne z urządzeniami, zapewniając przy tym transfer danych w sposób zaszyfrowany?

Na rysunku można zobaczyć schemat topologii fizycznej, która jest kombinacją topologii

W strukturze sieciowej zaleca się umiejscowienie jednego punktu abonenckiego na powierzchni wynoszącej

Oprogramowanie komputerowe, które jest dostępne bezpłatnie i bez ograniczeń czasowych, jest dystrybuowane na podstawie licencji typu

Do jakiej grupy w systemie Windows Server 2008 powinien być przypisany użytkownik odpowiedzialny jedynie za archiwizację danych zgromadzonych na dysku serwera?

Jaki adres IP w formacie dziesiętnym odpowiada adresowi IP 10101010.00001111.10100000.11111100 zapisanym w formacie binarnym?

Jak brzmi nazwa profilu użytkownika w systemie Windows, który jest zakładany podczas pierwszego logowania do komputera i zapisany na lokalnym dysku twardym, a wszelkie jego modyfikacje odnoszą się wyłącznie do maszyny, na której zostały przeprowadzone?

Jakie polecenie w systemie Linux pokazuje czas działania systemu oraz jego średnie obciążenie?

Jakie medium transmisyjne gwarantuje izolację galwaniczną pomiędzy systemami przesyłu danych?

Podczas skanowania reprodukcji obrazu z magazynu, na skanie obrazu ukazały się regularne wzory, zwane morą. Jakiej funkcji skanera należy użyć, aby usunąć te wzory?

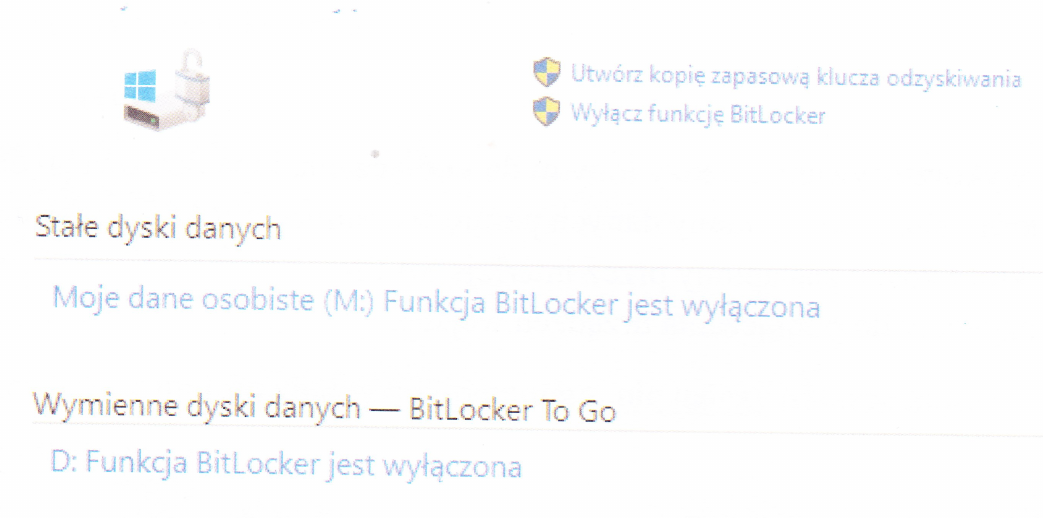

Wbudowane narzędzie dostępne w systemach Windows w edycji Enterprise lub Ultimate jest przeznaczone do

Watomierz jest stosowany do pomiaru

Urządzenie przedstawione na ilustracji oraz jego dane techniczne mogą być użyte do pomiarów rodzaju okablowania

Jaki jest adres broadcastowy dla sieci posiadającej adres IP 192.168.10.0/24?

Jaki rodzaj portu może być wykorzystany do podłączenia zewnętrznego dysku do laptopa?

Na schemacie przedstawiono sieć o strukturze

Który protokół zajmuje się konwersją adresów IP na adresy MAC (kontroli dostępu do nośnika)?

Celem złocenia styków złącz HDMI jest

W jakim oprogramowaniu trzeba zmienić konfigurację, aby użytkownik mógł wybrać z listy i uruchomić jeden z różnych systemów operacyjnych zainstalowanych na swoim komputerze?

W jakim typie członkostwa w VLAN port może należeć do wielu sieci VLAN?

W systemie Windows harmonogram zadań umożliwia przydzielenie

Wskaż sygnał, który wskazuje na uszkodzenie karty graficznej w komputerze z BIOS POST od firmy AWARD?

Aby poprawić niezawodność i efektywność przesyłu danych na serwerze, należy

Która z podanych właściwości kabla koncentrycznego RG-58 sprawia, że obecnie nie jest on używany do tworzenia lokalnych sieci komputerowych?

Jaką minimalną liczbę bitów potrzebujemy w systemie binarnym, aby zapisać liczbę heksadecymalną 110 (h)?

Co nie wpływa na utratę z pamięci masowej HDD?

Na zdjęciu widać

Jakie napięcie jest obniżane z 230 V w zasilaczu komputerowym w standardzie ATX dla różnych podzespołów komputera?

Komputer jest połączony z myszą bezprzewodową, a kursor w trakcie używania nie porusza się płynnie, tylko "skacze" po ekranie. Możliwą przyczyną awarii urządzenia może być

Jakie materiały eksploatacyjne wykorzystuje się w drukarce laserowej?

Ile warstw zawiera model ISO/OSI?

Norma PN-EN 50173 rekomenduje montaż przynajmniej

Recykling można zdefiniować jako

Oblicz koszt wykonania okablowania strukturalnego od 5 punktów abonenckich do panelu krosowego wraz z wykonaniem kabli połączeniowych dla stacji roboczych. W tym celu wykorzystano 50 m skrętki UTP. Punkt abonencki składa się z 2 gniazd typu RJ

| Materiał | Jednostka | Cena |

|---|---|---|

| Gniazdo podtynkowe 45x45, bez ramki, UTP 2xRJ45 kat.5e | szt. | 17 zł |

| UTP kabel kat.5e PVC 4PR 305m | karton | 305 zł |

| RJ wtyk UTP kat.5e beznarzędziowy | szt. | 6 zł |

Czym są programy GRUB, LILO, NTLDR?

W jakim miejscu są zapisane dane dotyczące kont użytkowników domenowych w systemach Windows Server?

Który standard IEEE 802.3 powinien być użyty w sytuacji z zakłóceniami elektromagnetycznymi, jeżeli odległość między punktem dystrybucyjnym a punktem abonenckim wynosi 200 m?

Podaj domyślny port używany do przesyłania poleceń (command) w serwerze FTP

Jakie zakresy adresów IPv4 mogą być używane jako adresy prywatne w lokalnej sieci?