Pytanie 1

Który protokół routingu jest używany do wymiany danych dotyczących dostępności sieci pomiędzy autonomicznymi systemami?

Wynik: 8/40 punktów (20,0%)

Wymagane minimum: 20 punktów (50%)

Który protokół routingu jest używany do wymiany danych dotyczących dostępności sieci pomiędzy autonomicznymi systemami?

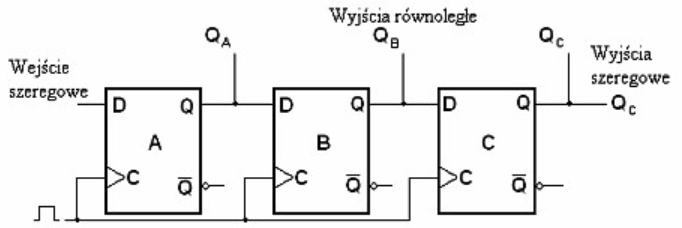

Rysunek przedstawia

Zakres fal radiowych oznaczony jako UHF (Ultra High Frequency) obejmuje częstotliwości w przedziale

Jakie jest główne zadanie protokołu DHCP w sieci komputerowej?

Jakie urządzenie można zastosować do pomiaru czasu narastania impulsu?

Jakie znaczenie ma pojęcie "hotspot"?

Jaką wartość ma przepływność podstawowej jednostki transportowej STM – 1 w systemie SDH?

Ruter to urządzenie stanowiące węzeł w sieci, które działa

Modulacja to proces zmiany parametrów ustalonego, standardowego sygnału, który określamy jako sygnał

W dzisiejszych smartfonach używa się baterii

Jakie jednostki są używane do opisu zysku energetycznego anten?

Która technika modulacji jest używana do przedstawiania sygnału analogowego mowy w cyfrowych systemach telekomunikacyjnych?

Osoba, która zdobyła program typu FREEWARE,

Technika przesyłania danych o stałej długości 53 bajtów nazywa się komutacją

Kategoryzacja światłowodów na skokowe i gradientowe jest powiązana

Jakie jest zastosowanie programu traceroute w systemach Unix?

Z jakiego zakresu adresów IP mechanizm APIPA (Automatic Private IP Addressing) przydzieli komputerowi adres, jeśli serwer DHCP w sieci nie funkcjonuje?

Suma kontrolna umieszczona w ramce ma na celu

Modulacja PCM (Pulse Code Modulation) jest wykorzystywana do przedstawiania

Jakie urządzenie pomiarowe umożliwia zidentyfikowanie uszkodzenia światłowodu?

Która z klas ruchowych w technologii ATM jest przeznaczona dla źródeł o nieokreślonej prędkości transmisji, które realizują nieregularny transfer dużych ilości danych w miarę dostępności łącza?

Gdy podczas instalacji sterownika do drukarki sieciowej odpowiedni model nie występuje na liście kreatora dodawania sprzętu, co należy zrobić?

W jaki sposób generowany jest obraz na wyświetlaczu LCD?

Który z protokołów routingu wykorzystuje metodę wektora odległości?

W systemach operacyjnych obsługujących wiele zadań, co oznacza skrót PID?

Jakie kodowanie jest używane na styku S w ISDN BRA?

Urządzenia sieciowe mają ustawione adresy IP i maski zgodnie z tabelą. W ilu sieciach pracują te urządzenia?

| Adres IP / Maska |

|---|

| 9.1.63.11 /16 |

| 9.2.63.11 /16 |

| 9.3.65.11 /16 |

| 9.4.66.12 /16 |

| 9.5.66.12 /16 |

Jaki rodzaj wykresu w programie do arkuszy kalkulacyjnych powinno się zastosować, aby zaprezentować procentowy udział poszczególnych wartości w całości?

Jakie urządzenie w pasywnych systemach sieci optycznych pełni rolę multipleksera i demultipleksera?

Jaką wartość ma przepływność binarna w systemie PCM 30/32?

W BIOS-ie komputera w ustawieniach "Boot Sequence" przypisane są następujące wartości:

First Boot Device: Removable Device

Second Boot Device: ATAPI CD-ROM

Third Boot Device: Hard Drive

Jaką kolejność ma proces przeszukiwania zainstalowanych urządzeń w celu zlokalizowania sektora startowego?

Zbiór zasad i ich charakterystyki zapewniających zgodność stworzonych aplikacji z systemem operacyjnym to

W tabeli została zamieszczona specyfikacja techniczna

| Ilość portów WAN | 1 |

| Konta SIP | 8 |

| Obsługiwane kodeki | - G.711 - alaw, ulaw - 64 Kbps - G.729 - G.729A - 8 Kbps, ramka10ms |

| Obsługiwane protokoły | - SIP - Session Initiation Protocol -SCCP - Skinny Client Control Protocol |

| Zarządzanie przez | - WWW - zarządzanie przez przeglądarkę internetową - TFTP - Trivial File Transfer Protocol - klawiatura telefonu |

Jeśli moc sygnału na początku łącza wynosi 1 000 mW, a na końcu 100 mW, to jaka jest tłumienność tego łącza?

Szybką transmisję informacji w niewielkich pakietach o stałej długości 53 bajtów zapewnia sprzętowa implementacja komutacji

Jakie polecenie w systemie Windows umożliwia ustalenie, jaką trasą oraz przez jakie punkty pośrednie przesyłane są pakiety do odbiorcy w internecie?

Jaki protokół służy do przesyłania formatów PCM, GSM, MP3 (audio) oraz MPEG i H263 (wideo)?

Podczas próby uruchomienia systemu operacyjnego z przenośnego nośnika typu pendrive oraz realizacji procedury POST, urządzenie nie zostało rozpoznane. Co należy zrobić, aby rozwiązać ten problem?

Rozdzielenie jednego strumienia danych na wiele kanałów fizycznych to

Co to jest QPSK w kontekście modulacji?