Pytanie 1

W systemie Windows użycie prezentowanego polecenia spowoduje tymczasową zmianę koloru

Wynik: 15/40 punktów (37,5%)

Wymagane minimum: 20 punktów (50%)

W systemie Windows użycie prezentowanego polecenia spowoduje tymczasową zmianę koloru

Który z wymienionych protokołów jest szyfrowanym protokołem do zdalnego dostępu?

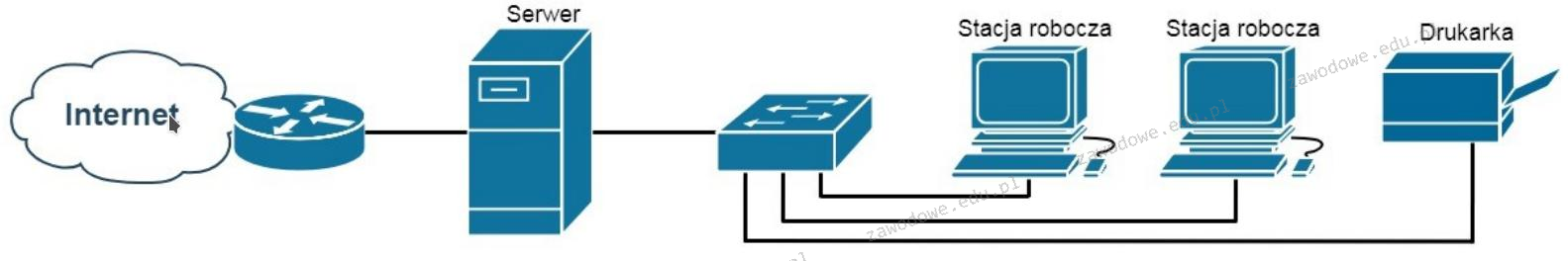

Która z usług na serwerze Windows umożliwi użytkownikom końcowym sieci zaprezentowanej na ilustracji dostęp do Internetu?

Na podstawie specyfikacji płyty głównej przedstawionej w tabeli, wskaż największą liczbę kart rozszerzeń, które mogą być podłączone do magistrali Peripheral Component Interconnect?

| BIOS Type | AWARD |

| BIOS Version | 1.8 |

| Memory Sockets | 3 |

| Expansion Slots | 1 AGP/5 PCI |

| AGP 8X | Yes |

| AGP Pro | No |

| NorthbridgeCooling Fan | Yes |

| Northbridge | nForce2 SPP |

| Southbridge | nForce2 MCP-T |

| FSB Speeds | 100-300 1 MHz |

| MultiplierSelection | Yes – BIOS |

| CoreVoltages | 1.1V-2.3V |

| DDR Voltages | 2.5V-2.9V |

| AGP Voltages | 1.5V-1.8V |

| Chipset Voltages | 1.4V-1.7V |

| AGP/PCI Divider in BIOS | Yes (AGP) |

Bęben światłoczuły stanowi kluczowy element w funkcjonowaniu drukarki

Jaki element sieci SIP określamy jako telefon IP?

W hierarchicznym modelu sieci komputery użytkowników stanowią część warstwy

Shareware to typ licencji, która polega na

Zjawiskiem typowym, które może świadczyć o nadchodzącej awarii twardego dysku, jest wystąpienie

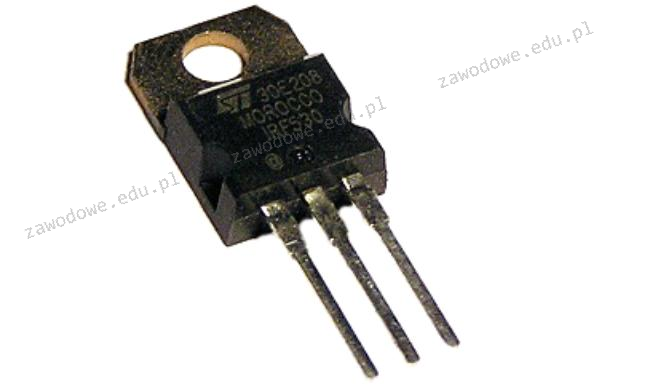

Element elektroniczny przedstawiony na ilustracji to

Karta rozszerzeń przedstawiona na zdjęciu dysponuje systemem chłodzenia

Jakiego rodzaju złącze powinna mieć płyta główna, aby użytkownik był w stanie zainstalować kartę graficzną przedstawioną na rysunku?

W celu ochrony lokalnej sieci komputerowej przed atakami typu Smurf pochodzącymi z Internetu, należy zainstalować oraz właściwie skonfigurować

Dwie stacje robocze w tej samej sieci nie są w stanie się skomunikować. Która z poniższych okoliczności może być przyczyną opisanego problemu?

Która z kart graficznych nie będzie kompatybilna z monitorem, posiadającym złącza pokazane na ilustracji (zakładając, że nie można użyć adaptera do jego podłączenia)?

Jak nazywa się pamięć podręczną procesora?

Na którym standardowym porcie funkcjonuje serwer WWW wykorzystujący domyślny protokół HTTPS w typowym ustawieniu?

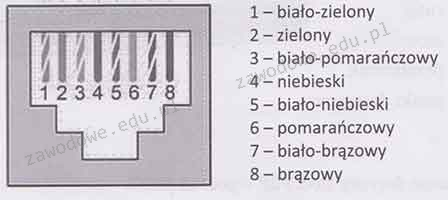

Który typ standardu zakończenia kabla w systemie okablowania strukturalnego ilustruje przedstawiony rysunek?

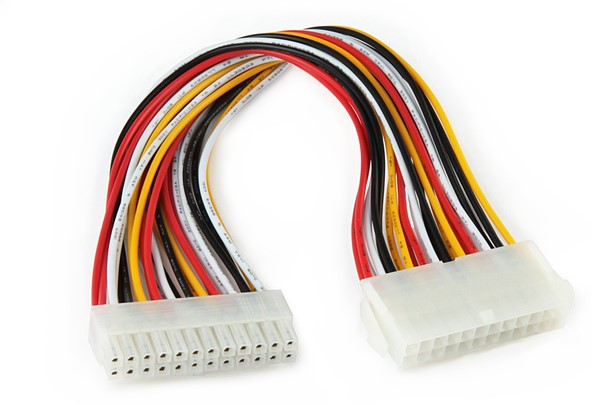

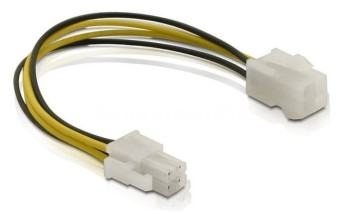

Wskaż złącze, które należy wykorzystać do podłączenia wentylatora, którego parametry przedstawiono w tabeli.

| Wymiar radiatora | 123 x 133 x 163 mm |

| Wentylator | 120 mm + 135 mm |

| Złącze | 4-pin PWM |

| Napięcie zasilające | 12V |

| Żywotność | 300 000h |

W załączonej ramce przedstawiono opis technologii

| Technologia ta to rewolucyjna i nowatorska platforma, która pozwala na inteligentne skalowanie wydajności podsystemu graficznego poprzez łączenie mocy kilku kart graficznych NVIDIA pracujących na płycie głównej. Dzięki wykorzystaniu zastrzeżonych algorytmów oraz wbudowanej w każdy z procesorów graficznych NVIDIA dedykowanej logiki sterującej, która odpowiada za skalowanie wydajności, technologia ta zapewnia do 2 razy (w przypadku dwóch kart) lub 2,8 razy (w przypadku trzech kart) wyższą wydajność niż w przypadku korzystania z pojedynczej karty graficznej. |

Podstawowym zadaniem mechanizmu Plug and Play jest

W przypadku dłuższego nieużytkowania drukarki atramentowej, pojemniki z tuszem powinny

/dev/sda: Czas odczytu z pamięci podręcznej: 18100 MB w 2.00 sekundy = 9056.95 MB/sek. Przedstawiony wynik wykonania polecenia systemu Linux jest używany do diagnostyki

Który z podanych programów pozwoli na stworzenie technicznego rysunku ilustrującego plan instalacji logicznej sieci lokalnej w budynku?

Proporcja ładunku zgromadzonego na przewodniku do potencjału tego przewodnika definiuje jego

Część programu antywirusowego działająca w tle jako kluczowy element zabezpieczeń, mająca na celu nieustanne monitorowanie ochrony systemu komputerowego, to

W której warstwie modelu ISO/OSI odbywa się segmentacja danych, komunikacja w trybie połączeniowym z użyciem protokołu TCP oraz komunikacja w trybie bezpołączeniowym z zastosowaniem UDP?

W filmie przedstawiono konfigurację ustawień maszyny wirtualnej. Wykonywana czynność jest związana z

Jakim interfejsem można uzyskać transmisję danych o maksymalnej przepustowości 6 Gb/s?

Aby możliwe było przekierowanie drukowanego dokumentu na dysk twardy, należy w opcjach konfiguracyjnych drukarki wybrać drukowanie do portu

Jakie urządzenie należy zastosować, aby połączyć sieć lokalną wykorzystującą adresy prywatne z Internetem?

Jaką liczbę komórek pamięci można bezpośrednio zaadresować w 64-bitowym procesorze z 32-bitową szyną adresową?

Jak wygląda liczba 356 w systemie binarnym?

Po podłączeniu działającej klawiatury do któregokolwiek z portów USB nie ma możliwości wyboru awaryjnego trybu uruchamiania systemu Windows. Jednakże, klawiatura funkcjonuje prawidłowo po uruchomieniu systemu w standardowym trybie. Co to sugeruje?

W których nośnikach pamięci masowej jedną z najczęstszych przyczyn uszkodzeń jest uszkodzenie powierzchni?

Aktualizacja systemów operacyjnych to proces, którego głównym zadaniem jest

W systemie Linux istnieją takie prawa dostępu do konkretnego pliku rwxr--r--. Jakie polecenie użyjemy, aby zmienić je na rwxrwx---?

Podczas skanowania reprodukcji obrazu z czasopisma, na skanie obrazu pojawiły się regularne wzory, tak zwana mora. Z jakiej funkcji skanera należy skorzystać, aby usunąć morę?

Sprzęt używany w sieciach komputerowych, posiadający dedykowane oprogramowanie do blokowania nieautoryzowanego dostępu do sieci, to

Wysyłanie żetonu (ang. token) występuje w sieci o fizycznej strukturze