Pytanie 1

Jaki protokół służy komputerom do informowania rutera o przynależności do konkretnej grupy multicastowej?

Wynik: 20/40 punktów (50,0%)

Wymagane minimum: 20 punktów (50%)

Jaki protokół służy komputerom do informowania rutera o przynależności do konkretnej grupy multicastowej?

Symbol przedstawiony na ilustracji oznacza rodzaj złącza

Jakie zastosowanie ma oprogramowanie Microsoft Hyper-V?

Jaki akronim odnosi się do przepustowości sieci oraz usług, które mają między innymi na celu nadawanie priorytetów przesyłanym pakietom?

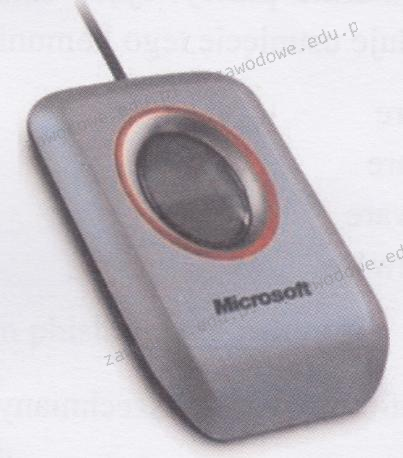

Urządzeniem peryferyjnym pokazanym na ilustracji jest skaner biometryczny, który wykorzystuje do identyfikacji

Podstawowy rekord uruchamiający na dysku twardym to

Aby uzyskać wyświetlenie podanych informacji o systemie Linux w terminalu, należy skorzystać z komendy

Rysunek ilustruje rezultaty sprawdzania działania sieci komputerowej przy użyciu polecenia

Aby przeprowadzić rezerwację adresów IP w systemie Windows Server na podstawie fizycznych adresów MAC urządzeń, konieczne jest skonfigurowanie usługi

Pierwsze trzy bity adresu IP w formacie binarnym mają wartość 010. Jaką klasę reprezentuje ten adres?

Aby utworzyć programową macierz RAID-1, potrzebne jest minimum

Składnikiem systemu Windows 10, który zapewnia ochronę użytkownikom przed zagrożeniami ze strony złośliwego oprogramowania, jest program

Jakie funkcje pełni protokół ARP (Address Resolution Protocol)?

W jakim systemie występuje jądro hybrydowe (kernel)?

Jakie polecenie trzeba wydać w systemie Windows, aby zweryfikować tabelę mapowania adresów IP na adresy MAC wykorzystywane przez protokół ARP?

Magistrala PCI-Express do przesyłania danych stosuje metodę komunikacyjną

Zarządzanie partycjami w systemach operacyjnych Windows

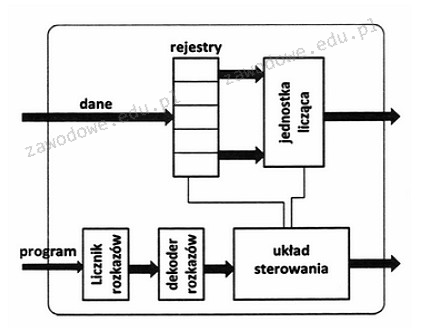

Na schemacie procesora rejestry mają za zadanie przechowywać adres do

Jaką topologię fizyczną charakteryzuje zapewnienie nadmiarowych połączeń między urządzeniami sieciowymi?

Jakie urządzenie umożliwia połączenie sieci lokalnej z siecią rozległą?

Kontrola pasma (ang. bandwidth control) w switchu to funkcjonalność

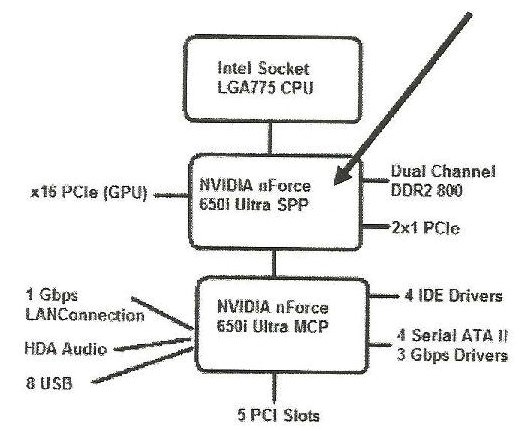

Jaką rolę pełni komponent wskazany strzałką na schemacie chipsetu płyty głównej?

Usługa w systemie Windows Server, która umożliwia zdalną instalację systemów operacyjnych na komputerach zarządzanych przez serwer, to

Na ilustracji przedstawiony jest tylny panel jednostki komputerowej. Jakie jest nazewnictwo dla złącza oznaczonego strzałką?

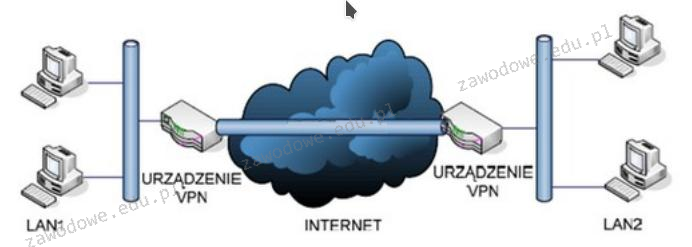

Schemat ilustruje zasadę funkcjonowania sieci VPN o nazwie

Po podłączeniu działającej klawiatury do jednego z portów USB nie ma możliwości wyboru awaryjnego trybu uruchamiania systemu Windows. Klawiatura działa prawidłowo dopiero po wystartowaniu systemu w trybie standardowym. Co to sugeruje?

W lokalnej sieci uruchomiono serwer odpowiedzialny za przydzielanie dynamicznych adresów IP. Jaką usługę należy aktywować na tym serwerze?

W systemach Windows XP Pro/Windows Vista Business/Windows 7 Pro/Windows 8 Pro, funkcją zapewniającą ochronę danych dla użytkowników dzielących ten sam komputer, których informacje mogą być wykorzystywane wyłącznie przez nich, jest

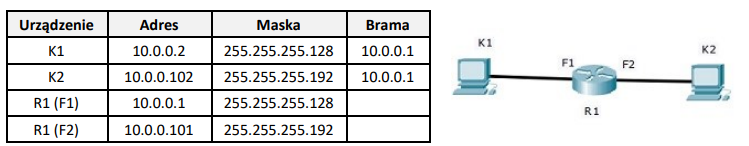

Komputery K1 i K2 nie są w stanie nawiązać komunikacji. Adresy urządzeń zostały przedstawione w tabeli. Co należy zmienić, aby przywrócić połączenie w sieci?

W systemie Windows powiązanie rozszerzeń plików z odpowiednimi programami realizuje się za pomocą polecenia

Jakie oprogramowanie zabezpieczające przed nieautoryzowanym dostępem do sieci powinno być zainstalowane na serwerze, który udostępnia dostęp do internetu?

Jak określana jest transmisja w obie strony w sieci Ethernet?

Protokół SNMP (Simple Network Management Protocol) jest wykorzystywany do

Jakiego rodzaju adresację stosuje protokół IPv6?

Jeśli rozdzielczość myszki wynosi 200 dpi, a rozdzielczość monitora to Full HD, to aby przesunąć kursor w poziomie po ekranie, należy przemieścić mysz o

Jakie urządzenie pozwoli na podłączenie drukarki, która nie jest wyposażona w kartę sieciową, do lokalnej sieci komputerowej?

Główną metodą ochrony sieci komputerowej przed zewnętrznymi atakami jest wykorzystanie

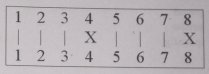

Jaki błąd w okablowaniu można dostrzec na ekranie testera, który pokazuje mapę połączeń żył kabla typu "skrętka"?

Jak skrót wskazuje na rozległą sieć komputerową, która obejmuje swoim zasięgiem miasto?

Martwy piksel, będący defektem monitorów LCD, to punkt, który trwa niezmiennie w kolorze