Pytanie 1

Dane z HDD, którego sterownik silnika SM jest uszkodzony, można odzyskać

Wynik: 29/40 punktów (72,5%)

Wymagane minimum: 20 punktów (50%)

Dane z HDD, którego sterownik silnika SM jest uszkodzony, można odzyskać

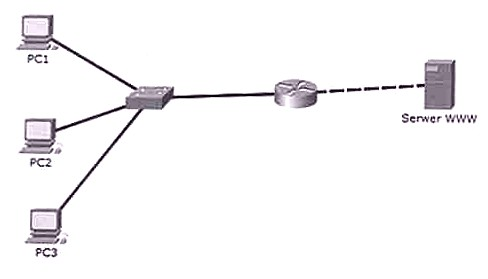

Użytkownicy w sieci lokalnej mogą się komunikować między sobą, lecz nie mają dostępu do serwera WWW. Wynik polecenia ping z komputerów bramy jest pozytywny. Który komponent sieci NIE MOŻE być powodem problemu?

Główną rolą serwera FTP jest

Aby w systemie Linux wykonać kopię zapasową określonych plików, należy wprowadzić w terminalu polecenie programu

Aby zweryfikować schemat połączeń kabla UTP Cat 5e w sieci lokalnej, należy zastosować

Urządzenie pokazane na ilustracji jest przeznaczone do

Gdy wykonanie polecenia ping 127.0.0.1 nie przynosi żadnej odpowiedzi, to

Jednym z narzędzi zabezpieczających system przed oprogramowaniem, które bez wiedzy użytkownika pozyskuje i wysyła jego autorowi dane osobowe, numery kart płatniczych, informacje o adresach stron WWW odwiedzanych przez użytkownika, hasła i używane adresy mailowe, jest program

Jakiego typu kopię zapasową należy wykonać, aby zarchiwizować wszystkie informacje, niezależnie od daty ich ostatniej archiwizacji?

Adapter USB do LPT może być użyty w przypadku braku kompatybilności złączy podczas podłączania starszych urządzeń

Protokół Transport Layer Security (TLS) jest rozwinięciem standardu

Osoba pragnąca wydrukować dokumenty w oryginale oraz w trzech egzemplarzach na papierze samokopiującym powinna zainwestować w drukarkę

Podaj standard interfejsu wykorzystywanego do przewodowego łączenia dwóch urządzeń.

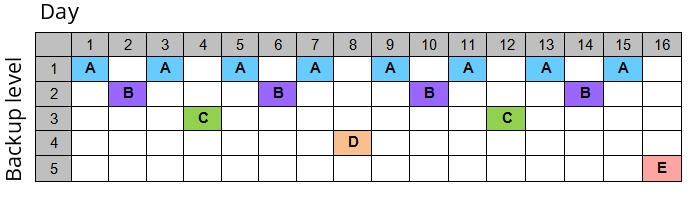

Strategia przedstawiona w diagramie dla tworzenia kopii zapasowych na nośnikach jest znana jako

W systemie Linux komenda chown pozwala na

Do przechowywania fragmentów dużych plików programów oraz danych, które nie mieszczą się w całości w pamięci, wykorzystywany jest

W dokumentacji jednego z komponentów komputera zawarto informację, że urządzenie obsługuje OpenGL. Jakiego elementu dotyczy ta dokumentacja?

Podaj właściwy sposób zapisu liczby -1210 w metodzie znak-moduł na ośmiobitowej liczbie binarnej.

Komputer K1 jest połączony z interfejsem G0 rutera, a komputer K2 z interfejsem G1 tego samego urządzenia. Na podstawie danych przedstawionych w tabeli, określ właściwy adres bramy dla komputera K2.

| Interfejs | Adres IP | Maska |

|---|---|---|

| G0 | 172.16.0.1 | 255.255.0.0 |

| G1 | 192.168.0.1 | 255.255.255.0 |

Które medium transmisyjne charakteryzuje się najmniejszym ryzykiem narażenia na zakłócenia elektromagnetyczne przesyłanego sygnału?

Przy realizacji projektu dotyczącego sieci LAN wykorzystano medium transmisyjne standardu Ethernet 1000Base-T. Które z poniższych stwierdzeń jest prawdziwe?

Do właściwego funkcjonowania procesora konieczne jest podłączenie złącza zasilania 4-stykowego lub 8-stykowego o napięciu

Na zamieszczonym zdjęciu widać

Metoda przesyłania danych pomiędzy urządzeniami CD/DVD a pamięcią komputera w trybie bezpośredniego dostępu do pamięci to

ACPI to akronim, który oznacza

Typ systemu plików, który nie obsługuje tworzenia wewnętrznego rejestru zmian, zwanego księgowaniem, to

Usługa w systemie Windows Server, która umożliwia zdalną instalację systemów operacyjnych na komputerach zarządzanych przez serwer, to

W sekcji zasilania monitora LCD, powiększone kondensatory elektrolityczne mogą prowadzić do uszkodzenia

Przedstawiony skaner należy podłączyć do komputera przy użyciu złącza

Jak najlepiej chronić zebrane dane przed dostępem w przypadku kradzieży komputera?

Na podstawie wyników działania narzędzia diagnostycznego chkdsk, które są przedstawione na zrzucie ekranu, jaka jest wielkość pojedynczego klastra na dysku?

Typ systemu plików to FAT32.

Wolumin FTP utworzono 12-11-2005 18:31

Numer seryjny woluminu: 3CED-3B31

Trwa sprawdzanie plików i folderów...

Zakończono sprawdzanie plików i folderów.

Trwa sprawdzanie wolnego miejsca na dysku...

Zakończono sprawdzanie wolnego miejsca na dysku.

System Windows sprawdził system plików i nie znalazł żadnych problemów.

8 233 244 KB całkowitego miejsca na dysku.

1 KB w 13 plikach ukrytych.

2 KB w 520 folderach.

1 537 600 KB w 4 952 plikach.

6 690 048 KB jest dostępnych.

4 096 bajtów w każdej jednostce alokacji.

2 058 311 ogółem jednostek alokacji na dysku.

1 672 512 jednostek alokacji dostępnych na dysku.

C:\>

Aby zweryfikować adresy MAC komputerów, które są połączone z przełącznikiem, można zastosować następujące polecenie

Adres MAC (Medium Access Control Address) stanowi fizyczny identyfikator interfejsu sieciowego Ethernet w obrębie modelu OSI

Zanim zainstalujesz sterownik dla urządzenia peryferyjnego, system operacyjny Windows powinien weryfikować, czy sterownik ma ważny podpis

Aby przekształcić zeskanowany obraz w tekst, należy użyć oprogramowania, które wykorzystuje metody

Aplikacją systemu Windows, która umożliwia analizę wpływu różnych procesów i usług na wydajność CPU oraz oceny stopnia obciążenia pamięci i dysku, jest

Pamięć, która nie traci danych, może być elektrycznie kasowana i programowana, znana jest pod skrótem

Jakie polecenie w systemie Linux przyzna możliwość zapisu dla wszystkich obiektów w /usr/share dla wszystkich użytkowników, nie modyfikując innych uprawnień?

Postcardware to typ

CommView oraz WireShark to aplikacje wykorzystywane do