Pytanie 1

Aby zapobiec utracie danych w programie obsługi przychodni, należy codziennie wykonywać

Wynik: 1/40 punktów (2,5%)

Wymagane minimum: 20 punktów (50%)

Aby zapobiec utracie danych w programie obsługi przychodni, należy codziennie wykonywać

Pierwszym krokiem podczas prac serwisowych wymagających modyfikowania rejestru w systemie Windows jest wykonanie

Które polecenie SQL pozwoli na utworzenie tabeli pacjentów w bazie przychodnia?

Który z przedstawionych przyrządów służy do testowania połączeń w sieci LAN?

W instrukcji systemu do skanowania dokumentacji medycznej zapisano, że umożliwia wykorzystanie systemu OCR, który służy do

W dokumentacji testera aparatury medycznej podano następujące informacje:

|

Brak odpowiedzi na to pytanie.

Które polecenie SQL nie modyfikuje tabeli bazy danych?

Brak odpowiedzi na to pytanie.

Który rozdzielacz sygnału należy zastosować w celu wykorzystania jednego przewodu U/UTP5e do podłączenia dwóch urządzeń do sieci LAN?

Brak odpowiedzi na to pytanie.

Który zasilacz pozwala na tymczasowe utrzymanie zasilania akumulatorowego w razie braku zasilania sieciowego?

Brak odpowiedzi na to pytanie.

Na którym rysunku przedstawiony jest interfejs zapewniający najwyższą prędkość transferu urządzeń elektroniki medycznej?

Brak odpowiedzi na to pytanie.

Na rysunku przedstawiono kartę rozszerzeń umożliwiającą

Brak odpowiedzi na to pytanie.

Jeżeli węzeł zatokowo–przedsionkowy będzie pobudzał serce generując bodźce elektryczne z częstotliwością 1 Hz, to wartość rytmu serca będzie wynosiła

Brak odpowiedzi na to pytanie.

Podstawowym elementem sztucznej nerki jest pompa do przetłaczania krwi, zwana

Brak odpowiedzi na to pytanie.

Najważniejszą cechą pamięci operacyjnych serwerowych jest ich niezawodność, dlatego powinny być wyposażone w mechanizm kontroli błędów określany skrótem

Brak odpowiedzi na to pytanie.

Pod wpływem bodźca świetlnego, dźwiękowego lub czuciowego mózg generuje elektryczne potencjały wywołane rejestrowane przez

Brak odpowiedzi na to pytanie.

Pojęcie „Architektura Harvardska” odnosi się do

Brak odpowiedzi na to pytanie.

Programowanie obiektowe wykorzystuje dziedziczenie, które polega na

Brak odpowiedzi na to pytanie.

Do badań ultrasonograficznych struktur płytko położonych (np. tarczycy) stosuje się głowicę

Brak odpowiedzi na to pytanie.

Na zdjęciu RTG najjaśniejsze pole stanowi tkanka kostna, przez którą promieniowanie rentgenowskie jest

Brak odpowiedzi na to pytanie.

Największą zdolność pochłaniania promieniowania rentgenowskiego o energii 60–160 keV wykazuje tkanka

Brak odpowiedzi na to pytanie.

Która tkanka najsilniej pochłania fale ultradźwiękowe?

Brak odpowiedzi na to pytanie.

Przedstawione na rysunku i opisane w ramce narzędzie służy do ściągania izolacji

| Stripper posiada trzy otwory. Pierwszy pozwala na ściągnięcie płaszcza 250 μm do 125 μm. Drugi otwór przeznaczony jest do ściągania powłoki 900 μm do płaszcza o średnicy 250 μm. Trzeci służy do ściągania powłoki z kabli o średnicy 2 mm ÷ 3 mm do ścisłej tuby o średnicy 900 μm. |

Brak odpowiedzi na to pytanie.

W celu rejestracji promieniowania radioizotopu nagromadzonego w narządach stosowana jest

Brak odpowiedzi na to pytanie.

Katalog /dev w Linuxie zawiera pliki

Brak odpowiedzi na to pytanie.

Na rysunku przedstawiono badanie za pomocą

Brak odpowiedzi na to pytanie.

Operacje stałoprzecinkowe w procesorze wykonuje jednostka oznaczona jako

Brak odpowiedzi na to pytanie.

Które polecenie SQL służy do utworzenia bazy danych?

Brak odpowiedzi na to pytanie.

Które ustawienie należy wybrać na multimetrze w celu pomiaru napięcia 12 V w obwodzie prądu stałego?

Brak odpowiedzi na to pytanie.

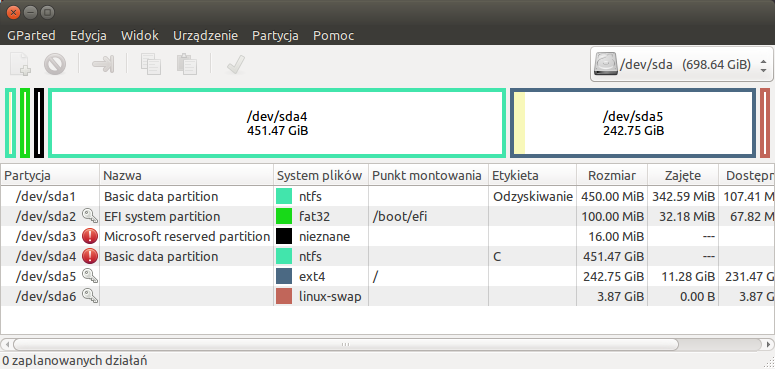

Ile dysków i z jakim interfejsem zostało wykazanych na zrzucie programu GParted?

Brak odpowiedzi na to pytanie.

Zmienne definiowane w programie głównym na zewnątrz wszystkich funkcji i procedur lub innych bloków programu określamy jako zmienne

Brak odpowiedzi na to pytanie.

Który z nośników danych umożliwia wielokrotny zapis i ma największą pojemność?

Brak odpowiedzi na to pytanie.

Która konsola MMC pozwala na zmianę ważności hasła i ustawienie blokady hasła po określonej liczbie logowań?

Brak odpowiedzi na to pytanie.

Podczas uruchamiania komputera procedura POST testuje poprawność działania

Brak odpowiedzi na to pytanie.

Który przyrząd należy wybrać celem sprawdzenia poprawnej prędkości transmisji danych na łączu RS232 urządzenia elektroniki medycznej?

Brak odpowiedzi na to pytanie.

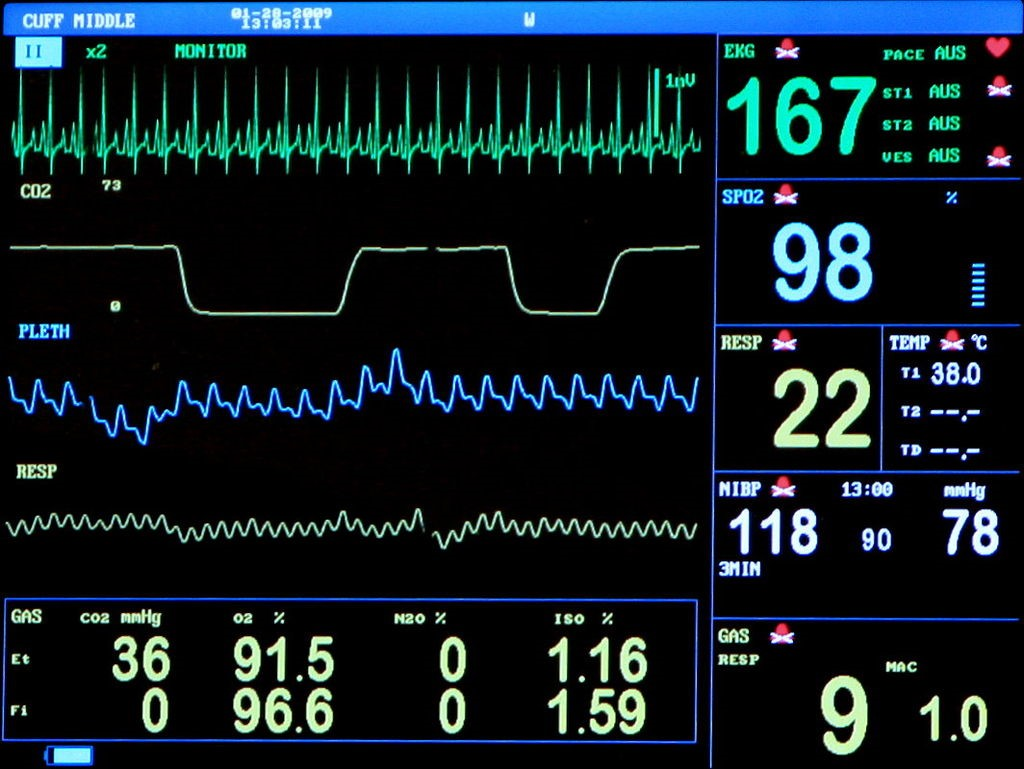

Z ekranu urządzenia wynika, że pełni ono między innymi funkcję

Brak odpowiedzi na to pytanie.

Dla sieci o adresie 192.150.160.0/26 pula adresów IP dla urządzeń w tej sieci zawiera się w zakresie

Brak odpowiedzi na to pytanie.

Płyta jednostronna dwuwarstwowa DVD pozwala na przechowanie danych o pojemności około

Brak odpowiedzi na to pytanie.

W dokumentacji Medycznego Systemu Informatycznego zapisano, że „przed użyciem programów instalacyjnych należy się upewnić, że niektóre porty w środowisku są dostępne do użycia z instalowanym oprogramowaniem pośrednim.” W celu sprawdzenia dostępności portu należy użyć programu narzędziowego

Brak odpowiedzi na to pytanie.

Który system plików zapewnia największe bezpieczeństwo danych w systemie Windows?

Brak odpowiedzi na to pytanie.

Jeżeli procesor graficzny wykonuje także operacje arytmetyczne, oznacza to, że pracuje w architekturze

Brak odpowiedzi na to pytanie.