Pytanie 1

Serwis serwerowy, który pozwala na udostępnianie usług drukowania w systemie Linux oraz plików dla stacji roboczych Windows, to

Wynik: 15/40 punktów (37,5%)

Wymagane minimum: 20 punktów (50%)

Serwis serwerowy, który pozwala na udostępnianie usług drukowania w systemie Linux oraz plików dla stacji roboczych Windows, to

Jakie polecenie w systemie Linux pozwala na dodanie istniejącego użytkownika nowak do grupy technikum?

Czym jest odwrotność bezstratnego algorytmu kompresji danych?

W cenniku usług informatycznych znajdują się poniższe wpisy. Jaki będzie koszt dojazdu serwisanta do klienta, który mieszka poza miastem, w odległości 15km od siedziby firmy?

| Dojazd do klienta na terenie miasta – 25 zł netto |

| Dojazd do klienta poza miastem – 2 zł netto za każdy km odległości od siedziby firmy liczony w obie strony. |

Jakie zakresy zostaną przydzielone przez administratora do adresów prywatnych w klasie C, przy użyciu maski 24 bitowej dla komputerów w lokalnej sieci?

Jakim protokołem komunikacyjnym, który gwarantuje niezawodne przesyłanie danych, jest protokół

Którego narzędzia można użyć, aby prześledzić trasę, którą pokonują pakiety w sieciach?

Skrót określający translację adresów w sieciach to

Powszechnie stosowana forma oprogramowania, która funkcjonuje na zasadzie "najpierw wypróbuj, a potem kup", to

Do jakiego pomiaru wykorzystywany jest watomierz?

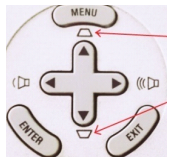

Na przedstawionej grafice wskazano strzałkami funkcje przycisków umieszczonych na obudowie projektora multimedialnego. Dzięki tym przyciskom można

Jakie jest nominalne wyjście mocy (ciągłe) zasilacza o parametrach przedstawionych w tabeli?

| Napięcie wyjściowe | +5 V | +3.3 V | +12 V1 | +12 V2 | -12 V | +5 VSB |

|---|---|---|---|---|---|---|

| Prąd wyjściowy | 18,0 A | 22,0 A | 18,0 A | 17,0 A | 0,3 A | 2,5 A |

| Moc wyjściowa | 120 W | 336 W | 3,6 W | 12,5 W |

Symbol przedstawiony na ilustracji oznacza rodzaj złącza

Co należy zrobić przed przystąpieniem do prac serwisowych związanych z edytowaniem rejestru systemu Windows?

Jednym z rezultatów realizacji podanego polecenia jest

| sudo passwd -n 1 -x 5 test |

Narzędziem systemu Windows, służącym do sprawdzenia wpływu poszczególnych procesów i usług na wydajność procesora oraz tego, w jakim stopniu generują one obciążenie pamięci czy dysku, jest

Protokołem umożliwiającym bezpołączeniowe przesyłanie datagramów jest

Wskaż nośnik, który w sieciach komputerowych umożliwia najszybszą wymianę danych?

W jakim systemie jest przedstawiona liczba 1010(o)?

Który standard Gigabit Ethernet pozwala na tworzenie segmentów sieci o długości 550 m lub 5000 m przy prędkości transmisji 1 Gb/s?

Jaki zapis w systemie binarnym odpowiada liczbie 111 w systemie dziesiętnym?

Aby dostęp do systemu Windows Serwer 2016 był możliwy dla 50 urządzeń, bez względu na liczbę użytkowników, należy w firmie zakupić licencję

Komunikat "BIOS checksum error" pojawiający się podczas uruchamiania komputera zazwyczaj wskazuje na

System S.M.A.R.T. jest wykorzystywany do nadzorowania działania oraz identyfikacji usterek

Który z protokołów pełni rolę protokołu połączeniowego?

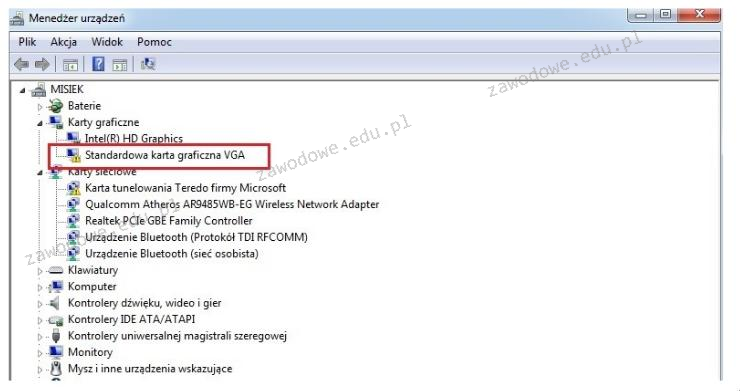

Na ilustracji widoczny jest komunikat systemowy. Jaką czynność powinien wykonać użytkownik, aby naprawić występujący błąd?

RAMDAC konwerter przekształca sygnał

W filmie przedstawiono konfigurację ustawień maszyny wirtualnej. Wykonywana czynność jest związana z

Na 16 bitach możemy przechować

Adres IP 192.168.2.0/24 został podzielony na cztery mniejsze podsieci. Jaką maskę mają te nowe podsieci?

Jakie są prędkości przesyłu danych w sieciach FDDI (ang. Fiber Distributed Data Interface) wykorzystujących technologię światłowodową?

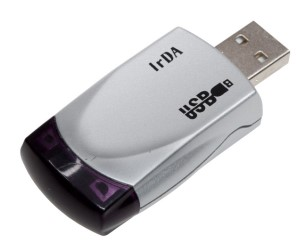

Wskaż urządzenie, które należy wykorzystać do połączenia drukarki wyposażonej w interfejs Wi-Fi z komputerem stacjonarnym bez interfejsu Wi-Fi, ale z interfejsem USB.

W podejściu archiwizacji danych określanym jako Dziadek – Ojciec – Syn na poziomie Dziadek wykonuje się kopię danych na koniec

Medium transmisyjne, które jest odporne na zakłócenia elektromagnetyczne i atmosferyczne, to

Jakie urządzenie powinno zostać wykorzystane do podłączenia komputerów, aby mogły funkcjonować w odrębnych domenach rozgłoszeniowych?

Cechą charakterystyczną transmisji za pomocą interfejsu równoległego synchronicznego jest to, że

Jaką normę wykorzystuje się przy okablowaniu strukturalnym w komputerowych sieciach?

Jak nazywa się współpracujące z monitorami CRT urządzenie wskazujące z końcówką wyposażoną w światłoczuły element, która poprzez dotknięcie ekranu monitora powoduje przesłanie sygnału do komputera, umożliwiając w ten sposób lokalizację kursora?

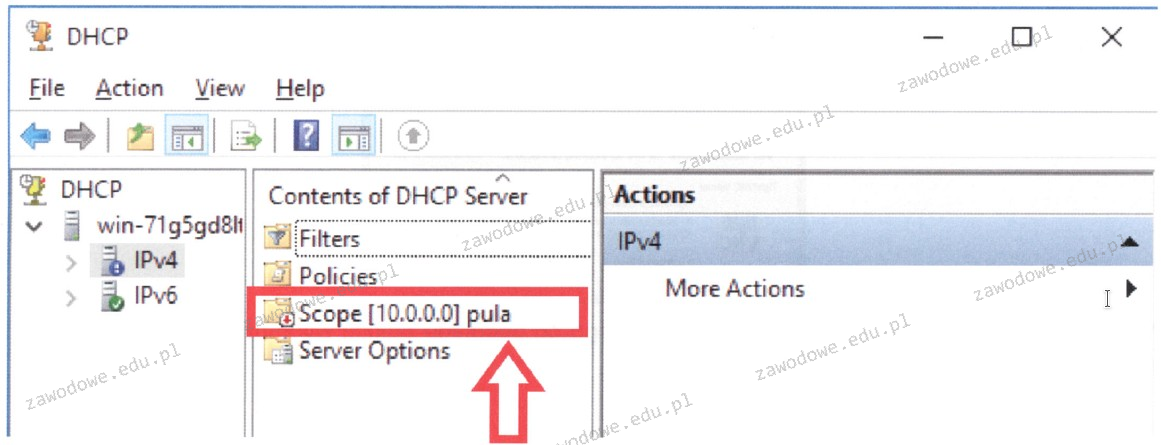

W systemie serwerowym Windows widoczny jest zakres adresów IPv4. Ikona umieszczona obok jego nazwy sugeruje, że

W systemach Windows profil użytkownika tymczasowego jest