Pytanie 1

Jakie jest tempo transferu danych dla napędu DVD przy prędkości x48?

Wynik: 24/40 punktów (60,0%)

Wymagane minimum: 20 punktów (50%)

Jakie jest tempo transferu danych dla napędu DVD przy prędkości x48?

Urządzenia wykorzystujące port USB 2.0 są zasilane napięciem, którego wartość znajduje się w przedziale

Wykorzystane kasety od drukarek powinny być

Jaka usługa, opracowana przez firmę Microsoft, pozwala na konwersję nazw komputerów na adresy URL?

Jakie polecenie służy do przeprowadzania aktualizacji systemu operacyjnego Linux korzystającego z baz RPM?

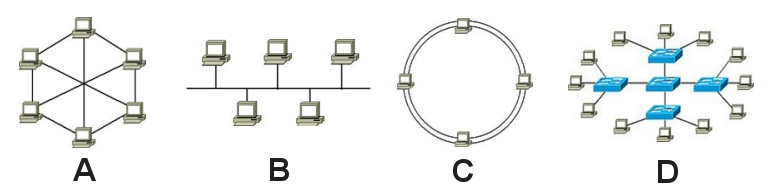

Który z rysunków ilustruje topologię sieci w układzie magistrali?

Monitor CRT jest podłączany do karty graficznej przy użyciu złącza

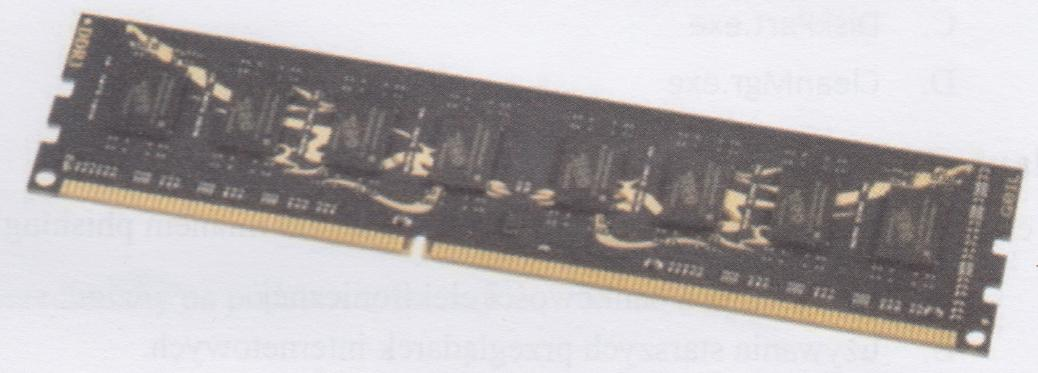

Pamięć RAM pokazana na ilustracji jest instalowana na płycie głównej posiadającej gniazdo

Które z urządzeń używanych w sieciach komputerowych nie modyfikuje liczby kolizyjnych domen?

CommView oraz WireShark to aplikacje wykorzystywane do

Jakie oprogramowanie nie jest przeznaczone do diagnozowania komponentów komputera?

W filmie przedstawiono konfigurację ustawień maszyny wirtualnej. Wykonywana czynność jest związana z

Aby oczyścić zablokowane dysze kartridża drukarki atramentowej, co należy zrobić?

Instalacja systemów Linux oraz Windows 7 odbyła się bez żadnych problemów. Systemy zainstalowały się prawidłowo z domyślnymi konfiguracjami. Na tym samym komputerze, przy tej samej specyfikacji, podczas instalacji systemu Windows XP pojawił się komunikat o braku dysków twardych, co może sugerować

Jaki jest maksymalny promień zgięcia przy montażu kabla U/UTP kat 5e?

W systemie Windows uruchomiono plik wsadowy z dwoma argumentami. Uzyskanie dostępu do wartości drugiego argumentu w pliku wsadowym jest możliwe przez

Wydanie w systemie Windows komendy ```ATTRIB -S +H TEST.TXT``` spowoduje

Aktywacja opcji OCR w procesie ustawiania skanera umożliwia

Jakim kolorem oznaczona jest izolacja żyły pierwszego pinu wtyku RJ45 w układzie połączeń T568A?

Ile adresów IP można wykorzystać do adresowania komputerów w sieci o adresie 192.168.100.0 oraz masce 255.255.255.0?

Narzędzie przedstawione do nadzorowania sieci LAN to

C:\Users\egzamin>nmap localhost Starting Nmap 7.80 ( https://nmap.org ) at 2019-11-26 20:23 ?rodkowoeuropejski czas stand. Nmap scan report for localhost (127.0.0.1) Host is up (0.00s latency). Other addresses for localhost (not scanned): ::1 Not shown: 988 closed ports PORT STATE SERVICE 135/tcp open msrpc 445/tcp open microsoft-ds 1025/tcp open NFS-or-IIS 1026/tcp open LSA-or-nterm 1027/tcp open IIS 1029/tcp open ms-lsa 1030/tcp open iad1 1031/tcp open iad2 1044/tcp open dcutility 1234/tcp open hotline 2869/tcp open icslap 16992/tcp open amt-soap-http Nmap done: 1 IP address (1 host up) scanned in 0.94 seconds

Atak DDoS (ang. Disributed Denial of Service) na serwer doprowadzi do

Cena wydruku jednej strony tekstu wynosi 95 gr, a koszt wykonania jednej płyty CD to 1,54 zł. Jakie wydatki poniesie firma, tworząc płytę z prezentacjami oraz poradnik liczący 120 stron?

Jakie oprogramowanie można wykorzystać do wykrywania problemów w pamięciach RAM?

Jaki rodzaj kabla powinien być użyty do połączenia komputera w obszarze podlegającym wpływom zakłóceń elektromagnetycznych?

Który z poniższych systemów operacyjnych nie jest wspierany przez system plików ext4?

Korzystając z programu Cipher, użytkownik systemu Windows ma możliwość

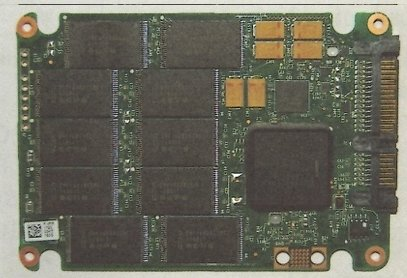

Element systemu komputerowego przedstawiony na ilustracji to

Który z parametrów czasowych w pamięci RAM określany jest jako czas dostępu?

Użytkownik chce zabezpieczyć mechanicznie dane na karcie pamięci przed przypadkowym skasowaniem. Takie zabezpieczenie umożliwia karta

Aby zainstalować serwer FTP w systemach z rodziny Windows Server, konieczne jest dodanie roli serwera

Technologia ADSL pozwala na nawiązanie połączenia DSL

W celu zainstalowania systemu openSUSE oraz dostosowania jego ustawień, można skorzystać z narzędzia

Aby zweryfikować schemat połączeń kabla UTP Cat 5e w sieci lokalnej, należy zastosować

Komputer wyposażony w BIOS firmy Award wygenerował komunikat o treści Primary/Secondary master/slave hard disk fail. Komunikat ten może oznaczać konieczność wymiany

Kto jest odpowiedzialny za alokację czasu procesora dla konkretnych zadań?

W systemie Windows aktualne ustawienia użytkownika komputera przechowywane są w gałęzi rejestru o skrócie

Funkcja systemu operacyjnego, która umożliwia jednoczesne uruchamianie wielu aplikacji w trybie podziału czasu, z tym że realizacja tego podziału odbywa się przez same aplikacje, nosi nazwę

Użytkownik systemu Windows napotyka komunikaty o zbyt małej ilości pamięci wirtualnej. W jaki sposób można rozwiązać ten problem?

Komputer zarejestrowany w domenie Active Directory nie ma możliwości połączenia się z kontrolerem domeny, na którym znajduje się profil użytkownika. Jaki rodzaj profilu użytkownika zostanie utworzony na tym urządzeniu?