Pytanie 1

Które z poniższych stwierdzeń NIE odnosi się do pamięci cache L1?

Wynik: 36/40 punktów (90,0%)

Wymagane minimum: 20 punktów (50%)

Które z poniższych stwierdzeń NIE odnosi się do pamięci cache L1?

Na podstawie filmu wskaż z ilu modułów składa się zainstalowana w komputerze pamięć RAM oraz jaką ma pojemność.

Na komputerze klienckim z systemem Windows XP plik "hosts" to plik tekstowy, który wykorzystywany jest do przypisywania

Wskaż złącze, które nie jest obecne w zasilaczach ATX?

Przy realizacji projektu dotyczącego sieci LAN wykorzystano medium transmisyjne standardu Ethernet 1000Base-T. Które z poniższych stwierdzeń jest prawdziwe?

Jakie urządzenie można kontrolować pod kątem parametrów za pomocą S.M.A.R.T.?

Najbardziej rozwinięty tryb funkcjonowania portu równoległego zgodnego z normą IEEE-1284, który tworzy dwukierunkową szeregę 8-bitową zdolną do przesyłania zarówno danych, jak i adresów z maksymalną prędkością transmisji wynoszącą 2,3 MB/s oraz umożliwia podłączenie do 64 urządzeń, to

Na którym schemacie znajduje się panel krosowniczy?

Jakie narzędzie służy do połączenia pigtaila z włóknami światłowodowymi?

Jakie narzędzie służy do delikatnego wyginania blachy obudowy komputera oraz przykręcania śruby montażowej w miejscach trudno dostępnych?

Protokół ARP (Address Resolution Protocol) służy do konwersji adresu IP na

Które z urządzeń może powodować wzrost liczby kolizji pakietów w sieci?

Zrzut ekranu ilustruje wynik polecenia arp -a. Jak należy zrozumieć te dane?

W doborze zasilacza do komputera kluczowe znaczenie

W systemie Linux wykonanie komendy passwd Ala spowoduje

Równoważnym zapisem 232 bajtów jest zapis

Na płycie głównej z chipsetem Intel 865G

Ile par kabli jest używanych w standardzie 100Base-TX do obustronnej transmisji danych?

W systemie Linux narzędzie fsck służy do

Jakie urządzenie powinno się zastosować do przeprowadzenia testu POST dla komponentów płyty głównej?

Po przeanalizowaniu wyników testu dysku twardego, jakie czynności powinny zostać wykonane, aby zwiększyć jego wydajność?

| Wolumin (C:) | ||

| Rozmiar woluminu | = | 39,06 GB |

| Rozmiar klastra | = | 4 KB |

| Zajęte miejsce | = | 27,48 GB |

| Wolne miejsce | = | 11,58 GB |

| Procent wolnego miejsca | = | 29 % |

| Fragmentacja woluminu | ||

| Fragmentacja całkowita | = | 15 % |

| Fragmentacja plików | = | 31 % |

| Fragmentacja wolnego miejsca | = | 0 % |

Zatrzymując pracę na komputerze, możemy szybko wznowić działania po wybraniu w systemie Windows opcji

Zamontowany w notebooku trackpoint jest urządzeniem wejściowym reagującym na

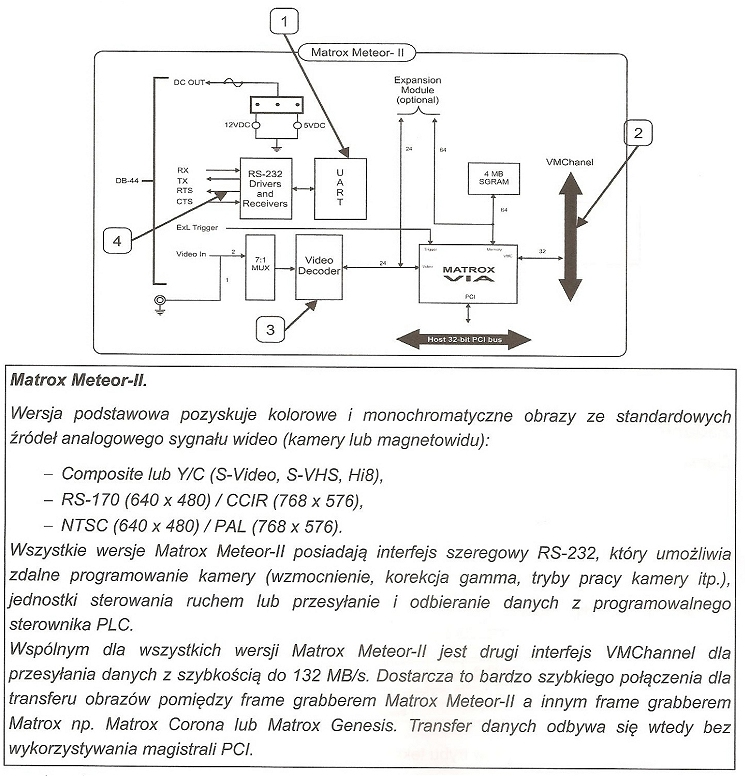

Który z elementów oznaczonych numerami od 1 do 4, ukazanych na schemacie blokowym frame grabbera oraz opisanych w fragmencie dokumentacji technicznej, jest odpowiedzialny za wymianę danych z innymi urządzeniami przetwarzającymi obraz wideo, unikając zbędnego obciążenia magistrali PCI?

Określenie najbardziej efektywnej trasy dla połączenia w sieci to

Zastąpienie koncentratorów przełącznikami w sieci Ethernet doprowadzi do

Jak sprawdzić, który z programów w systemie Windows generuje największe obciążenie dla procesora?

Aby dezaktywować transmitowanie nazwy sieci Wi-Fi, należy w punkcie dostępowym wyłączyć opcję

Co oznacza skrót 'RAID' w kontekście systemów komputerowych?

Jakie zastosowanie ma narzędzie tracert w systemach operacyjnych rodziny Windows?

Jaki typ złącza powinien być zastosowany w przewodzie UTP Cat 5e, aby połączyć komputer z siecią?

Do umożliwienia komunikacji pomiędzy sieciami VLAN, wykorzystuje się

Czym jest odwrotność bezstratnego algorytmu kompresji danych?

Czym jest klaster komputerowy?

Cienki klient (thin client) to?

Jaką maskę podsieci należy wybrać dla sieci numer 1 oraz sieci numer 2, aby urządzenia z podanymi adresami mogły komunikować się w swoich podsieciach?

| sieć nr 1 | sieć nr 2 | |

|---|---|---|

| 1 | 10.12.0.12 | 10.16.12.5 |

| 2 | 10.12.12.5 | 10.16.12.12 |

| 3 | 10.12.5.12 | 10.16.12.10 |

| 4 | 10.12.5.18 | 10.16.12.16 |

| 5 | 10.12.16.5 | 10.16.12.20 |

Polecenie Gpresult

W celu zainstalowania serwera proxy w systemie Linux, należy wykorzystać oprogramowanie

Elementem, który umożliwia wymianę informacji pomiędzy procesorem a magistralą PCI-E, jest

Jaką minimalną ilość pamięci RAM musi mieć komputer, aby móc uruchomić 64-bitowy system operacyjny Windows 7 w trybie graficznym?