Pytanie 1

Podłączona mysz bezprzewodowa sprawia, że kursor na ekranie nie porusza się płynnie i „skacze”. Co może być przyczyną tego problemu?

Wynik: 19/40 punktów (47,5%)

Wymagane minimum: 20 punktów (50%)

Podłączona mysz bezprzewodowa sprawia, że kursor na ekranie nie porusza się płynnie i „skacze”. Co może być przyczyną tego problemu?

Jakim środkiem należy oczyścić wnętrze obudowy drukarki fotograficznej z kurzu?

Po włączeniu komputera wyświetlił się komunikat "Non-system disk or disk error. Replace and strike any key when ready". Może to być spowodowane

Aby uporządkować dane pliku na dysku twardym, zapisane w klastrach, które nie sąsiadują ze sobą, tak aby znajdowały się w sąsiadujących klastrach, należy przeprowadzić

W systemie Windows powiązanie rozszerzeń plików z odpowiednimi programami realizuje się za pomocą polecenia

Użytkownik systemu Windows wybrał opcję powrót do punktu przywracania. Które pliki powstałe po wybranym punkcie nie zostaną naruszone przez tę akcję?

Zarządzanie partycjami w systemach operacyjnych Windows

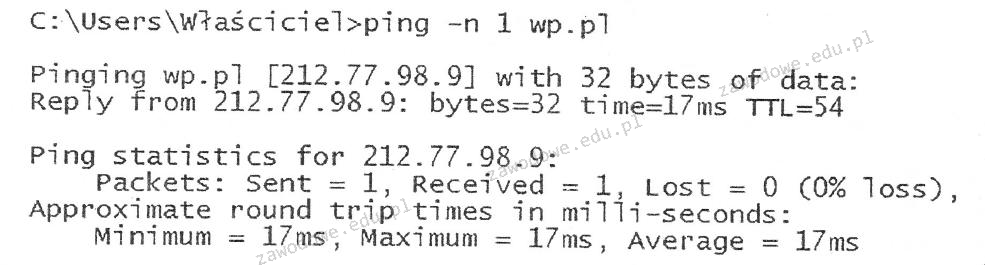

W wyniku realizacji podanego polecenia ping parametr TTL wskazuje na

Pamięć, która działa jako pośrednik pomiędzy pamięcią operacyjną a procesorem o dużej prędkości, to

Które polecenie pozwala na mapowanie zasobów sieciowych w systemie Windows Serwer?

Jakie znaczenie ma parametr NVP (Nominal Velocity of Propagation) podczas pomiarów okablowania strukturalnego?

Rodzaj przesyłania danych do jednego lub wielu komputerów jednocześnie, w którym odbiorcy są postrzegani przez nadawcę jako jedyny zbiorczy odbiorca, to

Jakie narzędzie w systemie Linux pozwala na wyświetlenie danych o sprzęcie zapisanych w BIOS?

Niskopoziomowe formatowanie dysku IDE HDD polega na

W sieci o adresie 192.168.20.0 użyto maski podsieci 255.255.255.248. Jak wiele adresów IP będzie dostępnych dla urządzeń?

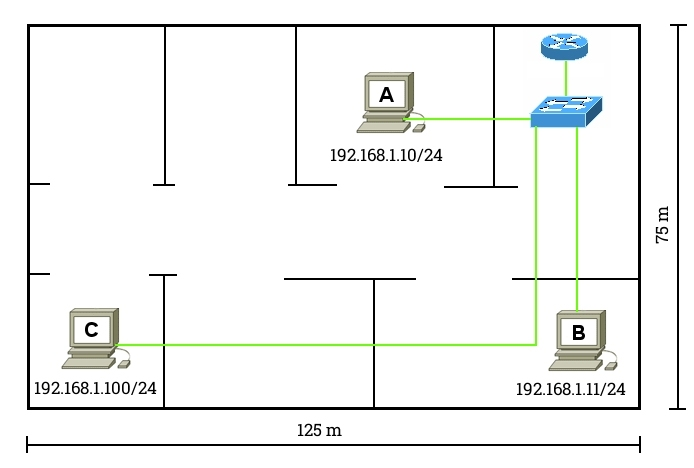

Na schemacie pokazano sieć LAN wykorzystującą okablowanie kategorii 6. Stacja robocza C nie może nawiązać połączenia z siecią. Jaki problem warstwy fizycznej może być przyczyną braku komunikacji?

W systemie Windows do przeprowadzania aktualizacji oraz przywracania sterowników sprzętowych należy wykorzystać narzędzie

Aby stworzyć nowego użytkownika o nazwie egzamin z hasłem qwerty w systemie Windows XP, należy wykorzystać polecenie

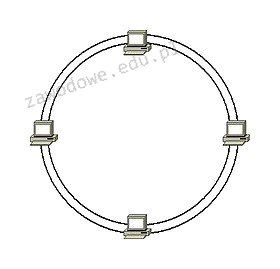

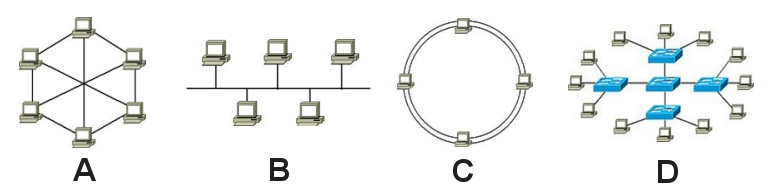

Jaką topologię fizyczną sieci komputerowej przedstawia załączony rysunek?

Jakie informacje można uzyskać za pomocą programu Wireshark?

Który z protokołów umożliwia szyfrowanie połączenia?

Jak nazywa się materiał używany w drukarkach 3D?

Na podstawie danych przedstawionych w tabeli dotyczącej twardego dysku, ustal, który z wniosków jest poprawny?

Kasety z drukarek po zakończeniu użytkowania powinny zostać

Dezaktywacja automatycznych aktualizacji systemu Windows skutkuje

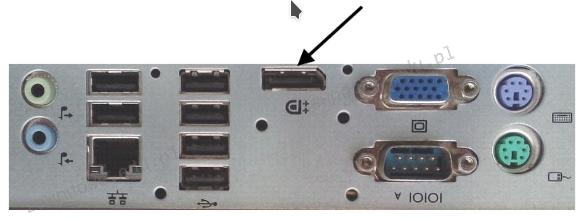

Na ilustracji ukazany jest tylny panel stacji roboczej. Strzałką wskazano port

Na stabilność obrazu w monitorach CRT istotny wpływ ma

Pliki specjalne urządzeń, tworzone podczas instalacji sterowników w systemie Linux, są zapisywane w katalogu

Narzędzie służące do przechwytywania oraz ewentualnej analizy ruchu w sieci to

Wtyczka zaprezentowana na fotografii stanowi element obwodu elektrycznego zasilającego

Monolityczne jądro (kernel) występuje w którym systemie?

Aby Jan mógł zmienić właściciela drukarki w systemie Windows, musi mu zostać przypisane prawo do w opcjach zabezpieczeń

Czym charakteryzuje się atak typu hijacking na serwerze sieciowym?

Jakie polecenie w systemie operacyjnym Linux służy do monitorowania komunikacji protokołów TCP/IP lub innych przesyłanych lub odbieranych w sieci komputerowej, do której jest podłączony komputer użytkownika?

Aby określić rozmiar wolnej oraz zajętej pamięci RAM w systemie Linux, można skorzystać z polecenia

Który z rysunków ilustruje topologię sieci w układzie magistrali?

Jakie oznaczenie odnosi się do normy dotyczącej okablowania strukturalnego?

W sieci komputerowej działającej pod systemem Linux do udostępniania drukarek można zastosować serwer

Aby mieć możliwość tworzenia kont użytkowników, komputerów oraz innych obiektów, a także centralnego przechowywania informacji o nich, konieczne jest zainstalowanie na serwerze Windows roli

Częścią eksploatacyjną drukarki laserowej nie jest