Pytanie 1

Co to jest PWA (Progressive Web App)?

Wynik: 23/40 punktów (57,5%)

Wymagane minimum: 20 punktów (50%)

Co to jest PWA (Progressive Web App)?

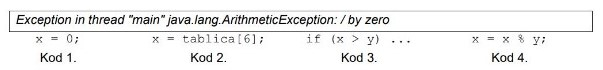

Jakiego kodu dotyczy treść wygenerowana w trakcie działania programu Java?

Jakie metody pozwalają na przesłanie danych z serwera do aplikacji front-end?

W zaprezentowanym fragmencie kodu występuje błąd logiczny. Na czym on polega?

int x = 0; while (x != 0 || x != 5) { std::cout << x << " "; x++; }

Co to jest kontener Docker?

Jakie korzyści płyną z użycia pseudokodu przy tworzeniu algorytmu?

Co to jest Service Worker w kontekście Progressive Web Apps?

Termin ryzyko zawodowe odnosi się do

Jednym z kroków przy publikacji aplikacji mobilnej w sklepie Google Play są testy Beta, które charakteryzują się tym, że są one

Który z wymienionych składników jest charakterystyczny dla środowiska IDE przeznaczonego do tworzenia aplikacji mobilnych?

Pierwszym krokiem w procesie tworzenia aplikacji jest

W jednostce centralnej, za obliczenia na liczbach zmiennoprzecinkowych odpowiada

Jakie jest fundamentalne zagadnienie w projektowaniu aplikacji w architekturze klient-serwer?

Do stworzenia zbioru danych potrzebnego do uruchomienia algorytmu sortowania bąbelkowego tablicy, wymagane są przynajmniej następujące typy:

Która z dokumentacji funkcji odpowiada przedstawionemu kodowi źródłowemu?

static int Abs(int liczba) { if (liczba < 0) liczba *= -1; return liczba; } | |

Dokumentacja 1: /******************* * nazwa: Abs * opis: liczy wartość bezwzględną * zwracana: brak * argumenty: liczba całkowita *******************/ | Dokumentacja 2: /******************* * nazwa: Abs * opis: liczy wartość bezwzględną * zwracana: wartość bezwzględna z liczby całkowitej * argumenty: liczba całkowita *******************/ |

Dokumentacja 3: /******************* * nazwa: Abs * opis: liczy potęgę liczby * zwracana: potęga z liczby całkowitej * argumenty: dwie liczby całkowite *******************/ | Dokumentacja 4: /******************* * nazwa: Abs * opis: liczy potęgę liczby * zwracana: potęga z liczby całkowitej * argumenty: liczba całkowita *******************/ |

Jakie elementy powinny być ujęte w dokumentacji programu?

Jak przedstawia się liczba dziesiętna 255 w systemie szesnastkowym?

Pętla przedstawiona w zadaniu działa na zmiennej typu string o nazwie ciag. Jej celem jest:

int i = 0; while (ciag[i] != 0) { if (ciag[i] > 96 && ciag[i] < 123) { ciag[i] = (ciag[i] - 32); } i++; }

Jakie polecenie w Gicie jest używane do zapisywania zmian w lokalnym repozytorium?

Co zostanie wyświetlone w konsoli po wykonaniu poniższego kodu?

let arr = [1, 2, 3, 4, 5]; let result = arr.filter(num => num % 2 === 0); console.log(result);

Jaką wydajność posiada sieć, która przesyła 500 MB danych w czasie 10 sekund?

Co to jest JWT (JSON Web Token)?

Zaproponowany fragment kodu w języku Java wypełnia tablicę elementami:

int[] tablica = new int [10]; int j = 2; for (int i = 0; i < 10; i++) { tablica[i] = j; j += 2; }

Jak nazywa się proces znajdowania i usuwania błędów w kodzie?

W jakiej fazie cyklu życia projektu informatycznego następuje integracja oraz testowanie wszystkich modułów systemu?

Jedną z dolegliwości, która pojawia się u programistów w wyniku długotrwałego korzystania z myszki komputerowej lub klawiatury, objawiającą się bólem, drętwieniem oraz zaburzeniami czucia w rejonie 1-3 palca ręki jest

Który z wymienionych dysków oferuje najszybszy dostęp do danych?

Która z wymienionych kart graficznych oferuje lepszą wydajność w grach komputerowych?

Która grupa typów zawiera wyłącznie typy złożone?

W zaprezentowanym wideo przedstawiono narzędzie do tworzenia interfejsu użytkownika, dla którego automatycznie generuje się

Które narzędzie najlepiej nadaje się do analizy wydajności aplikacji JavaScript?

Która z metod zarządzania projektem jest oparta na przyrostach realizowanych w sposób iteracyjny?

Które z poniższych twierdzeń najlepiej charakteryzuje metodę wirtualną?

Która z poniższych informacji o pojęciu obiekt jest prawdziwa?

Jakie kroki należy podjąć po wykryciu błędu w kodzie podczas testowania?

Który z wymienionych wzorców projektowych jest najbardziej odpowiedni do uproszczenia interfejsu złożonego systemu?

Z jakiej kolekcji powinno się korzystać, aby przechowywać informacje związane z elementem interfejsu użytkownika w taki sposób, aby ten element był informowany przez kolekcję o dodaniu, usunięciu lub zmianie jej zawartości?

Programista pragnie wybrać algorytm, który najszybciej przetwarza dane w jego aplikacji. Na podstawie złożoności obliczeniowej przedstawionej w tabeli, należy wskazać algorytm numer

| Algorytm 1 | O(n²) |

| Algorytm 2 | O(n!) |

| Algorytm 3 | O(n³) |

| Algorytm 4 | O(n) |

| Algorytm 5 | O(n²) |

Które z poniższych stwierdzeń jest prawdziwe w kontekście dziedziczenia w języku Java?

Wykorzystując jeden z dwóch zaprezentowanych sposobów inkrementacji w językach z rodziny C lub Java, można zauważyć, że

Zapis pierwszy:

b = a++;Zapis drugi:

b = ++a;