Pytanie 1

Jakie będzie rezultatem dodawania liczb 10011012 i 110012 w systemie binarnym?

Wynik: 19/40 punktów (47,5%)

Wymagane minimum: 20 punktów (50%)

Jakie będzie rezultatem dodawania liczb 10011012 i 110012 w systemie binarnym?

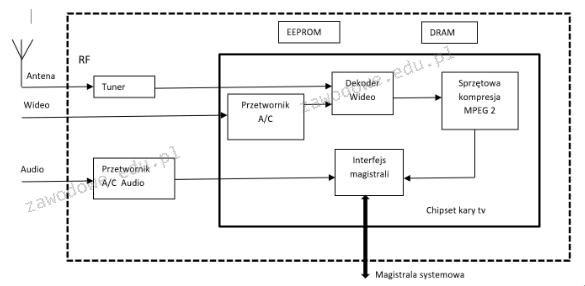

Na ilustracji przedstawiono diagram blokowy karty

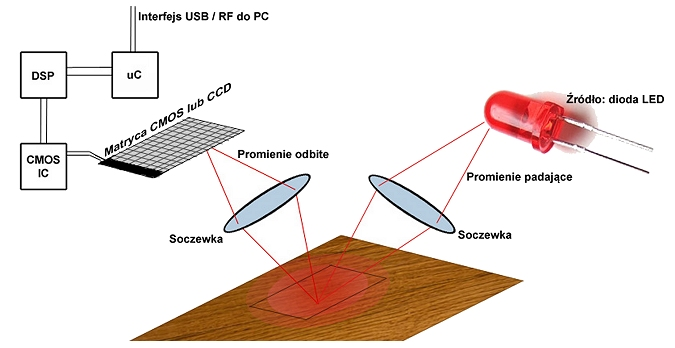

Zaprezentowany diagram ilustruje zasadę funkcjonowania

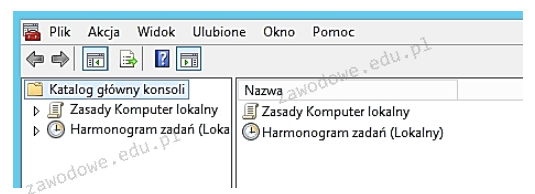

Aby otworzyć konsolę przedstawioną na ilustracji, należy wpisać w oknie poleceń

Możliwości zmiany uprawnień dostępu do plików w systemie Windows 10 można uzyskać za pomocą komendy

Jaki typ macierzy dyskowych zapewnia tak zwany mirroring dysków?

Który z rodzajów rekordów DNS w systemach Windows Server określa alias (inną nazwę) dla rekordu A związanej z kanoniczną (rzeczywistą) nazwą hosta?

Najlepszym sposobem na zabezpieczenie domowej sieci Wi-Fi jest

Zwiększenie zarówno wydajności operacji (zapis/odczyt), jak i bezpieczeństwa przechowywania danych jest możliwe dzięki zastosowaniu macierzy dyskowej

Mamy do czynienia z siecią o adresie 192.168.100.0/24. Ile podsieci można utworzyć, stosując maskę 255.255.255.224?

fps (ang. frames per second) odnosi się bezpośrednio do

Obudowa oraz wyświetlacz drukarki fotograficznej są bardzo brudne. Jakie środki należy zastosować, aby je wyczyścić?

Usługi na serwerze są konfigurowane za pomocą

W jaki sposób skonfigurować zaporę Windows, aby spełniała zasady bezpieczeństwa i umożliwiała użycie polecenia ping do weryfikacji komunikacji z innymi urządzeniami w sieci?

Pamięć, która nie traci danych, może być elektrycznie kasowana i programowana, znana jest pod skrótem

Po podłączeniu działającej klawiatury do jednego z portów USB nie ma możliwości wyboru awaryjnego trybu uruchamiania systemu Windows. Mimo to po uruchomieniu systemu w standardowym trybie klawiatura funkcjonuje prawidłowo. Co to oznacza?

Jaki protokół jest używany przez komendę ping?

Do weryfikacji integralności systemu plików w środowisku Linux trzeba zastosować polecenie

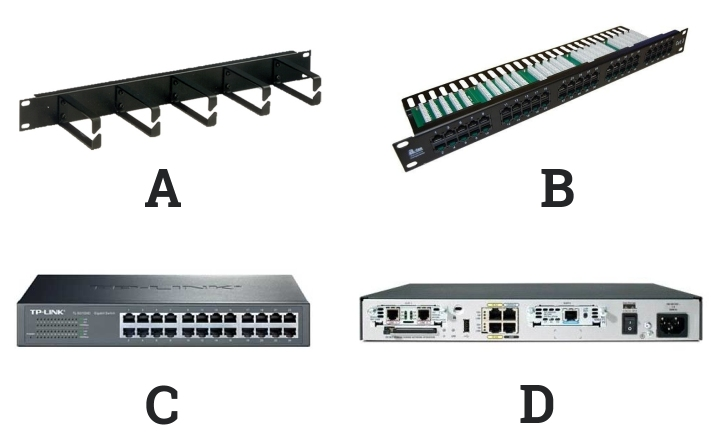

Na którym schemacie znajduje się panel krosowniczy?

Urządzenie przedstawione na ilustracji, wraz z podanymi danymi technicznymi, może być zastosowane do pomiarów systemów okablowania

Nazwa licencji oprogramowania komputerowego, które jest dystrybuowane bezpłatnie, lecz z ograniczoną przez twórcę funkcjonalnością w porównaniu do pełnej, płatnej wersji, gdzie po upływie 30 dni zaczynają się wyświetlać reklamy oraz przypomnienia o konieczności rejestracji, to

Komunikat tekstowy KB/Interface error, wyświetlony na ekranie komputera z BIOS POST firmy AMI, informuje o błędzie

Aby komputery mogły udostępniać swoje zasoby w sieci, muszą mieć przypisane różne

Koprocesor (Floating Point Unit) w systemie komputerowym jest odpowiedzialny za realizację

Czym charakteryzuje się technologia Hot swap?

Osobom pracującym zdalnie, dostęp do serwera znajdującego się w prywatnej sieci za pośrednictwem publicznej infrastruktury, jaką jest Internet, umożliwia

Aby zdalnie i jednocześnie bezpiecznie zarządzać systemem Linux, należy zastosować protokół

Ile pinów znajduje się w wtyczce SATA?

W dokumentacji jednego z komponentów komputera zawarto informację, że urządzenie obsługuje OpenGL. Jakiego elementu dotyczy ta dokumentacja?

Aktywacja opcji OCR w procesie ustawiania skanera umożliwia

Jakie polecenie w systemie Linux umożliwia wyświetlenie listy zawartości katalogu?

Jakie parametry można śledzić w przypadku urządzenia przy pomocy S.M.A.R.T.?

Aby zweryfikować schemat połączeń kabla UTP Cat 5e w sieci lokalnej, należy zastosować

Aby zweryfikować w systemie Windows działanie nowo zainstalowanej drukarki, co należy zrobić?

Podaj maksymalną liczbę hostów, które można przypisać w każdej z 8 równych podsieci, utworzonych z sieci o adresie 10.10.10.0/24.

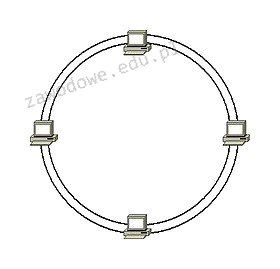

Jaką topologię fizyczną sieci komputerowej przedstawia załączony rysunek?

Użytkownik dysponuje komputerem o podanej konfiguracji i systemie Windows 7 Professional 32bit. Która z opcji modernizacji komputera NIE przyczyni się do zwiększenia wydajności?

| Płyta główna | ASRock Z97 Anniversary Z97 DualDDR3-1600 SATA3 RAID HDMI ATX z czterema slotami DDR3 i obsługą RAID poziomu 0,1 |

| Procesor | i3 |

| Pamięć | 1 x 4 GB DDR3 |

| HDD | 2 x 1 TB |

Złącze zasilacza ATX12V jest przeznaczone do zasilania

Jak nazywa się pamięć podręczna?

Aby system operacyjny mógł szybciej uzyskiwać dostęp do plików zapisanych na dysku twardym, konieczne jest wykonanie