Pytanie 1

W systemach operacyjnych Windows konto z najwyższymi uprawnieniami domyślnymi przynależy do grupy

Wynik: 8/40 punktów (20,0%)

Wymagane minimum: 20 punktów (50%)

W systemach operacyjnych Windows konto z najwyższymi uprawnieniami domyślnymi przynależy do grupy

Po przeanalizowaniu wyników testu dysku twardego, jakie czynności powinny zostać wykonane, aby zwiększyć jego wydajność?

| Wolumin (C:) | ||

| Rozmiar woluminu | = | 39,06 GB |

| Rozmiar klastra | = | 4 KB |

| Zajęte miejsce | = | 27,48 GB |

| Wolne miejsce | = | 11,58 GB |

| Procent wolnego miejsca | = | 29 % |

| Fragmentacja woluminu | ||

| Fragmentacja całkowita | = | 15 % |

| Fragmentacja plików | = | 31 % |

| Fragmentacja wolnego miejsca | = | 0 % |

Wykonanie polecenia tar -xf dane.tar w systemie Linux spowoduje

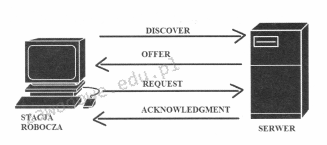

Którego protokołu działanie zostało zobrazowane na załączonym rysunku?

Spuchnięte kondensatory elektrolityczne w sekcji zasilania monitora LCD mogą spowodować uszkodzenie

Jaki adres stanowi adres rozgłoszeniowy dla hosta o IP 171.25.172.29 oraz masce sieci 255.255.0.0?

Jakie urządzenie ilustruje ten rysunek?

Jaką rolę pełni protokół DNS?

Najmniejszymi kątami widzenia charakteryzują się matryce monitorów typu

W jakiej warstwie modelu ISO/OSI wykorzystywane są adresy logiczne?

Na podstawie filmu wskaż z ilu modułów składa się zainstalowana w komputerze pamięć RAM oraz jaką ma pojemność.

Sygnatura (ciąg bitów) 55AA (w systemie szesnastkowym) kończy tablicę partycji. Jaka jest odpowiadająca jej wartość w systemie binarnym?

W systemie Linux komenda cd ~ umożliwia

Który typ profilu użytkownika zmienia się i jest zapisywany na serwerze dla klienta działającego w sieci Windows?

W sieciach bezprzewodowych typu Ad-Hoc IBSS (Independent Basic Service Set) wykorzystywana jest topologia fizyczna

Jakie narzędzie jest używane do zarządzania alokacjami dyskowymi w systemach Windows 7 i Windows 8?

Aby w edytorze Regedit przywrócić stan rejestru systemowego za pomocą wcześniej utworzonej kopii zapasowej, należy użyć funkcji

Jak na diagramach sieciowych LAN oznaczane są punkty dystrybucyjne znajdujące się na różnych kondygnacjach budynku, zgodnie z normą PN-EN 50173?

W skanerach z systemem CIS źródłem światła oświetlającym dokument jest

Głowica drukująca, składająca się z wielu dysz zintegrowanych z mechanizmem drukarki, wykorzystywana jest w drukarce

Jaki protokół stosują komputery, aby informować rutera o przynależności do konkretnej grupy multicastowej?

Podstawowym zadaniem mechanizmu Plug and Play jest

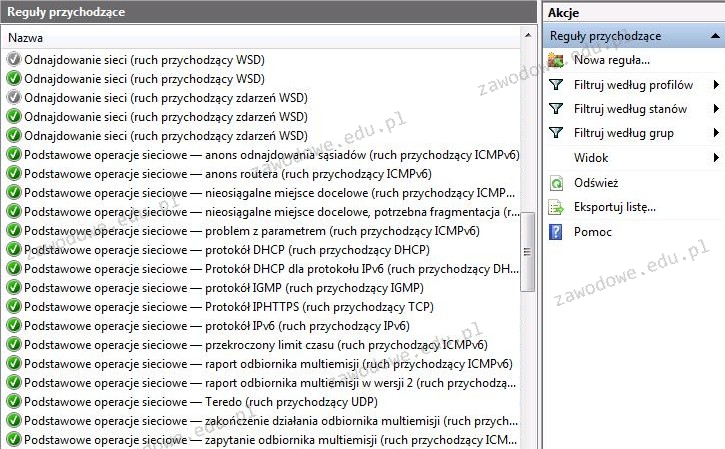

Zrzut ekranu ilustruje aplikację

Jakiego rodzaju złącze powinna mieć płyta główna, aby użytkownik był w stanie zainstalować kartę graficzną przedstawioną na rysunku?

Podczas uruchamiania komputera wyświetla się komunikat CMOS checksum error press F1 to continue, press Del to setup) naciśnięcie klawisza Del skutkuje

Zewnętrzny dysk 3,5 cala o pojemności 5 TB, przeznaczony do archiwizacji lub tworzenia kopii zapasowych, dysponuje obudową z czterema różnymi interfejsami komunikacyjnymi. Który z tych interfejsów powinno się użyć do podłączenia do komputera, aby uzyskać najwyższą prędkość transferu?

Aby zapobiec uszkodzeniu układów scalonych, podczas konserwacji sprzętu komputerowego należy używać

Zjawisko crosstalk, które występuje w sieciach komputerowych, polega na

Jakie narzędzie w systemie Windows służy do wykonania poleceń, wykorzystując logikę obiektową oraz cmdlety?

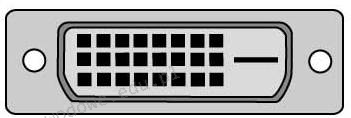

Jak brzmi nazwa portu umieszczonego na tylnym panelu komputera, który znajduje się na przedstawionym rysunku?

Po stwierdzeniu przypadkowego usunięcia ważnych danych na dysku twardym, aby odzyskać usunięte pliki, najlepiej

Aby zwiększyć wydajność komputera, można zainstalować procesor obsługujący technologię Hyper-Threading, która pozwala na

Jakie są przyczyny wyświetlenia na ekranie komputera komunikatu o wykryciu konfliktu adresów IP?

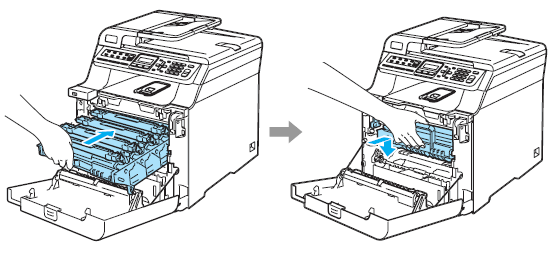

Czynność pokazana na rysunkach ilustruje mocowanie

Korzystając z podanego urządzenia, możliwe jest przeprowadzenie analizy działania

Koprocesor (Floating Point Unit) w systemie komputerowym jest odpowiedzialny za realizację

Na rysunku ukazany jest diagram blokowy zasilacza

Która edycja systemu operacyjnego Windows Server 2008 charakteryzuje się najuboższym interfejsem graficznym?

Jaki jest główny cel stosowania maski podsieci?

Do realizacji iloczynu logicznego z negacją należy użyć funktora