Pytanie 1

Jakie medium transmisyjne używają myszki Bluetooth do interakcji z komputerem?

Wynik: 17/40 punktów (42,5%)

Wymagane minimum: 20 punktów (50%)

Jakie medium transmisyjne używają myszki Bluetooth do interakcji z komputerem?

Jeżeli rozmiar jednostki alokacji wynosi 1024 bajty, to ile klastrów zajmą pliki umieszczone w tabeli na dysku?

| Nazwa | Wielkość |

|---|---|

| Ala.exe | 50 B |

| Dom.bat | 1024 B |

| Wirus.exe | 2 kB |

| Domes.exr | 350 B |

Podczas wyłączania systemu operacyjnego na monitorze pojawił się błąd, znany jako bluescreen 0x000000F3 Bug Check 0xF3 DISORDERLY_SHUTDOWN - nieudane zamykanie systemu, spowodowane niewystarczającą ilością pamięci. Co ten błąd może oznaczać?

Na podstawie analizy pakietów sieciowych, określ adres IP oraz numer portu, z którego urządzenie otrzymuje odpowiedź?

Do dynamicznej obsługi sprzętu w Linuxie jest stosowany system

Oprogramowanie, które często przerywa działanie przez wyświetlanie komunikatu o konieczności dokonania zapłaty, a które spowoduje zniknięcie tego komunikatu, jest dystrybuowane na podstawie licencji

Materiałem eksploatacyjnym, stosowanym w rzutniku multimedialnym, jest

Graficzny symbol odnosi się do standardów sprzętowych

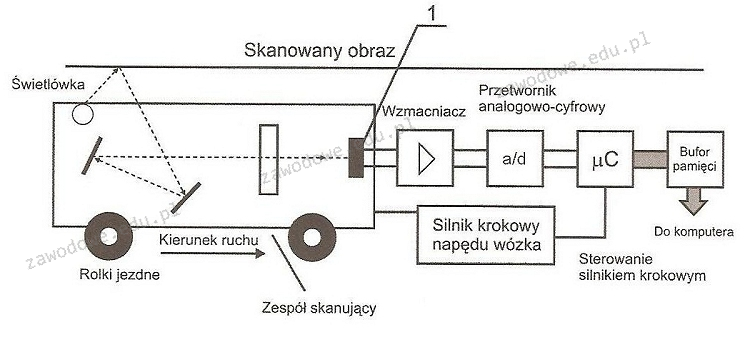

Na diagramie działania skanera, element oznaczony numerem 1 odpowiada za

W jakim oprogramowaniu trzeba zmienić konfigurację, aby użytkownik mógł wybrać z listy i uruchomić jeden z różnych systemów operacyjnych zainstalowanych na swoim komputerze?

Zasadniczym sposobem zabezpieczenia danych przechowywanych na serwerze jest

Jakie są korzyści płynące z użycia systemu plików NTFS?

Oprogramowanie, które jest dodatkiem do systemu Windows i ma na celu ochronę przed oprogramowaniem szpiegującym oraz innymi niechcianymi elementami, to

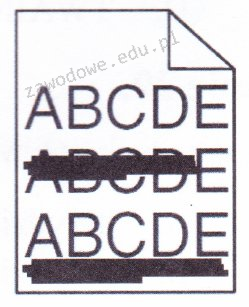

Co może być przyczyną problemów z wydrukiem z drukarki laserowej przedstawionych na ilustracji?

Funkcja Intel Turbo Boost w mikroprocesorze umożliwia

Sprzęt, na którym można skonfigurować sieć VLAN, to

Zidentyfikuj najprawdopodobniejszą przyczynę pojawienia się komunikatu "CMOS checksum error press F1 to continue press DEL to setup" podczas uruchamiania systemu komputerowego?

Jest to najnowsza edycja klienta wieloplatformowego, docenianego przez użytkowników na całym świecie, serwera wirtualnej sieci prywatnej, umożliwiającego nawiązanie połączenia między hostem a komputerem lokalnym, obsługującego uwierzytelnianie z wykorzystaniem kluczy, certyfikatów, nazwy użytkownika oraz hasła, a także, w wersji dla Windows, dodatkowych zakładek. Który z programów został wcześniej opisany?

Standard sieci bezprzewodowej WiFi 802.11 a/n operuje w zakresie

Jakie elementy łączy okablowanie pionowe w sieci LAN?

Mysz komputerowa z interfejsem bluetooth pracującym w klasie 2 ma teoretyczny zasięg do

Organizacja zajmująca się normalizacją na świecie, która stworzyła 7-warstwowy Model Referencyjny Otwartej Architektury Systemowej, to

Tester strukturalnego okablowania umożliwia weryfikację

Urządzenie pokazane na ilustracji to

Jakim procesem jest nieodwracalne usunięcie możliwości odzyskania danych z hard dysku?

Jaki protokół mailowy pozwala między innymi na przechowywanie odbieranych wiadomości e-mail na serwerze, zarządzanie wieloma katalogami, usuwanie wiadomości oraz przenoszenie ich pomiędzy katalogami?

Jeśli w określonej przestrzeni będą funkcjonowały równocześnie dwie sieci WLAN w standardzie 802.11g, to aby zredukować ryzyko wzajemnych zakłóceń, należy przypisać im kanały o numerach różniących się o

Dwie stacje robocze w tej samej sieci nie mają możliwości komunikacji. Która z poniższych okoliczności może być przyczyną tego problemu?

Jakie jest oznaczenie sieci, w której funkcjonuje host o IP 10.10.10.6 klasy A?

Jak dużo bitów minimum będzie potrzebnych w systemie binarnym do reprezentacji liczby heksadecymalnej 110h?

Użytkownik napotyka trudności z uruchomieniem systemu Windows. W celu rozwiązania tego problemu skorzystał z narzędzia System Image Recovery, które

Jakiego parametru w poleceniu ping należy użyć, aby uzyskać rezultat pokazany na zrzucie ekranu?

Wskaż sygnał, który wskazuje na uszkodzenie karty graficznej w komputerze z BIOS POST od firmy AWARD?

Za przydzielanie czasu procesora do konkretnych zadań odpowiada

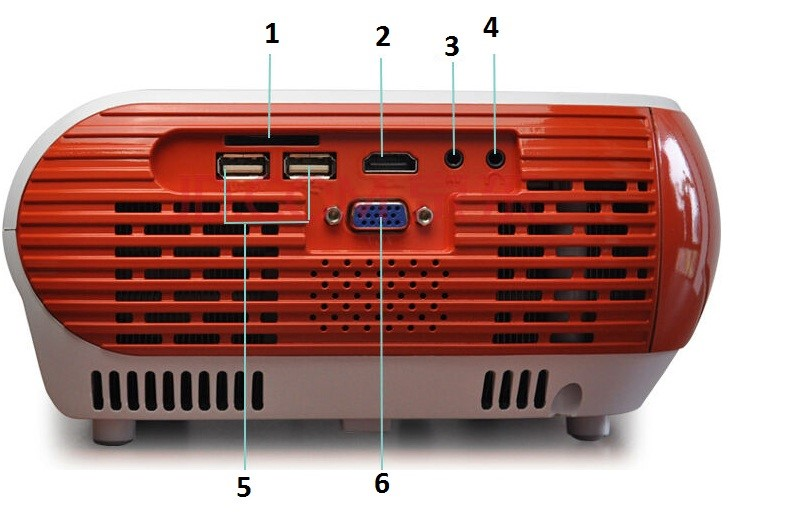

Aby za pomocą złącza DE-15F podłączyć przedstawiony projektor do laptopa, należy wykorzystać gniazdo oznaczone numerem

Podczas skanowania reprodukcji obrazu z magazynu, na skanie pojawiły się regularne wzory, zwane morą. Jaką funkcję skanera należy zastosować, aby pozbyć się mory?

W przedsiębiorstwie zainstalowano pięć komputerów z adresami kart sieciowych zawartymi w tabeli. W związku z tym można wyróżnić

| Adres IP | Maska |

|---|---|

| 10.1.61.10 | 255.255.0.0 |

| 10.1.61.11 | 255.255.0.0 |

| 10.3.63.20 | 255.255.0.0 |

| 10.3.63.21 | 255.255.0.0 |

| 10.5.63.10 | 255.255.0.0 |

Każdorazowo automatycznie szyfrowany staje się plik, który został zaszyfrowany przez użytkownika za pomocą systemu NTFS 5.0, w momencie

Elementem płyty głównej, który odpowiada za wymianę informacji pomiędzy procesorem a innymi komponentami płyty, jest

Jakim protokołem jest realizowana kontrola poprawności transmisji danych w sieciach Ethernet?