Pytanie 1

Symbol przedstawiony na ilustracji wskazuje na produkt

Wynik: 27/40 punktów (67,5%)

Wymagane minimum: 20 punktów (50%)

Symbol przedstawiony na ilustracji wskazuje na produkt

W ustawieniach haseł w systemie Windows Server została dezaktywowana możliwość wymogu dotyczącego złożoności hasła. Z jakiej minimalnej liczby znaków powinno składać się hasło użytkownika?

Jakim złączem zasilany jest wewnętrzny dysk twardy typu IDE?

Na przedstawionym schemacie wtyk (złącze męskie modularne) stanowi zakończenie kabla

Jaką liczbę hostów można podłączyć w sieci o adresie 192.168.1.128/29?

Jakie polecenie w systemie operacyjnym Linux umożliwia sprawdzenie bieżącej konfiguracji interfejsu sieciowego na komputerze?

Podczas normalnego działania systemu operacyjnego w laptopie pojawił się komunikat o konieczności formatowania wewnętrznego dysku twardego. Wskazuje on na

Użytkownik pragnie ochronić dane na karcie pamięci przed przypadkowym usunięciem. Taką zabezpieczającą cechę oferuje karta

Podaj adres rozgłoszeniowy dla podsieci 86.10.20.64/26?

Zasilacz UPS o mocy nominalnej 480 W nie powinien być używany do zasilania

Jakie narzędzie w systemie Windows pozwala na kontrolowanie stanu sprzętu, aktualizowanie sterowników oraz rozwiązywanie problemów z urządzeniami?

Jakie urządzenie powinno być użyte do podłączenia żył kablowych skrętki do gniazda Ethernet?

Podczas skanowania czarno-białego rysunku technicznego z maksymalną rozdzielczością optyczną skanera, na pochylonych i zaokrąglonych krawędziach można dostrzec schodkowe ułożenie pikseli. Aby poprawić jakość skanowanego obrazu, konieczne jest zastosowanie funkcji

Protokołem umożliwiającym bezpołączeniowe przesyłanie datagramów jest

Zaprezentowany tylny panel płyty głównej zawiera następujące interfejsy:

W sieci z maską 255.255.255.128 można przypisać adresy dla

Jednym z narzędzi zabezpieczających system przed oprogramowaniem, które bez wiedzy użytkownika pozyskuje i wysyła jego autorowi dane osobowe, numery kart płatniczych, informacje o adresach stron WWW odwiedzanych przez użytkownika, hasła i używane adresy mailowe, jest program

Jaki typ routingu jest najbardziej odpowiedni w złożonych, szybko ewoluujących sieciach?

Aby zweryfikować połączenia kabla U/UTP Cat. 5e w systemie okablowania strukturalnego, jakiego urządzenia należy użyć?

Aby poprawić bezpieczeństwo prywatnych danych sesji na stronie internetowej, zaleca się dezaktywację w ustawieniach przeglądarki

Jakim procesem jest nieodwracalne usunięcie możliwości odzyskania danych z hard dysku?

Która funkcja przełącznika zarządzalnego umożliwia kontrolę przepustowości każdego z wbudowanych portów?

Zarządzaniem czasem procesora dla różnych zadań zajmuje się

Procesor RISC to procesor o

Rekord typu A w systemie DNS

W komputerach stacjonarnych zamontowane są karty sieciowe Ethernet 10/100/1000 z gniazdem RJ45. Jakie medium transmisyjne powinno się zastosować w celu zbudowania sieci komputerowej zapewniającej najwyższą przepustowość?

Adware to program komputerowy

Industry Standard Architecture to standard magistrali, który określa, że szerokość szyny danych wynosi:

Zgodnie z przedstawionymi zaleceniami dla drukarki atramentowej, kolorowe dokumenty powinny być drukowane przynajmniej

„Czyszczenie głowicy drukarki …. ….. W tym przypadku najskuteczniejszym rozwiązaniem jest wyczyszczenie głowicy drukarki z zaschniętego tuszu. Z reguły wystarcza przetarcie głównego źródła problemu wilgotnym ręcznikiem. Jeżeli to nie pomoże należy zassać tusz do dysz, co pozwoli usunąć z nich powietrze. ….. Kiedy również i to nie pomoże należy przejść do ręcznego czyszczenia głowicy. Drukarka….. powinna być wyłączana na noc, ponieważ po każdym włączeniu przeprowadzane są mini cykle czyszczenia. Warto również pamiętać o wydrukowaniu przynajmniej raz w tygodniu kolorowego dokumentu, dzięki czemu zminimalizujemy prawdopodobieństwo zaschnięcia tuszu." Fragment instrukcji czyszczenia drukarki |

Wskaż standard interfejsu stosowanego do przewodowego połączenia dwóch urządzeń.

Jakie zdanie charakteryzuje SSH Secure Shell?

W metodzie dostępu do medium CSMA/CD (Carrier Sense Multiple Access with Collision Detection) stacja, która planuje rozpocząć transmisję, nasłuchuje, czy w sieci występuje aktywność, a następnie

Tusz żelowy wykorzystywany jest w drukarkach

Na podstawie filmu wskaż z ilu modułów składa się zainstalowana w komputerze pamięć RAM oraz jaką ma pojemność.

Jakie urządzenie sieciowe zostało pokazane na diagramie sieciowym?

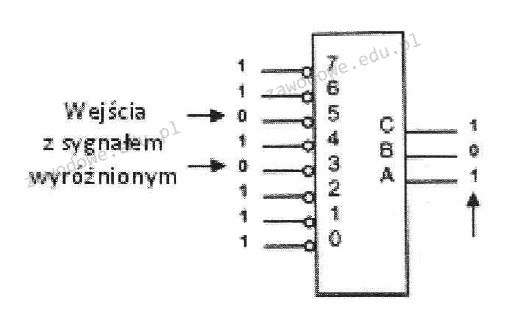

Na ilustracji przedstawiono symbol urządzenia cyfrowego

Na komputerze, na którym zainstalowane są dwa systemy – Windows i Linux, po przeprowadzeniu reinstalacji systemu Windows drugi system przestaje się uruchamiać. Aby ponownie umożliwić uruchamianie systemu Linux oraz aby zachować wszystkie dane i ustawienia w nim zawarte, co należy zrobić?

Jak należy postąpić z wiadomością e-mail od nieznanej osoby, która zawiera podejrzany załącznik?

Jakiego narzędzia należy użyć do zakończenia końcówek kabla UTP w module keystone z złączami typu 110?

Aby sprawdzić dysk twardy w systemie Linux na obecność uszkodzonych sektorów, użytkownik może zastosować program