Pytanie 1

Protokół stworzony do nadzorowania oraz zarządzania urządzeniami w sieci, oparty na architekturze klient-serwer, w którym jeden menedżer kontroluje od kilku do kilkuset agentów to

Wynik: 33/40 punktów (82,5%)

Wymagane minimum: 20 punktów (50%)

Protokół stworzony do nadzorowania oraz zarządzania urządzeniami w sieci, oparty na architekturze klient-serwer, w którym jeden menedżer kontroluje od kilku do kilkuset agentów to

Jaką maksymalną liczbę komputerów można zaadresować adresami IP w klasie C?

Która z grup w systemie Windows Serwer ma najniższe uprawnienia?

Funkcja roli Serwera Windows 2012, która umożliwia obsługę ruterów NAT oraz ruterów BGP w sieciach lokalnych, to

Wykonanie komendy ```net use Z:\M92.168.20.2\data /delete``` spowoduje

Zadaniem serwera jest rozgłaszanie drukarek w obrębie sieci, kolejka zadań do wydruku oraz przydzielanie uprawnień do korzystania z drukarek?

Po zainstalowaniu roli usług domenowych Active Directory na serwerze Windows, możliwe jest

W Active Directory, zbiór składający się z jednej lub wielu domen, które dzielą wspólny schemat oraz globalny katalog, określa się mianem

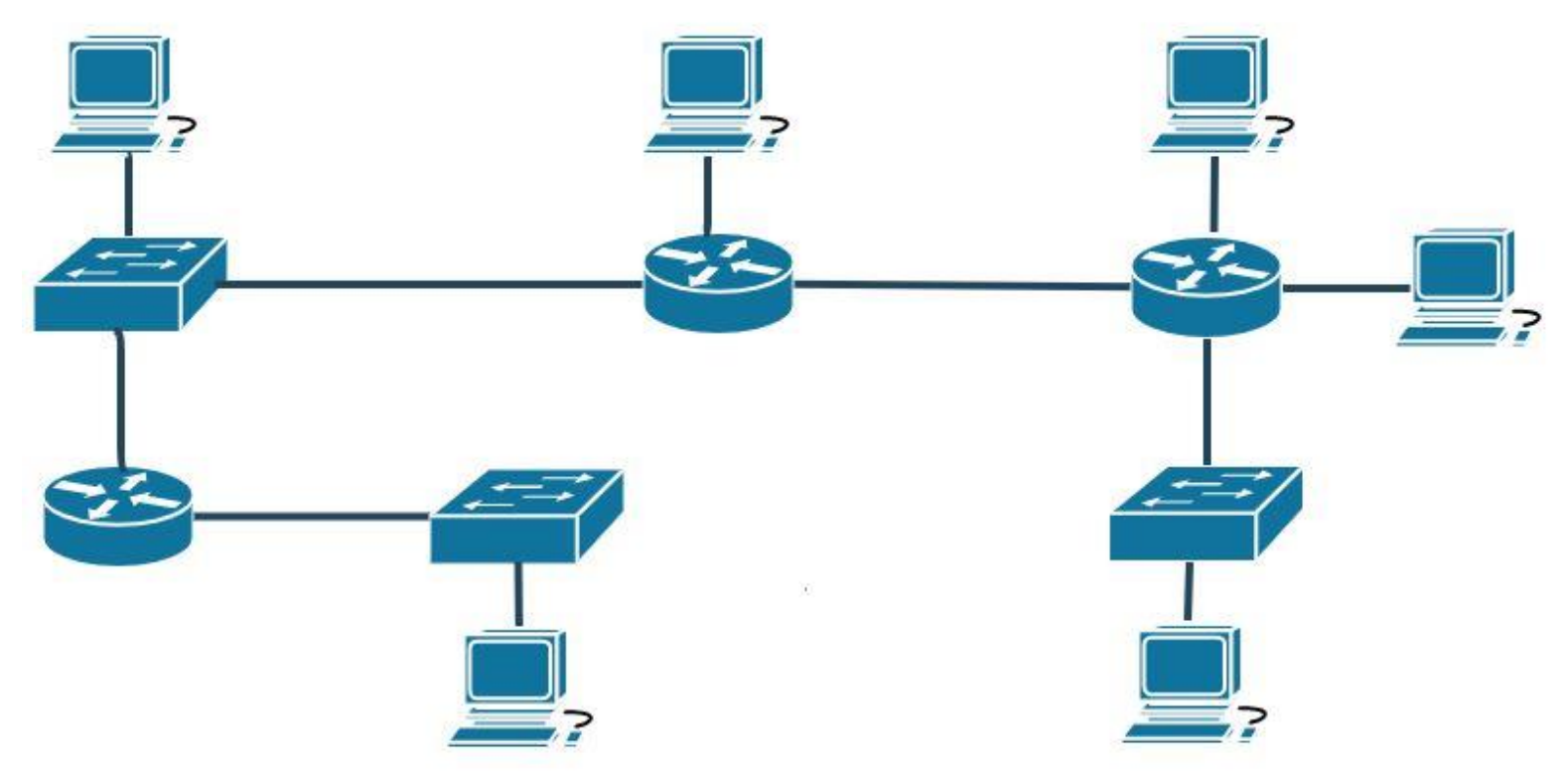

Ile domen rozgłoszeniowych istnieje w sieci o schemacie przedstawionym na rysunku, jeżeli przełączniki pracują w drugiej warstwie modelu ISO/OSI z konfiguracją domyślną?

Aby funkcja rutingu mogła prawidłowo funkcjonować na serwerze, musi być on wyposażony

Jakie polecenie powinno być użyte w systemie Windows, aby uzyskać informacje o adresach wszystkich kolejnych ruterów przekazujących dane z komputera do celu?

Jakie urządzenie pozwala na podłączenie drukarki bez karty sieciowej do sieci lokalnej komputerów?

W biurze rachunkowym potrzebne jest skonfigurowanie punktu dostępu oraz przygotowanie i podłączenie do sieci bezprzewodowej trzech komputerów oraz drukarki z WiFi. Koszt usługi konfiguracji poszczególnych elementów sieci wynosi 50 zł za każdy komputer, 50 zł za drukarkę i 100 zł za punkt dostępu. Jaki będzie całkowity wydatek związany z tymi pracami serwisowymi?

Urządzenie sieciowe typu most (ang. Bridge) działa w:

Urządzenia spełniające standard 802.11 g mogą osiągnąć maksymalną prędkość transmisji danych wynoszącą

W strukturze hierarchicznej sieci komputery należące do użytkowników znajdują się w warstwie

Jakie miejsce nie powinno być używane do przechowywania kopii zapasowych danych z dysku twardego komputera?

Jakie ograniczenie funkcjonalne występuje w wersji Standard systemu Windows Server 2019?

Która z poniższych właściwości kabla koncentrycznego RG-58 sprawia, że nie jest on obecnie stosowany w budowie lokalnych sieci komputerowych?

Jakie urządzenie należy wykorzystać, aby połączyć lokalną sieć z Internetem dostarczanym przez operatora telekomunikacyjnego?

Wskaż protokół, którego wiadomości są używane przez polecenie ping?

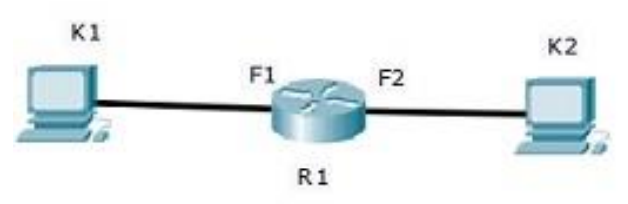

Komputery K1 i K2 nie mogą się komunikować. Adresacja urządzeń jest podana w tabeli. Co należy zmienić, aby przywrócić komunikację w sieci?

| Urządzenie | Adres | Maska | Brama |

|---|---|---|---|

| K1 | 10.0.0.2 | 255.255.255.128 | 10.0.0.1 |

| K2 | 10.0.0.102 | 255.255.255.192 | 10.0.0.1 |

| R1 (F1) | 10.0.0.1 | 255.255.255.128 | |

| R1 (F2) | 10.0.0.101 | 255.255.255.192 |

Z jakiego powodu adres 192.168.100.127 nie może zostać przypisany jako adres komputera w sieci 192.168.100.0/25?

Który z protokołów nie jest wykorzystywany do ustawiania wirtualnej sieci prywatnej?

Oblicz koszt brutto materiałów niezbędnych do połączenia w sieć, w topologii gwiazdy, 3 komputerów wyposażonych w karty sieciowe, wykorzystując przewody o długości 2 m. Ceny materiałów podano w tabeli.

| Nazwa elementu | Cena jednostkowa brutto |

|---|---|

| przełącznik | 80 zł |

| wtyk RJ-45 | 1 zł |

| przewód typu „skrętka" | 1 zł za 1 metr |

Administrator zamierza udostępnić folder C:\instrukcje w sieci trzem użytkownikom należącym do grupy Serwisanci. Jakie rozwiązanie powinien wybrać?

Kabel skręcany o czterech parach, w którym każdy z przewodów jest otoczony ekranem foliowym, a ponadto wszystkie pary są dodatkowo zabezpieczone siatką, to kabel

Ustanawianie zaszyfrowanych połączeń pomiędzy hostami w publicznej sieci Internet, wykorzystywane w sieciach VPN (Virtual Private Network), to

Czy po zainstalowaniu roli Hyper-V na serwerze Windows można

Aby zmierzyć tłumienie łącza światłowodowego w dwóch zakresach długości fali 1310 nm oraz 1550 nm, powinno się wykorzystać

W lokalnej sieci stosowane są adresy prywatne. Aby nawiązać połączenie z serwerem dostępnym przez Internet, trzeba

Jaką prędkość transmisji określa standard Ethernet IEEE 802.3z?

Atak mający na celu zablokowanie dostępu do usług dla uprawnionych użytkowników, co skutkuje zakłóceniem normalnego działania komputerów oraz komunikacji w sieci, to

Aplikacja, która pozwala na przechwytywanie pakietów oraz analizowanie aktywności w sieci, to

Aby uzyskać odpowiedź jak na poniższym zrzucie ekranu, należy wydać polecenie:

Server: Unknown Address: 192.168.0.1 Non-authoritative answer: Name: microsoft.com Addresses: 104.215.148.63 13.77.161.179 40.76.4.15 40.112.72.205 40.113.200.201

Mechanizm limitów dyskowych, pozwalający zarządzać wykorzystaniem przez użytkowników zasobów dyskowych, jest określany jako

Aby zabezpieczyć system Windows przed nieautoryzowanym dostępem poprzez ograniczenie liczby nieudanych prób logowania, należy ustawić

Który standard protokołu IEEE 802.3 powinien być użyty w środowisku z zakłóceniami elektromagnetycznymi, gdy dystans między punktem dystrybucji a punktem abonenckim wynosi 200 m?

Jakim skrótem nazywana jest sieć, która korzystając z technologii warstwy 1 i 2 modelu OSI, łączy urządzenia rozmieszczone na dużych terenach geograficznych?

Zrzut ekranowy przedstawia wynik wykonania w systemie z rodziny Windows Server polecenia

Server: livebox.home Address: 192.168.1.1 Non-authoritative answer: dns2.tpsa.pl AAAA IPv6 address = 2a01:1700:3:ffff::9822 dns2.tpsa.pl internet address = 194.204.152.34