Pytanie 1

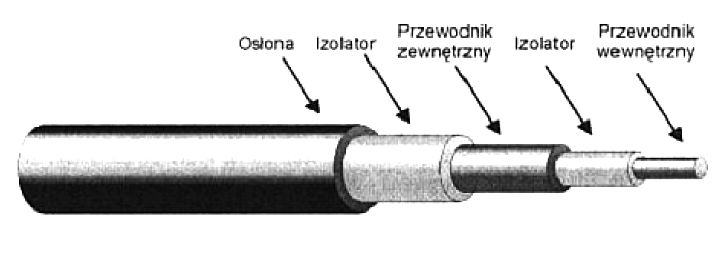

Na ilustracji pokazano przekrój kabla

Wynik: 3/40 punktów (7,5%)

Wymagane minimum: 20 punktów (50%)

Na ilustracji pokazano przekrój kabla

Oprogramowanie, które jest dodatkiem do systemu Windows i ma na celu ochronę przed oprogramowaniem szpiegującym oraz innymi niechcianymi elementami, to

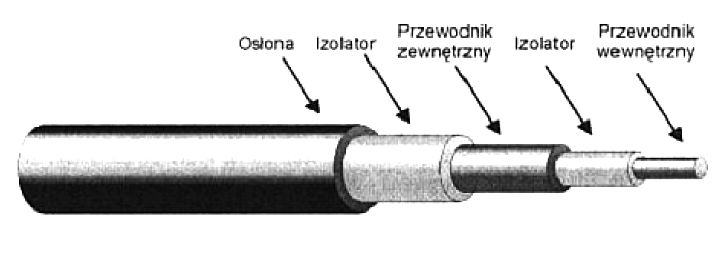

Na ilustracji zaprezentowano

Ile maksymalnie kanałów z dostępnego pasma kanałów w standardzie 802.11b może być używanych w Polsce?

Członkostwo komputera w danej sieci wirtualnej nie może być ustalane na podstawie

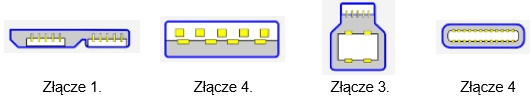

Jak nazywa się złącze wykorzystywane w sieciach komputerowych, pokazane na zamieszczonym obrazie?

Kiedy użytkownik systemu Windows wybiera opcję przywrócenia do określonego punktu, które pliki utworzone po tym punkcie nie będą podlegać zmianom w wyniku tej operacji?

Brak odpowiedzi na to pytanie.

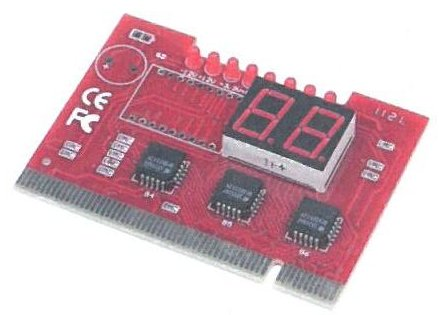

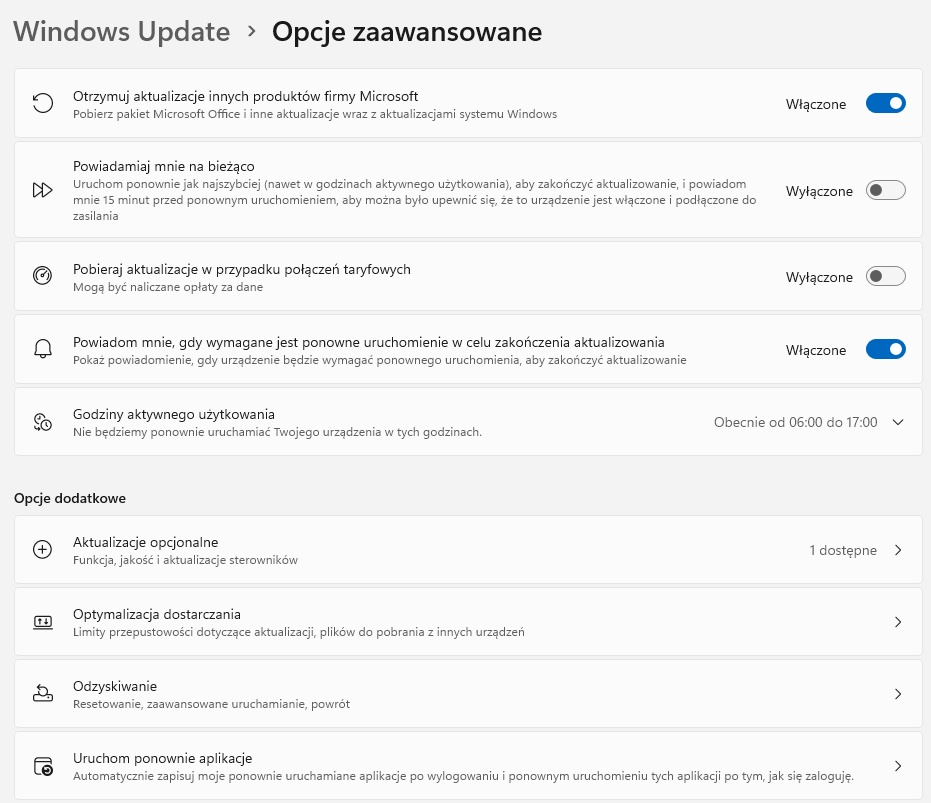

Biorąc pod uwagę konfigurację wykonywaną na ilustracji, administrator po zainstalowaniu systemu operacyjnego uznał za istotne, aby

Brak odpowiedzi na to pytanie.

Wskaż kształt złącza USB typu C.

Brak odpowiedzi na to pytanie.

Aplikacją systemu Windows, która umożliwia analizę wpływu różnych procesów i usług na wydajność CPU oraz oceny stopnia obciążenia pamięci i dysku, jest

Brak odpowiedzi na to pytanie.

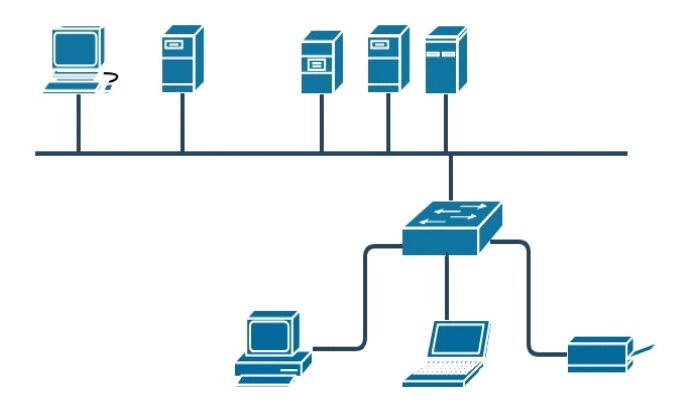

Ilustracja pokazuje schemat fizycznej topologii będącej kombinacją topologii

Brak odpowiedzi na to pytanie.

Który z symboli w systemach operacyjnych z rodziny Windows powinien być użyty przy udostępnianiu zasobu ukrytego w sieci?

Brak odpowiedzi na to pytanie.

Jakie narzędzie w systemie Windows pozwala na ocenę wpływu poszczególnych procesów i usług na wydajność procesora oraz na obciążenie pamięci i dysku?

Brak odpowiedzi na to pytanie.

Tryb działania portu równoległego, oparty na magistrali ISA, pozwalający na transfer danych do 2.4 MB/s, przeznaczony dla skanerów i urządzeń wielofunkcyjnych, to

Brak odpowiedzi na to pytanie.

Jaką częstotliwość odświeżania należy ustawić, aby obraz na monitorze był odświeżany 85 razy na sekundę?

Brak odpowiedzi na to pytanie.

Do wykonania kopii danych na dysk USB w systemie Linux stosuje się polecenie

Brak odpowiedzi na to pytanie.

W jakim typie członkostwa w VLAN port może należeć do wielu sieci VLAN?

Brak odpowiedzi na to pytanie.

Jak nazywa się protokół odpowiedzialny za wysyłkę wiadomości e-mail?

Brak odpowiedzi na to pytanie.

Która struktura partycji pozwala na stworzenie do 128 partycji podstawowych na pojedynczym dysku?

Brak odpowiedzi na to pytanie.

W systemie Linux program, który odpowiada aplikacji chkdsk z Windows, to

Brak odpowiedzi na to pytanie.

Ile wyniesie całkowity koszt wymiany karty sieciowej w komputerze, jeżeli cena karty to 40 zł, czas pracy serwisanta wyniesie 90 minut, a koszt każdej rozpoczętej roboczogodziny to 60 zł?

Brak odpowiedzi na to pytanie.

Interfejs SATA 2 (3Gb/s) oferuje prędkość transferu

Brak odpowiedzi na to pytanie.

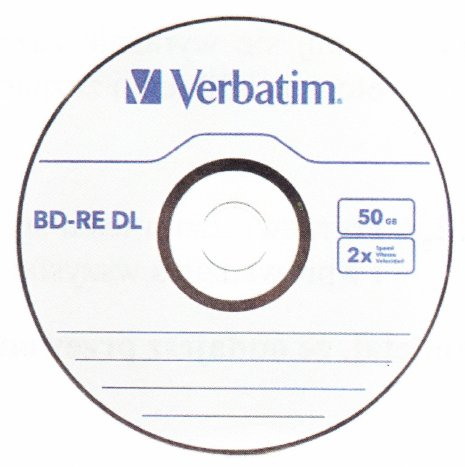

Aby nagrać dane na nośniku przedstawionym na ilustracji, konieczny jest odpowiedni napęd

Brak odpowiedzi na to pytanie.

Wykonanie polecenia tar –xf dane.tar w systemie Linux spowoduje

Brak odpowiedzi na to pytanie.

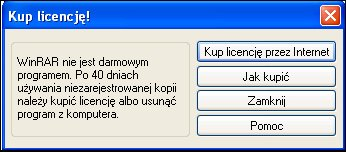

Program WinRaR zaprezentował okno informacyjne widoczne na ilustracji. Jakiego rodzaju licencji na program używał do tej pory użytkownik?

Brak odpowiedzi na to pytanie.

Rodzaje ataków mających na celu zakłócenie funkcjonowania aplikacji oraz procesów w urządzeniach sieciowych to ataki klasy

Brak odpowiedzi na to pytanie.

Jak nazywa się współpracujące z monitorami CRT urządzenie wskazujące z końcówką wyposażoną w światłoczuły element, która poprzez dotknięcie ekranu monitora powoduje przesłanie sygnału do komputera, umożliwiając w ten sposób lokalizację kursora?

Brak odpowiedzi na to pytanie.

Podstawowym warunkiem archiwizacji danych jest

Brak odpowiedzi na to pytanie.

Na podstawie filmu wskaż z ilu modułów składa się zainstalowana w komputerze pamięć RAM oraz jaką ma pojemność.

Brak odpowiedzi na to pytanie.

Który adres IPv4 identyfikuje urządzenie działające w sieci z adresem 14.36.64.0/20?

Brak odpowiedzi na to pytanie.

NOWY, GOTOWY, OCZEKUJĄCY oraz AKTYWNY to

Brak odpowiedzi na to pytanie.

Podczas wyłączania systemu operacyjnego na monitorze pojawił się błąd, znany jako bluescreen 0x000000F3 Bug Check 0xF3 DISORDERLY_SHUTDOWN - nieudane zamykanie systemu, spowodowane niewystarczającą ilością pamięci. Co ten błąd może oznaczać?

Brak odpowiedzi na to pytanie.

Który z poniższych adresów IP należy do grupy C?

Brak odpowiedzi na to pytanie.

Który z parametrów należy użyć w poleceniu netstat, aby uzyskać statystyki interfejsu sieciowego dotyczące liczby przesłanych oraz odebranych bajtów i pakietów?

Brak odpowiedzi na to pytanie.

W komunikacie błędu systemowego informacja prezentowana w formacie szesnastkowym oznacza

Brak odpowiedzi na to pytanie.

Jakie jest główne zadanie systemu DNS w sieci komputerowej?

Brak odpowiedzi na to pytanie.

Aby stworzyć bezpieczny wirtualny tunel pomiędzy dwoma komputerami korzystającymi z Internetu, należy użyć technologii

Brak odpowiedzi na to pytanie.

Urządzenie warstwy dystrybucji, które realizuje połączenie pomiędzy różnymi sieciami oraz kontroluje przepływ informacji między nimi, nazywane jest

Brak odpowiedzi na to pytanie.

Z informacji przedstawionych w tabeli wynika, że efektywna częstotliwość pamięci DDR SDRAM wynosi

| 184 styki |

| 64-bitowa szyna danych |

| Pojemność 1024 MB |

| Przepustowość 3200 MB/s |

Brak odpowiedzi na to pytanie.

W dokumentacji technicznej procesora Intel Xeon Processor E3-1220, producent przedstawia następujące dane: # rdzeni: 4 # wątków: 4 Częstotliwość zegara: 3.1 GHz Maksymalna częstotliwość Turbo: 3.4 GHz Intel Smart Cache: 8 MB DMI: 5 GT/s Zestaw instrukcji: 64 bit Rozszerzenia zestawu instrukcji: SSE4.1/4.2, AVX Opcje wbudowane: Nie Litografia: 32 nm Maksymalne TDP: 80 W. Co to oznacza dla Menedżera zadań systemu Windows, jeśli chodzi o historię użycia?

| # of Cores: | 4 |

| # of Threads: | 4 |

| Clock Speed: | 3.1 GHz |

| Max Turbo Frequency: | 3.4 GHz |

| Intel® Smart Cache: | 8 MB |

| DMI: | 5 GT/s |

| Instruction Set: | 64-bit |

| Instruction Set Extensions: | SSE4.1/4.2, AVX |

| Embedded Options Available: | No |

| Lithography: | 32 nm |

| Max TDP: | 80 W |

Brak odpowiedzi na to pytanie.