Pytanie 1

Jaką liczbę hostów można podłączyć w sieci o adresie 192.168.1.128/29?

Wynik: 25/40 punktów (62,5%)

Wymagane minimum: 20 punktów (50%)

Jaką liczbę hostów można podłączyć w sieci o adresie 192.168.1.128/29?

W systemie Windows przy użyciu polecenia assoc można

Po zauważeniu przypadkowego skasowania istotnych danych na dysku, najlepszym sposobem na odzyskanie usuniętych plików jest

Użytkownik planuje instalację 32-bitowego systemu operacyjnego Windows 7. Jaka jest minimalna ilość pamięci RAM, którą powinien mieć komputer, aby system mógł działać w trybie graficznym?

Przy użyciu urządzenia zobrazowanego na rysunku możliwe jest sprawdzenie działania

W systemie Linux, gdzie przechowywane są hasła użytkowników?

Rekord startowy dysku twardego w komputerze to

Podaj domyślny port używany do przesyłania poleceń w serwerze FTP

Która z macierzy RAID opiera się na replikacji dwóch lub więcej dysków twardych?

Aby komputery mogły udostępniać swoje zasoby w sieci, muszą mieć przypisane różne

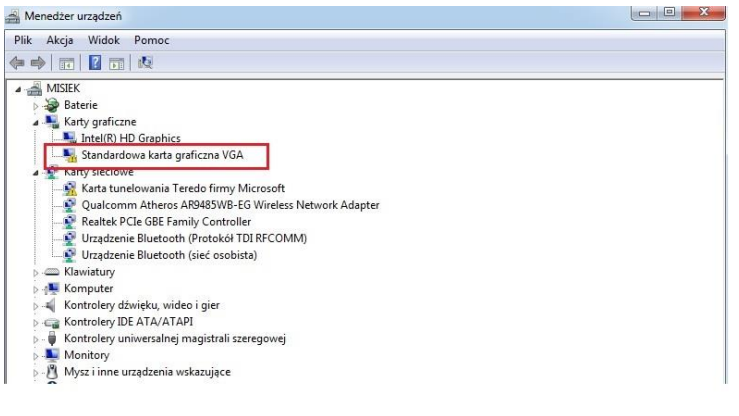

Jakie kroki powinien podjąć użytkownik, aby wyeliminować błąd zaznaczony na rysunku ramką?

Kto jest odpowiedzialny za alokację czasu procesora dla konkretnych zadań?

Na zdjęciu widać

Jakie napięcie jest obniżane z 230 V w zasilaczu komputerowym w standardzie ATX dla różnych podzespołów komputera?

Jakie oprogramowanie jest wykorzystywane do dynamicznej obsługi urządzeń w systemie Linux?

Nośniki danych, które są odporne na zakłócenia elektromagnetyczne oraz atmosferyczne, to

Znak handlowy dla produktów certyfikowanych według standardów IEEE 802.11 to

W skanerach z systemem CIS źródłem światła oświetlającym dokument jest

W której warstwie modelu ISO/OSI odbywa się segmentacja danych, komunikacja w trybie połączeniowym z użyciem protokołu TCP oraz komunikacja w trybie bezpołączeniowym z zastosowaniem UDP?

Jak należy postąpić z wiadomością e-mail od nieznanej osoby, która zawiera podejrzany załącznik?

Jaką maksymalną prędkość danych można osiągnąć w sieci korzystającej z skrętki kategorii 5e?

Jakie rozwiązanie techniczne pozwala na transmisję danych z szybkością 1 Gb/s z zastosowaniem światłowodu?

W biurze rachunkowym znajduje się sześć komputerów w jednym pomieszczeniu, połączonych kablem UTP Cat 5e z koncentratorem. Pracownicy korzystający z tych komputerów muszą mieć możliwość drukowania bardzo dużej ilości dokumentów monochromatycznych (powyżej 5 tys. stron miesięcznie). Aby zminimalizować koszty zakupu i eksploatacji sprzętu, najlepszym wyborem będzie:

Jakie składniki systemu komputerowego muszą być usuwane w wyspecjalizowanych zakładach przetwarzania ze względu na obecność niebezpiecznych substancji lub chemicznych pierwiastków?

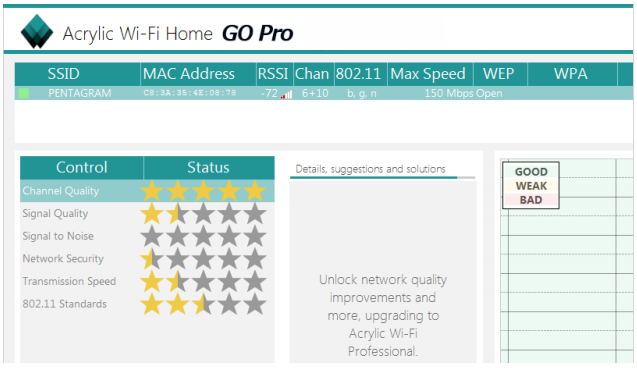

W programie Acrylic Wi-Fi Home przeprowadzono test, którego rezultaty ukazano na zrzucie ekranu. Na ich podstawie można stwierdzić, że sieć bezprzewodowa dostępna w danym momencie

Urządzenie, które pozwala komputerom na bezprzewodowe łączenie się z siecią komputerową przewodową, to

Tworzenie zaszyfrowanych połączeń pomiędzy hostami przez publiczną sieć Internet, wykorzystywane w rozwiązaniach VPN (Virtual Private Network), to

W systemie Linux komendą, która jednocześnie podnosi uprawnienia dla procesu uruchamianego z terminala, jest

Jakiego rodzaju adresację stosuje protokół IPv6?

W przedsiębiorstwie zastosowano adres klasy B do podziału na 100 podsieci, z maksymalnie 510 dostępnymi adresami IP w każdej z nich. Jaka maska została użyta do utworzenia tych podsieci?

Oprogramowanie, które regularnie przerywa działanie przez pokazanie komunikatu o konieczności uiszczenia opłaty, co prowadzi do zniknięcia tego komunikatu, jest dystrybuowane na podstawie licencji

Proces zapisywania kluczy rejestru do pliku określamy jako

Wskaż najkorzystniejszą trasę sumaryczną dla podsieci IPv4?

| 10.10.168.0/23 |

| 10.10.170.0/23 |

| 10.10.172.0/23 |

| 10.10.174.0/24 |

Protokół, który pozwala na bezpieczną, zdalną obsługę serwera, to

W systemie Linux narzędzie, które umożliwia śledzenie trasy pakietów od źródła do celu, pokazując procentowe straty oraz opóźnienia, to

System S.M.A.R.T. jest wykorzystywany do nadzorowania działania oraz identyfikacji usterek

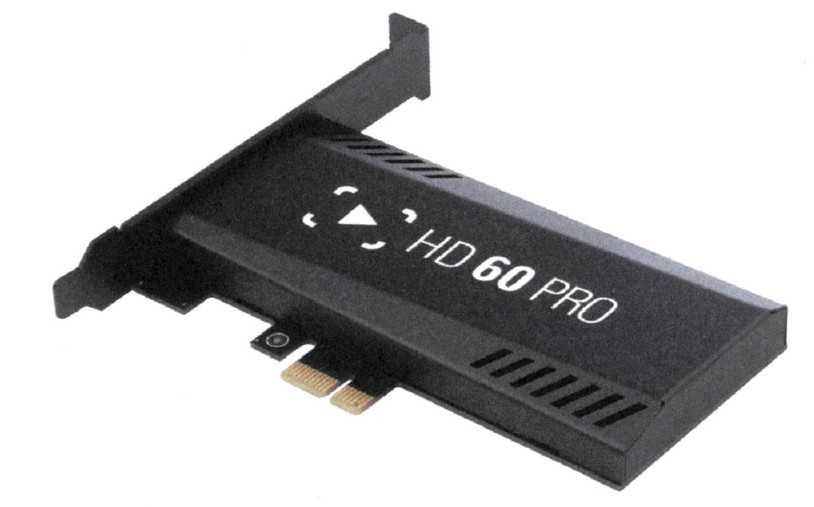

Karta do przechwytywania wideo, która została przedstawiona, będzie kompatybilna z płytą główną posiadającą port

Który z interfejsów umożliwia transfer danych zarówno w formacie cyfrowym, jak i analogowym pomiędzy komputerem a wyświetlaczem?

Aby utworzyć kolejną partycję w systemie Windows, można skorzystać z narzędzia

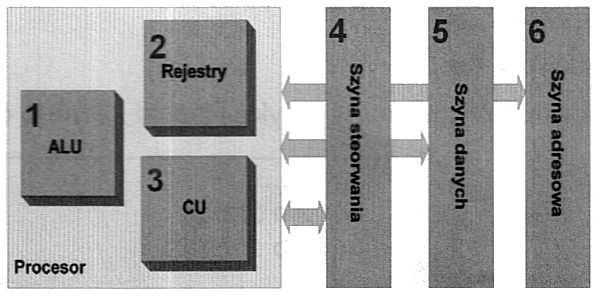

Na diagramie element odpowiedzialny za dekodowanie poleceń jest oznaczony liczbą