Pytanie 1

Jakie materiały eksploatacyjne wykorzystuje się w rzutniku multimedialnym?

Wynik: 24/40 punktów (60,0%)

Wymagane minimum: 20 punktów (50%)

Jakie materiały eksploatacyjne wykorzystuje się w rzutniku multimedialnym?

Jaką topologię fizyczną sieci komputerowej przedstawia rysunek?

Protokołem kontrolnym w obrębie rodziny TCP/IP, który ma na celu między innymi identyfikowanie usterek w urządzeniach sieciowych, jest

Aby zrealizować usługę zdalnego uruchamiania systemów operacyjnych na komputerach stacjonarnych, należy w Windows Server zainstalować rolę

Pełna maska podsieci z prefiksem /25 to

Które z poniższych twierdzeń nie odnosi się do pamięci cache L1?

Jakie polecenie w systemie Windows służy do analizowania ścieżki, jaką pokonują pakiety w sieci?

Jakie są różnice pomiędzy poleceniem ps a poleceniem top w systemie Linux?

Usługa, umożliwiająca zdalną pracę na komputerze z systemem Windows z innego komputera z systemem Windows, który jest połączony z tą samą siecią lub z Internetem, to

Jakie polecenie w systemie Windows pozwala na wyświetlenie tabeli routingu hosta?

W specyfikacji głośników komputerowych producent mógł podać informację, że maksymalne pasmo przenoszenia wynosi

Do dynamicznej obsługi sprzętu w Linuxie jest stosowany system

Jakie parametry otrzyma interfejs sieciowy eth0 po wykonaniu poniższych poleceń w systemie Linux?

Kiedy wygasa autorskie prawo majątkowe dotyczące programu komputerowego, stworzonego przez kilku programistów, którzy jako jego autorzy podpisali aplikację swoimi imionami i nazwiskami?

Ile wyniesie całkowity koszt wymiany karty sieciowej w komputerze, jeżeli cena karty to 40 zł, czas pracy serwisanta wyniesie 90 minut, a koszt każdej rozpoczętej roboczogodziny to 60 zł?

Materiałem eksploatacyjnym stosowanym w drukarkach tekstylnych jest

Liczby zapisane w systemie binarnym jako 10101010 oraz w systemie heksadecymalnym jako 2D odpowiadają następującym wartościom:

W terminalu systemu operacyjnego wykonano polecenie nslookup. Jaką informację uzyskano?

Oprogramowanie, które wymaga zatwierdzenia na wyświetlanie reklam lub zakupu pełnej licencji, aby usunąć reklamy, jest dystrybuowane na licencji

Aby w systemie Windows Professional ustawić czas pracy drukarki oraz uprawnienia drukowania, należy skonfigurować

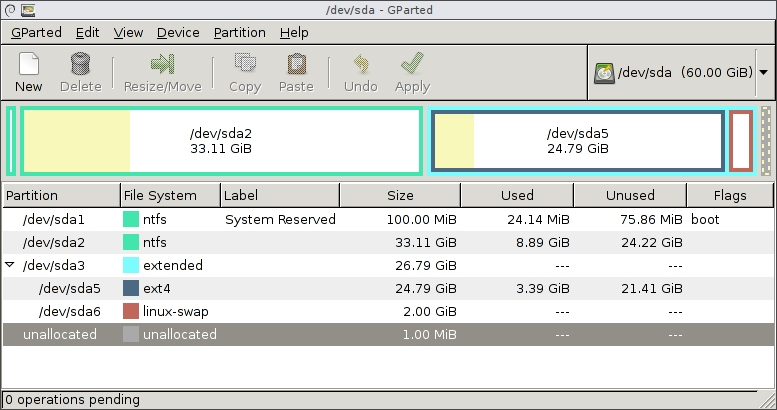

Badanie danych przedstawionych przez program umożliwia dojście do wniosku, że

Po stwierdzeniu przypadkowego usunięcia ważnych danych na dysku twardym, aby odzyskać usunięte pliki, najlepiej

Na ilustracji zaprezentowano kabel

Jakie zastosowanie ma oprogramowanie Microsoft Hyper-V?

Podstawowym zadaniem mechanizmu Plug and Play jest

Jakie medium transmisyjne jest związane z adapterem przedstawionym na ilustracji?

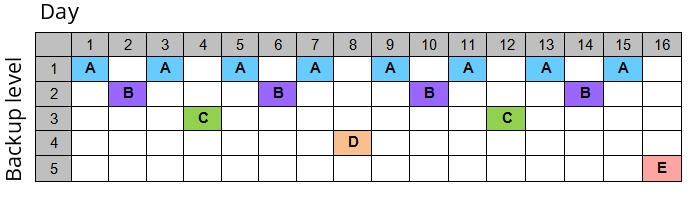

Strategia przedstawiona w diagramie dla tworzenia kopii zapasowych na nośnikach jest znana jako

Magistrala PCI-Express wykorzystuje do transmisji danych metodę komunikacji

Aby użytkownik systemu Linux mógł sprawdzić zawartość katalogu, wyświetlając pliki i katalogi, oprócz polecenia ls może skorzystać z polecenia

W komputerach obsługujących wysokowydajne zadania serwerowe, konieczne jest użycie dysku z interfejsem

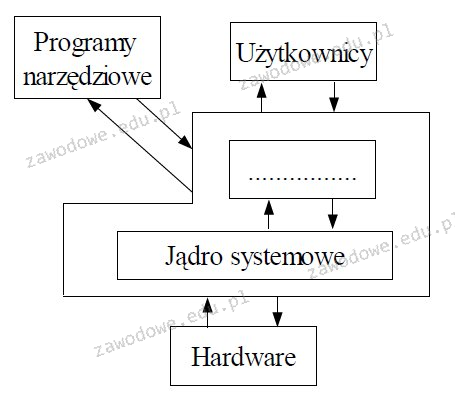

Jaki termin powinien zostać umieszczony w miejscu z kropkami na schemacie blokowym przedstawiającym strukturę systemu operacyjnego?

Urządzenie używane do zestawienia 6 komputerów w sieci lokalnej to:

Który protokół służy do wymiany danych o trasach oraz dostępności sieci pomiędzy routerami w ramach tego samego systemu autonomicznego?

Protokół używany do zarządzania urządzeniami w sieci to

Sekwencja 172.16.0.1, która reprezentuje adres IP komputera, jest zapisana w systemie

Po włączeniu komputera wyświetlił się komunikat: Non-system disk or disk error. Replace and strike any key when ready. Co może być tego przyczyną?

Każdy następny router IP na ścieżce pakietu

Aby zrealizować aktualizację zainstalowanego systemu operacyjnego Linux Ubuntu, należy wykonać polecenie

Czym jest skrót MAN w kontekście sieci?

Narzędzie chroniące przed nieautoryzowanym dostępem do lokalnej sieci, to