Pytanie 1

Jakiego parametru wymaga konfiguracja serwera DHCP?

Wynik: 24/40 punktów (60,0%)

Wymagane minimum: 20 punktów (50%)

Jakiego parametru wymaga konfiguracja serwera DHCP?

Jakie narzędzie będzie najbardziej odpowiednie do delikatnego wygięcia blachy obudowy komputera oraz przykręcenia śruby montażowej w trudno dostępnej lokalizacji?

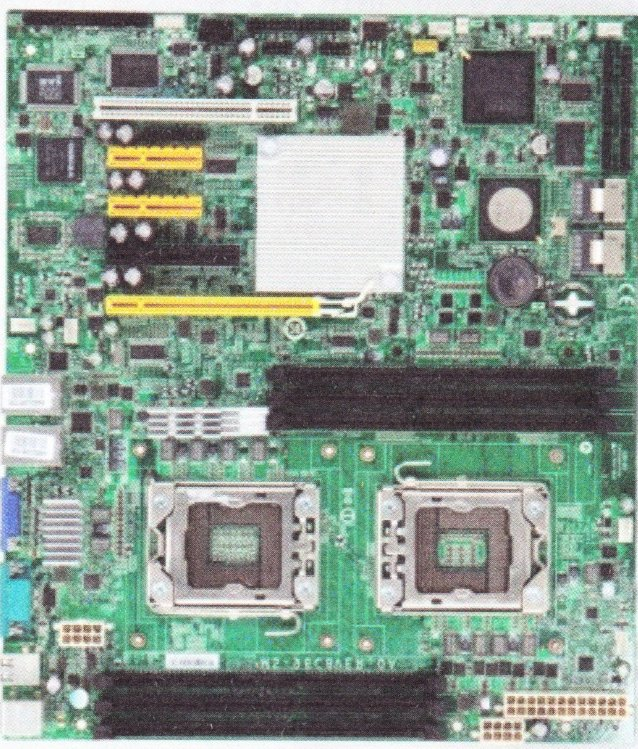

W komputerze użyto płyty głównej widocznej na obrazku. Aby podnieść wydajność obliczeniową maszyny, zaleca się

Najkrótszy czas dostępu charakteryzuje się

Jakim adresem IPv6 charakteryzuje się autokonfiguracja łącza?

Jakie są skutki działania poniższego polecenia ```netsh advfirewall firewall add rule name="Open" dir=in action=deny protocol=TCP localport=53```?

Który z protokołów pełni rolę protokołu połączeniowego?

W systemie Linux narzędzie iptables wykorzystuje się do

Jaką normę wykorzystuje się przy okablowaniu strukturalnym w komputerowych sieciach?

Jakiego rodzaju interfejsem jest UDMA?

Symbol umieszczony na urządzeniach, który stanowi certyfikat potwierdzający zgodność w zakresie emisji promieniowania, ergonomii, efektywności energetycznej i ekologicznych norm, został przedstawiony na ilustracji

Funkcja Intel Turbo Boost w mikroprocesorze umożliwia

Aby zidentyfikować, który program najbardziej obciąża CPU w systemie Windows, należy otworzyć program

Podczas uruchamiania komputera wyświetla się komunikat CMOS checksum error press F1 to continue, press Del to setup) naciśnięcie klawisza Del skutkuje

Aby zapobiec uszkodzeniu sprzętu podczas modernizacji laptopa, która obejmuje wymianę modułów pamięci RAM, należy

Błąd typu STOP Error (Blue Screen) w systemie Windows, który wiąże się z odniesieniem się systemu do niepoprawnych danych w pamięci RAM, to

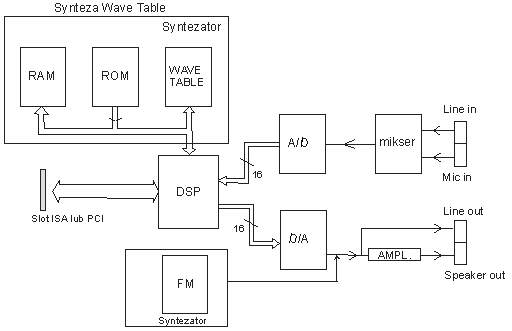

Na które wyjście powinniśmy podłączyć aktywne głośniki w karcie dźwiękowej, której schemat przedstawiony jest na rysunku?

Początkowe znaki heksadecymalne adresu IPv6 przeznaczonego do link-local to

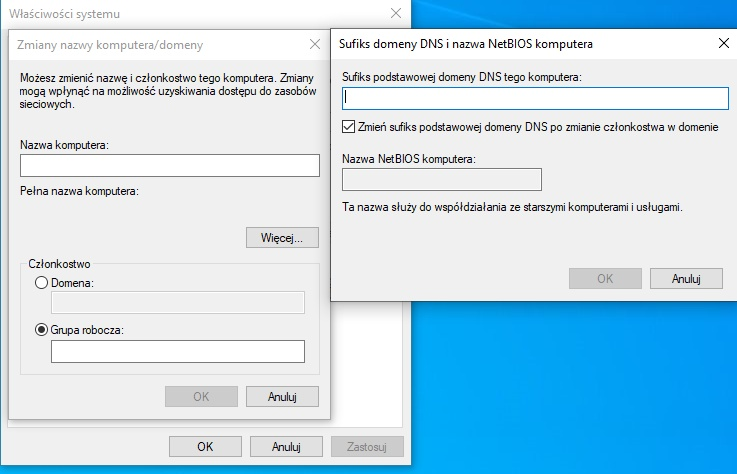

Aby podłączyć stację roboczą z zainstalowanym systemem Windows do domeny zst.local należy

Jakie adresy mieszczą się w zakresie klasy C?

Okablowanie pionowe w systemie strukturalnym łączy się

W celu zapewnienia jakości usługi QoS, w przełącznikach warstwy dostępu stosuje się mechanizm

Jakim środkiem należy oczyścić wnętrze obudowy drukarki fotograficznej z kurzu?

Przed przystąpieniem do modernizacji komputerów osobistych oraz serwerów, polegającej na dodaniu nowych modułów pamięci RAM, konieczne jest sprawdzenie

Które z wymienionych mediów nie jest odpowiednie do przesyłania danych teleinformatycznych?

Uszkodzenie czego może być przyczyną awarii klawiatury?

Jakie medium transmisyjne nosi nazwę 100BaseTX i jaka jest maksymalna prędkość danych, która może być w nim osiągnięta?

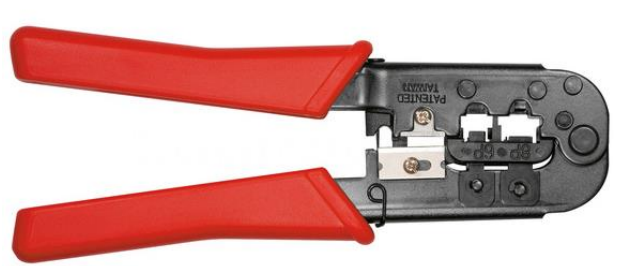

Jakie kable powinny być używane z narzędziem pokazanym na fotografii?

Na podstawie filmu wskaż z ilu modułów składa się zainstalowana w komputerze pamięć RAM oraz jaką ma pojemność.

Na którym standardowym porcie funkcjonuje serwer WWW wykorzystujący domyślny protokół HTTPS w typowym ustawieniu?

Standardowe napięcie zasilające dla modułów pamięci RAM DDR4 wynosi

Papier termotransferowy to materiał eksploatacyjny stosowany w drukarkach

Jak wielu hostów można maksymalnie zaadresować w sieci lokalnej, mając do dyspozycji jeden blok adresów klasy C protokołu IPv4?

Jakie polecenie trzeba wydać w systemie Windows, aby zweryfikować tabelę mapowania adresów IP na adresy MAC wykorzystywane przez protokół ARP?

W systemie dziesiętnym liczba 110011(2) przedstawia się jako

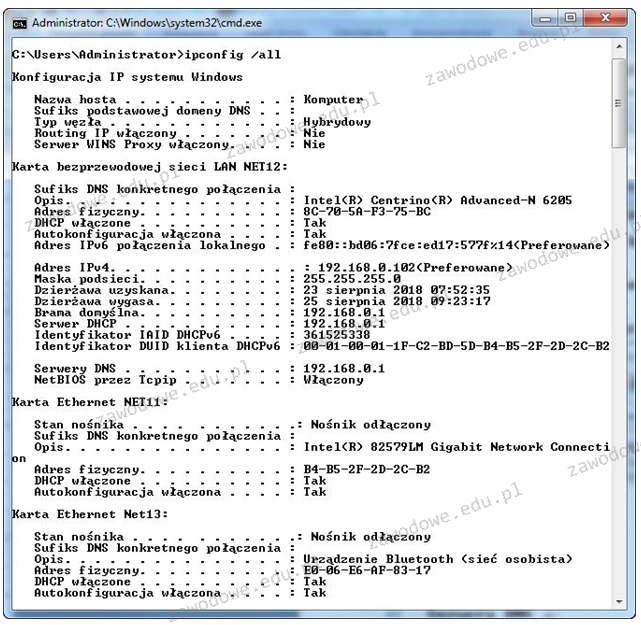

Analizując przedstawione wyniki konfiguracji zainstalowanych kart sieciowych na komputerze, można zauważyć, że

Które z poniższych stwierdzeń dotyczących konta użytkownika Active Directory w systemie Windows jest prawdziwe?

W jakiej logicznej topologii funkcjonuje sieć Ethernet?

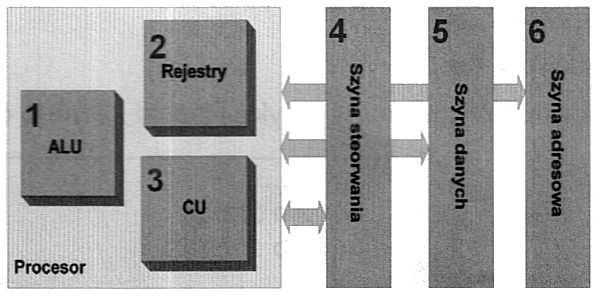

Na diagramie element odpowiedzialny za dekodowanie poleceń jest oznaczony liczbą

Który z wymienionych systemów operacyjnych nie obsługuje wielozadaniowości?