Pytanie 1

Którą kość zaznaczono strzałką na radiogramie stopy?

Wynik: 29/40 punktów (72,5%)

Wymagane minimum: 20 punktów (50%)

Którą kość zaznaczono strzałką na radiogramie stopy?

Pozytywny środek cieniujący najczęściej stosowany w rentgenodiagnostyce powinien charakteryzować się

Celem radioterapii paliatywnej nie jest

Zdjęcie którego zęba górnego zlecił na skierowaniu lekarz stomatolog?

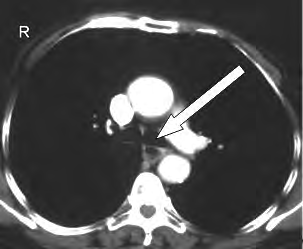

Na obrazie TK klatki piersiowej w przekroju poprzecznym strzałką oznaczono

Chorobą układu oddechowego typu obturacyjnego jest

W audiometrii badanie polegające na maskowaniu (zagłuszaniu) tonów szumem białym to próba

W medycynie nuklearnej wykorzystuje się:

Który załamek odzwierciedla repolaryzację komór w zapisie EKG?

Podczas teleradioterapii piersi lewej narządem krytycznym jest

W celu wyeliminowania zakłóceń obrazu MR przez sygnały pochodzące z tkanki tłuszczowej, stosuje się

Co określa M₀ w systemie klasyfikacji nowotworów TNM?

Planowany obszar napromieniania PTV obejmuje

Parametr spirometryczny czynnościowa pojemność zalegająca oznaczany jest skrótem

Zadaniem technika elektroradiologii w pracowni badań naczyniowych jest

Które zdjęcie RTG stawu łokciowego zostało wykonane w projekcji skośnej w rotacji zewnętrznej?

W sekwencji echa spinowego obraz T2-zależny uzyskuje się przy czasie repetycji TR

Która metoda leczenia onkologicznego zaliczana jest do leczenia systemowego?

Technik elektroradiolog do badania MR kręgosłupa lędźwiowego powinien ułożyć pacjenta:

W badaniu EEG elektrody referencyjne przymocowane do płatka ucha to

Kasety do pośredniej radiografii cyfrowej CR są wyposażone

W radioterapii hadronowej leczenie odbywa się przy użyciu

Czas repetycji w obrazowaniu metodą rezonansu magnetycznego to

Źródłem promieniowania protonowego stosowanego w radioterapii jest

Testy specjalistyczne aparatów rentgenowskich do zdjęć wewnątrzustnych są przeprowadzane

Na rentgenogramie uwidoczniono badanie

Jednym z kryteriów poprawnie wykonanego badania spirometrycznego jest czas trwania natężonego wydechu, który powinien wynosić u osób powyżej 10 roku życia co najmniej

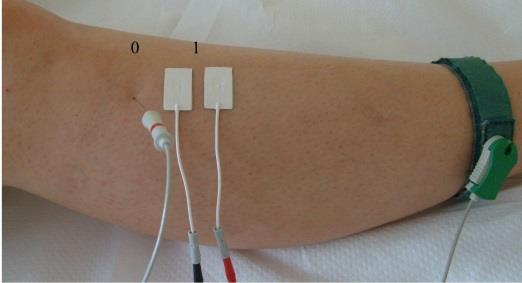

Na ilustracji przedstawiono przygotowanie pacjenta do badania

Na obrazie MR kręgosłupa lędźwiowego strzałką wskazano

W badaniu EKG różnice potencjałów pomiędzy lewym podudziem a lewym przedramieniem rejestruje odprowadzenie

W zapisie EKG zespół QRS odzwierciedla

Pojawienie się w zapisie EKG patologicznego załamka Q lub QS może wskazywać na

Gruboziarnista folia wzmacniająca wpływa na zwiększenie na obrazie rentgenowskim nieostrości

Badanie metodą Dopplera umożliwia

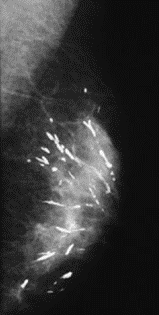

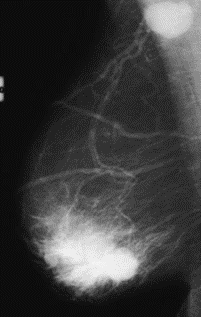

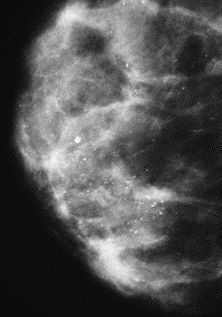

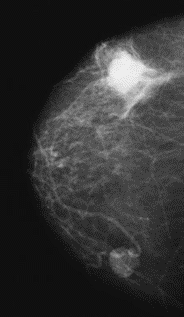

Na którym obrazie rentgenowskim sutka uwidoczniono zmianę patologiczną w obrębie węzłów chłonnych?

W badaniu PET stosuje się tylko radioizotopy emitujące

Rytm alfa i beta rejestruje się podczas badania

Jaka jest moc dawki pochłoniętej w brachyterapii HDR?

Na obrazie TK nadgarstka uwidocznione jest złamanie kości

W scyntygrafii perfuzyjnej płuc pacjentowi podawany jest radioizotop