Pytanie 1

Jaką funkcję pełni serwer FTP?

Wynik: 17/40 punktów (42,5%)

Wymagane minimum: 20 punktów (50%)

Jaką funkcję pełni serwer FTP?

Który z zapisów stanowi pełną formę maski z prefiksem 25?

Fizyczna architektura sieci, inaczej określana jako topologia fizyczna sieci komputerowych, definiuje

Jakie polecenie w systemie Linux służy do przypisania adresu IP oraz maski podsieci dla interfejsu eth0?

Czym jest układ RAMDAC?

Jaki adres IP należy do urządzenia funkcjonującego w sieci 10.0.0.0/17?

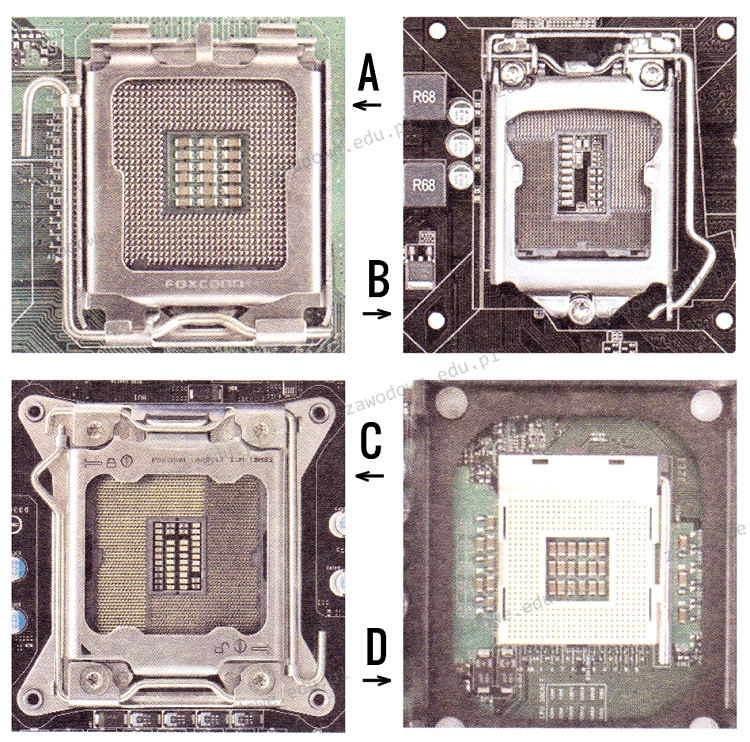

W jakim gnieździe powinien być umieszczony procesor INTEL CORE i3-4350- 3.60 GHz, x2/4, 4MB, 54W, HD 4600, BOX, s-1150?

Liczby 1001 i 100 w wierszu pliku /etc/passwd reprezentują

Termin określający zdolność do rozbudowy sieci to

Serwer zajmuje się rozgłaszaniem drukarek w sieci, organizowaniem zadań do wydruku oraz przydzielaniem uprawnień do korzystania z drukarek

Na jakich licencjach są dystrybuowane wersje systemu Linux Ubuntu?

Który z poniższych protokołów służy do zarządzania urządzeniami w sieciach?

Dodatkowe właściwości wyniku operacji przeprowadzanej przez jednostkę arytmetyczno-logiczna ALU zawiera

W przypadku, gdy w tej samej przestrzeni będą funkcjonować jednocześnie dwie sieci WLAN zgodne ze standardem 802.11g, w celu zminimalizowania ryzyka wzajemnych zakłóceń, powinny one otrzymać kanały o numerach różniących się o

Jaka jest prędkość przesyłania danych w standardzie 1000Base-T?

Jaką długość ma adres IP wersji 4?

Jaką sumę należy zapłacić za wymianę karty graficznej w komputerze, jeżeli cena karty wynosi 250 zł, a czas wymiany przez pracownika serwisu to 80 minut, przy czym każda rozpoczęta godzina pracy kosztuje 50 zł?

Jakie polecenie powinien wydać root w systemie Ubuntu Linux, aby przeprowadzić aktualizację wszystkich pakietów (całego systemu) do najnowszej wersji z zainstalowaniem nowego jądra?

Najkrótszy czas dostępu charakteryzuje się

Jakie będą całkowite wydatki na materiały potrzebne do wyprodukowania 20 kabli połączeniowych typu patchcord o długości 1,5 m każdy, jeżeli koszt jednego metra kabla wynosi 1 zł, a wtyk to 50 gr?

Które z kont nie jest standardowym w Windows XP?

Martwy piksel, który jest defektem w monitorach LCD, to punkt, który ciągle ma ten sam kolor

Ile sieci obejmują komputery z adresami IP i maskami sieci wskazanymi w tabeli?

Atak DDoS (z ang. Distributed Denial of Service) na serwer może spowodować

W jakim miejscu są przechowywane dane o kontach użytkowników domenowych w środowisku Windows Server?

Grupa, w której członkom można nadawać uprawnienia jedynie w obrębie tej samej domeny, co domena nadrzędna lokalnej grupy domeny, nosi nazwę grupa

W jakiej logicznej topologii działa sieć Ethernet?

Postcardware to typ

Zastosowanie programu w różnych celach, badanie jego działania oraz wprowadzanie modyfikacji, a także możliwość publicznego udostępniania tych zmian, to charakterystyka licencji typu

W systemie Windows, po wydaniu komendy systeminfo, nie da się uzyskać danych o

Posiadacz notebooka pragnie zainstalować w nim dodatkowy dysk twardy. Urządzenie ma jedynie jedną zatokę na HDD. Możliwością rozwiązania tego wyzwania może być użycie dysku z interfejsem

Urządzeniem, które chroni przed różnorodnymi atakami sieciowymi oraz może wykonywać dodatkowe zadania, takie jak szyfrowanie przesyłanych informacji lub automatyczne informowanie administratora o próbie włamania, jest

Jakie urządzenie jest kluczowe dla połączenia pięciu komputerów w sieci o strukturze gwiazdy?

Uszkodzenie mechaniczne dysku twardego w komputerze stacjonarnym może być spowodowane

Jaki protokół stworzony przez IBM służy do udostępniania plików w architekturze klient-serwer oraz do współdzielenia zasobów z sieciami Microsoft w systemach operacyjnych LINUX i UNIX?

Aby przywrócić zgubione dane w systemach z rodziny Windows, konieczne jest użycie polecenia

Główny sposób zabezpieczania danych w sieciach komputerowych przed dostępem nieautoryzowanym to

Jaki protokół sygnalizacyjny jest wykorzystywany w technologii VoIP?

Aby uzyskać dostęp do adresu serwera DNS w ustawieniach karty sieciowej w systemie z rodziny Windows, należy wprowadzić polecenie

W technologii Ethernet protokół dostępu do medium CSMA/CD jest metodą z