Pytanie 1

Umowa, na podstawie której użytkownik ma między innymi dostęp do kodu źródłowego oprogramowania w celu jego analizy i ulepszania, to licencja

Wynik: 26/40 punktów (65,0%)

Wymagane minimum: 20 punktów (50%)

Umowa, na podstawie której użytkownik ma między innymi dostęp do kodu źródłowego oprogramowania w celu jego analizy i ulepszania, to licencja

Jakie działanie nie przyczynia się do personalizacji systemu operacyjnego Windows?

Jak nazywa się pamięć podręczna?

Termin określający zdolność do rozbudowy sieci to

Jakie narzędzie pozwala na zarządzanie menedżerem rozruchu w systemach Windows od wersji Vista?

Która z poniższych wskazówek nie jest właściwa w kontekście konserwacji skanera płaskiego?

Elementem, który umożliwia wymianę informacji pomiędzy procesorem a magistralą PCI-E, jest

W przypadku dłuższego nieużytkowania drukarki atramentowej, pojemniki z tuszem powinny

Poprzez użycie opisanego urządzenia możliwe jest wykonanie diagnostyki działania

W systemach Windows, aby określić, w którym miejscu w sieci zatrzymał się pakiet, stosuje się komendę

Która z usług umożliwia rejestrowanie oraz identyfikowanie nazw NetBIOS jako adresów IP wykorzystywanych w sieci?

Przy zmianach w rejestrze Windows w celu zapewnienia bezpieczeństwa należy najpierw

Urządzenie ADSL wykorzystuje się do nawiązania połączenia

Profil mobilny staje się profilem obowiązkowym użytkownika po

Industry Standard Architecture to norma magistrali, według której szerokość szyny danych wynosi

Jakie jest główne zadanie systemu DNS w sieci komputerowej?

Przy użyciu urządzenia zobrazowanego na rysunku możliwe jest sprawdzenie działania

Jaki akronim oznacza wydajność sieci oraz usługi, które mają na celu między innymi priorytetyzację przesyłanych pakietów?

Menadżer rozruchu, który umożliwia wybór systemu operacyjnego Linux do załadowania, to

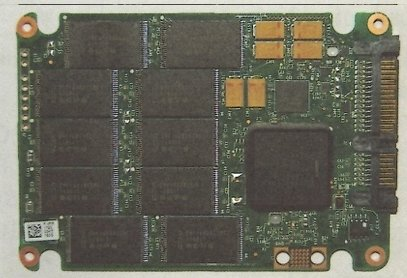

Element systemu komputerowego przedstawiony na ilustracji to

Liczba 10011001100 zaprezentowana w systemie heksadecymalnym ma formę

Co oznacza standard 100Base-T?

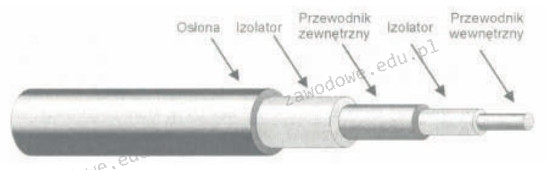

Na ilustracji przedstawiono przekrój kabla

W systemach operacyjnych z rodziny Windows odpowiednikiem programu fsck z systemu Linux jest aplikacja

Zgodnie z normą EIA/TIA T568B, żyły pary odbiorczej w skrętce są pokryte izolatorem w kolorze

Jaki jest pełny adres do logowania na serwer FTP o nazwie ftp.nazwa.pl?

Na ilustracji pokazano interfejs w komputerze dedykowany do podłączenia

Zestaw komputerowy, który został przedstawiony, jest niepełny. Który z elementów nie został wymieniony w tabeli, a jest kluczowy dla prawidłowego funkcjonowania zestawu?

| Lp. | Nazwa podzespołu |

|---|---|

| 1. | Zalman Obudowa R1 Midi Tower bez PSU, USB 3.0 |

| 2. | Gigabyte GA-H110M-S2H, Realtek ALC887, DualDDR4-2133, SATA3, HDMI, DVI, D-Sub, LGA1151, mATX |

| 3. | Intel Core i5-6400, Quad Core, 2.70GHz, 6MB, LGA1151, 14nm, 65W, Intel HD Graphics, VGA, BOX |

| 4. | Patriot Signature DDR4 2x4GB 2133MHz |

| 5. | Seagate BarraCuda, 3.5", 1TB, SATA/600, 7200RPM, 64MB cache |

| 6. | LG SuperMulti SATA DVD+/-R24x,DVD+RW6x,DVD+R DL 8x, bare bulk (czarny) |

| 7. | Gembird Bezprzewodowy Zestaw Klawiatura i Mysz |

| 8. | Monitor Iiyama E2083HSD-B1 19.5inch, TN, HD+, DVI, głośniki |

| 9. | Microsoft OEM Win Home 10 64Bit Polish 1pk DVD |

Który z parametrów okablowania strukturalnego definiuje stosunek mocy sygnału tekstowego w jednej parze do mocy sygnału wyindukowanego w sąsiedniej parze na tym samym końcu kabla?

Jakie urządzenie pozwoli na połączenie kabla światłowodowego zastosowanego w okablowaniu pionowym sieci z przełącznikiem, który ma jedynie złącza RJ45?

Jakie urządzenie należy wykorzystać w sieci Ethernet, aby zredukować liczbę kolizji pakietów?

Router przypisany do interfejsu LAN dysponuje adresem IP 192.168.50.1. Został on skonfigurowany w taki sposób, aby przydzielać komputerom wszystkie dostępne adresy IP w sieci 192.168.50.0 z maską 255.255.255.0. Jaką maksymalną liczbę komputerów można podłączyć w tej sieci?

Jaką komendę należy wpisać w miejsce kropek, aby w systemie Linux wydłużyć standardowy odstęp czasowy między kolejnymi wysyłanymi pakietami przy użyciu polecenia ping?

W normie PN-EN 50174 nie znajdują się wytyczne dotyczące

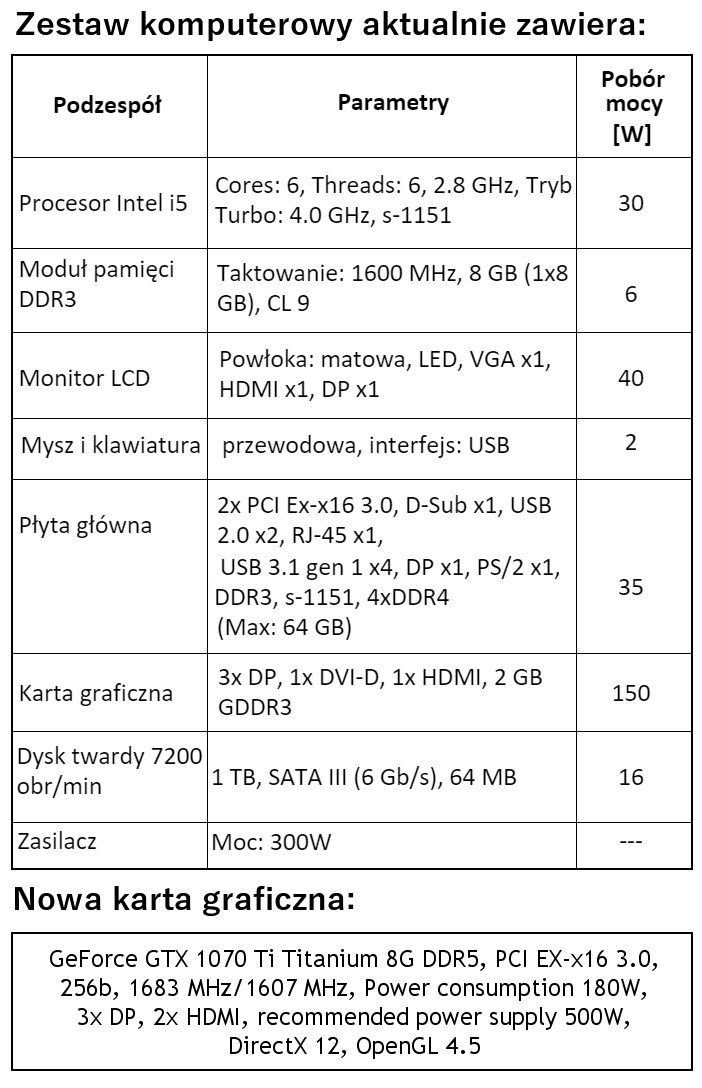

W zestawie komputerowym o parametrach wymienionych w tabeli konieczne jest zastąpienie karty graficznej nową, wskazaną w ramce. W związku z tym modernizacja tego komputera wymaga także wymiany

Plik zajmuje 2KB. Jakie to jest?

Element płyty głównej, który jest odpowiedzialny za wymianę danych między procesorem a innymi komponentami płyty, to

W systemach Windows XP Pro/Windows Vista Business/Windows 7 Pro/Windows 8 Pro, funkcją zapewniającą ochronę danych dla użytkowników dzielących ten sam komputer, których informacje mogą być wykorzystywane wyłącznie przez nich, jest

Jakie są zakresy częstotliwości oraz maksymalne prędkości przesyłu danych w standardzie 802.11g WiFi?

Jaką maskę podsieci powinien mieć serwer DHCP, aby mógł przydzielić adresy IP dla 510 urządzeń w sieci o adresie 192.168.0.0?