Pytanie 1

Program antywirusowy oferowany przez Microsoft bezpłatnie dla posiadaczy legalnych wersji systemu operacyjnego Windows to

Wynik: 10/40 punktów (25,0%)

Wymagane minimum: 20 punktów (50%)

Program antywirusowy oferowany przez Microsoft bezpłatnie dla posiadaczy legalnych wersji systemu operacyjnego Windows to

Do wykonania końcówek kabla UTP wykorzystuje się wtyczkę

Program iftop działający w systemie Linux ma na celu

Jaką nazwę powinien mieć identyfikator, aby urządzenia w sieci mogły działać w danej sieci bezprzewodowej?

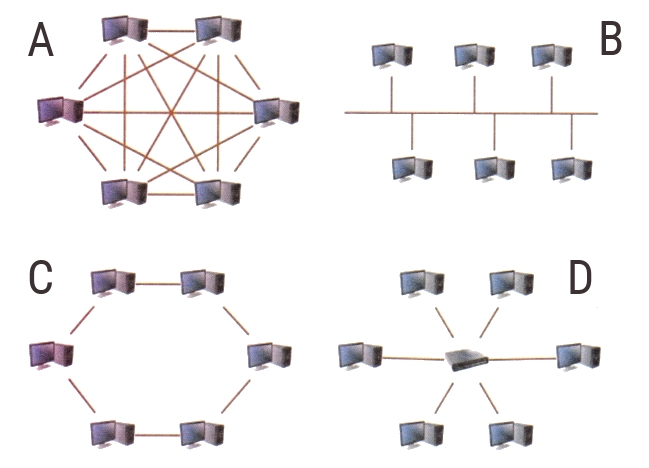

Która z przedstawionych na rysunkach topologii jest topologią siatkową?

Recykling można zdefiniować jako

Co oznacza standard 100Base-T?

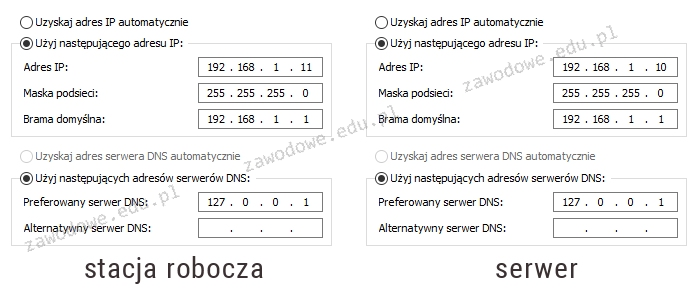

Na schemacie przedstawiono konfigurację protokołu TCP/IP pomiędzy serwerem a stacją roboczą. Na serwerze zainstalowano rolę DNS. Wykonanie polecenia ping www.cke.edu.pl na serwerze zwraca pozytywny wynik, natomiast na stacji roboczej jest on negatywny. Jakie zmiany należy wprowadzić w konfiguracji, aby usługa DNS na stacji funkcjonowała poprawnie?

Administrator systemu Linux wykonał listę zawartości folderu /home/szkola w terminalu, uzyskując następujący wynik -rwx -x r-x 1 admin admin 25 04-09 15:17 szkola.txt. Następnie wpisał polecenie: ```chmod ug=rw szkola.txt | ls -l``` Jaki rezultat jego działania zostanie pokazany w terminalu?

W tabeli zaprezentowano specyfikacje czterech twardych dysków. Dysk, który oferuje najwyższą średnią prędkość odczytu danych, to

| Pojemność | 320 GB | 320 GB | 320 GB | 320 GB |

| Liczba talerzy | 2 | 3 | 2 | 2 |

| Liczba głowic | 4 | 6 | 4 | 4 |

| Prędkość obrotowa | 7200 obr./min | 7200 obr./min | 7200 obr./min | 7200 obr./min |

| Pamięć podręczna | 16 MB | 16 MB | 16 MB | 16 MB |

| Czas dostępu | 8.3 ms | 8.9 ms | 8.5 ms | 8.6 ms |

| Interfejs | SATA II | SATA II | SATA II | SATA II |

| Obsługa NCQ | TAK | NIE | TAK | TAK |

| Dysk | A. | B. | C. | D. |

Interfejs UDMA to typ interfejsu

Jak nazywa się magistrala, która w komputerze łączy procesor z kontrolerem pamięci i składa się z szyny adresowej, szyny danych oraz linii sterujących?

Jednym z zaleceń w zakresie ochrony przed wirusami jest przeprowadzanie skanowania całego systemu. W związku z tym należy skanować komputer

Aby zwiększyć efektywność komputera, można w nim zainstalować procesor wspierający technologię Hyper-Threading, co umożliwia

Program do odzyskiwania danych, stosowany w warunkach domowych, umożliwia przywrócenie danych z dysku twardego w sytuacji

Aby bezpiecznie połączyć się z firmowym serwerem przez Internet i mieć dostęp do zasobów firmy, należy wykorzystać odpowiednie oprogramowanie klienckie

Który z protokołów jest używany do przesyłania plików na serwer?

Wskaż rodzaj wtyczki zasilającej, którą należy połączyć z napędem optycznym podczas montażu komputera.

Które z urządzeń używanych w sieci komputerowej NIE WPŁYWA na liczbę domen kolizyjnych?

W dwóch sąsiadujących pomieszczeniach pewnej firmy występują znaczne zakłócenia elektromagnetyczne. Aby zapewnić maksymalną przepustowość w istniejącej sieci LAN, jakie medium transmisyjne powinno być użyte?

Unity Tweak Tool oraz narzędzia dostrajania to elementy systemu Linux, które mają na celu

Jakie urządzenie sieciowe umożliwia połączenie lokalnej sieci LAN z rozległą siecią WAN?

Zaprezentowany komputer jest niepełny. Który z komponentów nie został wymieniony w tabeli, a jest kluczowy dla poprawnego funkcjonowania zestawu i powinien być dodany?

| Lp. | Nazwa podzespołu |

|---|---|

| 1. | Cooler Master obudowa komputerowa CM Force 500W czarna |

| 2. | Gigabyte GA-H110M-S2H, Realtek ALC887, DualDDR4-2133, SATA3, HDMI, DVI, D-Sub, LGA1151, mATX |

| 3. | Intel Core i5-6400, Quad Core, 2.70GHz, 6MB, LGA1151, 14nm, 65W, Intel HD Graphics, VGA, TRAY/OEM |

| 4. | Patriot Signature DDR4 2x4GB 2133MHz |

| 5. | Seagate BarraCuda, 3,5", 1TB, SATA/600, 7200RPM, 64MB cache |

| 6. | LG SuperMulti SATA DVD+/-R24x,DVD+RW6x,DVD+R DL 8x, bare bulk (czarny) |

| 7. | Gembird Bezprzewodowy Zestaw Klawiatura i Mysz |

| 8. | Monitor Iiyama E2083HSD-B1 19.5inch, TN, HD+, DVI, głośniki |

| 9. | Microsoft OEM Win Home 10 64Bit Polish 1pk DVD |

Częścią zestawu komputerowego, która zajmuje się zarówno przetwarzaniem danych wejściowych, jak i wyjściowych, jest

Jeśli rozdzielczość myszki wynosi 200 dpi, a rozdzielczość monitora to Full HD, to aby przesunąć kursor w poziomie po ekranie, należy przemieścić mysz o

Który z zapisów adresu IPv4 z maską jest niepoprawny?

Który adres IP jest zaliczany do klasy B?

Po zainstalowaniu systemu Linux, użytkownik pragnie skonfigurować kartę sieciową poprzez wprowadzenie ustawień dotyczących sieci. Jakie działanie należy podjąć, aby to osiągnąć?

Jakie będą całkowite koszty materiałów potrzebnych do stworzenia sieci lokalnej dla 6 komputerów, jeśli do budowy sieci wymagane jest 100 m kabla UTP kat. 5e oraz 20 m kanału instalacyjnego? Ceny komponentów sieci przedstawiono w tabeli.

| Elementy sieci | j.m. | cena brutto |

|---|---|---|

| Kabel UTP kat. 5e | m | 1,00 zł |

| Kanał instalacyjny | m | 8,00 zł |

| Gniazdo komputerowe | szt. | 5,00 zł |

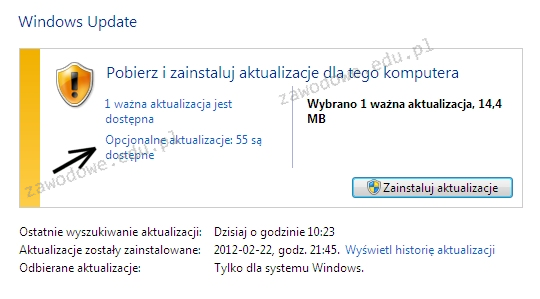

Jeżeli użytkownik zaznaczy opcję wskazaną za pomocą strzałki, będzie miał możliwość instalacji aktualizacji

Podaj właściwe przyporządkowanie usługi z warstwy aplikacji oraz standardowego numeru portu, na którym ta usługa działa?

Protokół ARP (Address Resolution Protocol) pozwala na przypisanie logicznych adresów warstwy sieciowej do rzeczywistych adresów warstwy

Który kolor żyły znajduje się w kablu skrętkowym?

Osobom pracującym zdalnie, dostęp do serwera znajdującego się w prywatnej sieci za pośrednictwem publicznej infrastruktury, jaką jest Internet, umożliwia

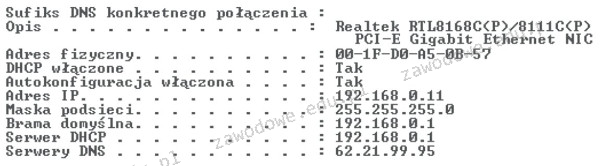

Na skutek użycia polecenia ipconfig uzyskano konfigurację przedstawioną na ilustracji. Jaki jest adres IP stacji roboczej, która została poddana testom?

Jednym z metod ograniczenia dostępu do sieci bezprzewodowej dla osób nieuprawnionych jest

Oprogramowanie, które regularnie przerywa działanie przez pokazanie komunikatu o konieczności uiszczenia opłaty, co prowadzi do zniknięcia tego komunikatu, jest dystrybuowane na podstawie licencji

Aby zrealizować transfer danych pomiędzy siecią w pracowni a siecią ogólnoszkolną, która ma inną adresację IP, należy zastosować

Zgodnie z normą Fast Ethernet 100Base-TX, maksymalna długość kabla miedzianego UTP kategorii 5e, który łączy bezpośrednio dwa urządzenia sieciowe, wynosi

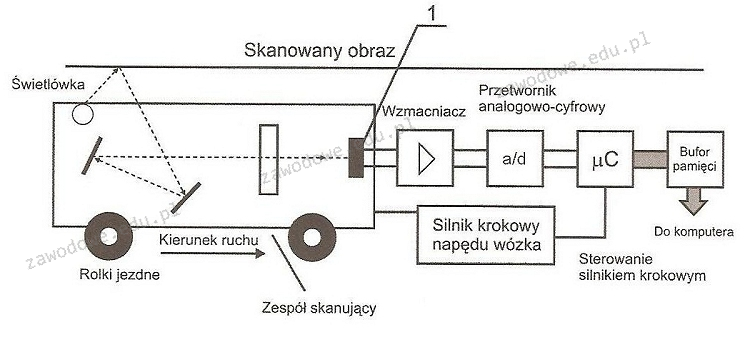

Na diagramie działania skanera, element oznaczony numerem 1 odpowiada za