Pytanie 1

Które z poniższych stwierdzeń dotyczących konta użytkownika Active Directory w systemie Windows jest prawdziwe?

Wynik: 11/40 punktów (27,5%)

Wymagane minimum: 20 punktów (50%)

Które z poniższych stwierdzeń dotyczących konta użytkownika Active Directory w systemie Windows jest prawdziwe?

Jaki adres IPv6 jest stosowany jako adres link-local w procesie autokonfiguracji urządzeń?

Router przypisany do interfejsu LAN dysponuje adresem IP 192.168.50.1. Został on skonfigurowany w taki sposób, aby przydzielać komputerom wszystkie dostępne adresy IP w sieci 192.168.50.0 z maską 255.255.255.0. Jaką maksymalną liczbę komputerów można podłączyć w tej sieci?

Shareware to typ licencji, która polega na

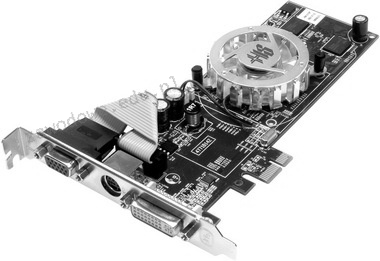

Urządzenie przedstawione na rysunku

Administrator sieci LAN dostrzegł przełączenie w tryb awaryjny urządzenia UPS. To oznacza, że wystąpiła awaria systemu

Możliwość weryfikacji poprawności działania pamięci RAM można uzyskać za pomocą programu diagnostycznego

Domyślnie dostęp anonimowy do zasobów serwera FTP umożliwia

Metoda transmisji żetonu (ang. token) znajduje zastosowanie w topologii

Jakim protokołem jest realizowana kontrola poprawności transmisji danych w sieciach Ethernet?

Jakie urządzenie należy zastosować do pomiaru mocy zużywanej przez komputer?

Jakie urządzenie w warstwie łącza danych modelu OSI analizuje adresy MAC zawarte w ramkach Ethernet i na tej podstawie decyduje o przesyłaniu sygnału pomiędzy segmentami sieci lub jego blokowaniu?

Zaprezentowane narzędzie jest wykorzystywane do

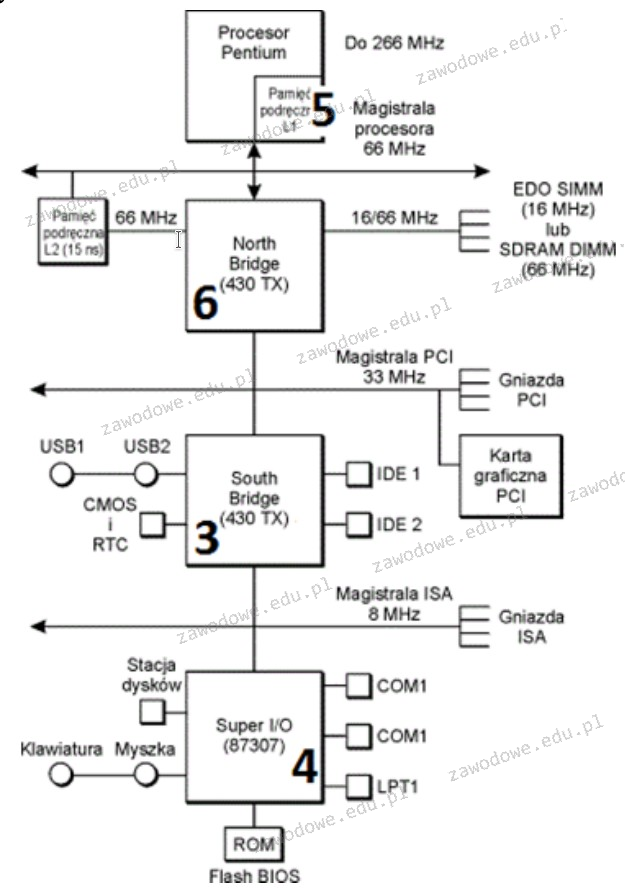

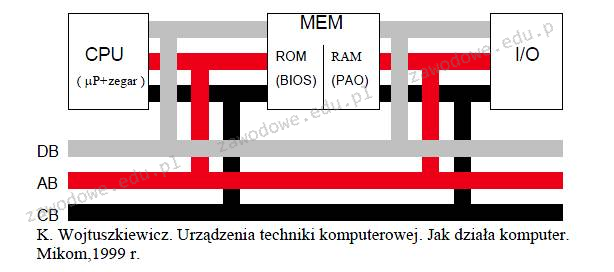

Część płyty głównej, która odpowiada za transmisję danych pomiędzy mikroprocesorem a pamięcią operacyjną RAM oraz magistralą karty graficznej, jest oznaczona na rysunku numerem

Norma opisująca standard transmisji Gigabit Ethernet to

Kabel typu skrętka, w którym każda para żył jest umieszczona w oddzielnym ekranie z folii, a wszystkie przewody znajdują się w jednym ekranie, ma oznaczenie

W jaki sposób oznaczona jest skrętka bez zewnętrznego ekranu, mająca każdą parę w osobnym ekranie folii?

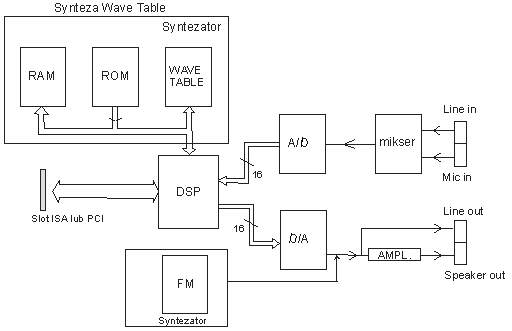

Na które wyjście powinniśmy podłączyć aktywne głośniki w karcie dźwiękowej, której schemat przedstawiony jest na rysunku?

Uzyskanie przechowywania kopii często odwiedzanych witryn oraz zwiększenia bezpieczeństwa przez odfiltrowanie konkretnych treści w sieci Internet można osiągnąć dzięki

Na stabilność obrazu w monitorach CRT istotny wpływ ma

W celu zapewnienia jakości usługi QoS, w przełącznikach warstwy dostępu stosuje się mechanizm

W systemie Linux zarządzanie parametrami transmisji w sieciach bezprzewodowych jest możliwe dzięki

W systemach operacyjnych Windows konto użytkownika, które ma najwyższe domyślne uprawnienia, należy do grupy

Jak najlepiej chronić zebrane dane przed dostępem w przypadku kradzieży komputera?

Z informacji przedstawionych w tabeli wynika, że efektywna częstotliwość pamięci DDR SDRAM wynosi

| 184 styki |

| 64-bitowa szyna danych |

| Pojemność 1024 MB |

| Przepustowość 3200 MB/s |

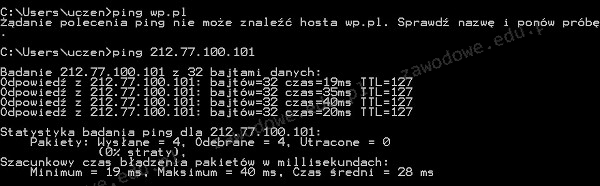

Podczas testowania połączeń sieciowych za pomocą polecenia ping użytkownik otrzymał wyniki przedstawione na rysunku. Jakie może być źródło braku odpowiedzi serwera przy pierwszym teście, zakładając, że domena wp.pl ma adres 212.77.100.101?

Ile par kabli w standardzie 100Base-TX jest używanych do transmisji danych w obie strony?

Jakie złącze na płycie głównej komputera jest przeznaczone do zamontowania karty graficznej widocznej na powyższym obrazie?

Protokół pakietów użytkownika, który zapewnia dostarczanie datagramów w trybie bezpołączeniowym, to

Który z komponentów komputera, gdy zasilanie jest wyłączone, zachowuje program inicjujący uruchamianie systemu operacyjnego?

Rekord startowy dysku twardego w komputerze to

Kod BREAK interpretowany przez system elektroniczny klawiatury wskazuje na

Wskaż technologię stosowaną do zapewnienia dostępu do Internetu w połączeniu z usługą telewizji kablowej, w której światłowód oraz kabel koncentryczny pełnią rolę medium transmisyjnego

Jakie jest zadanie usługi DNS?

Dokument mający na celu przedstawienie oferty cenowej dla inwestora dotyczącej przeprowadzenia robót instalacyjnych w sieci komputerowej, to

Ile adresów urządzeń w sieci jest dostępnych dzięki zastosowaniu klasy adresowej C w systemach opartych na protokołach TCP/IP?

Aby zmierzyć moc zużywaną przez komputer, należy zastosować

Jaką minimalną ilość pamięci RAM musi mieć komputer, aby móc uruchomić 64-bitowy system operacyjny Windows 7 w trybie graficznym?

Jak nazywa się serwer Windows, na którym zainstalowano usługę Active Directory?

Aby system operacyjny mógł szybciej uzyskiwać dostęp do plików na dysku twardym, należy wykonać