Pytanie 1

Jakie jest najwyższe możliwe tempo odczytu płyt CD-R w urządzeniu o oznaczeniu x48?

Wynik: 17/40 punktów (42,5%)

Wymagane minimum: 20 punktów (50%)

Jakie jest najwyższe możliwe tempo odczytu płyt CD-R w urządzeniu o oznaczeniu x48?

Jakie polecenie w systemie operacyjnym Linux służy do monitorowania komunikacji protokołów TCP/IP lub innych przesyłanych lub odbieranych w sieci komputerowej, do której jest podłączony komputer użytkownika?

W dokumentacji jednego z komponentów komputera zawarto informację, że urządzenie obsługuje OpenGL. Jakiego elementu dotyczy ta dokumentacja?

Aby zmienić port drukarki zainstalowanej w systemie Windows, która funkcja powinna zostać użyta?

Adres IP 192.168.2.0/24 został podzielony na 8 podsieci. Jaką maskę należy zastosować dla tych nowych podsieci?

Aby zwiększyć lub zmniejszyć rozmiar ikony na pulpicie, należy obracać kółkiem myszy, trzymając jednocześnie wciśnięty klawisz

Podczas skanowania reprodukcji obrazu z magazynu, na skanie pojawiły się regularne wzory, zwane morą. Jaką funkcję skanera należy zastosować, aby pozbyć się mory?

W tabeli zaprezentowano parametry trzech dysków twardych w standardzie Ultra320 SCSI. Te dyski są w stanie osiągnąć maksymalny transfer wewnętrzny

| Rotational Speed | 10,025 rpm | ||

| Capacity (Formatted) | 73.5GB | 147GB | 300GB |

| Number of Heads | 2 | 5 | 8 |

| Number of Disks | 1 | 3 | 4 |

| Internal Transfer Rate | Up to 132 MB/s | ||

| Interface Transfer Rate | NP/NC = 320MB/s, FC = 200MB/s | ||

| Buffer Size | |||

| Average Seek (Read/Write) | 4.5/5.0 ms | ||

| Track-to-Track Seek/Read/Write | 0.2ms/0.4ms | ||

| Maximum Seek (Read/Write) | 10/11 ms | ||

| Average Latency | 2.99 ms | ||

| Power Consumption (Idle) | NP/NC = 9.5W, FC = 10.5W | ||

| Acoustic Noise | 3.4 bels | ||

| Shock - Operating/Non-Operating | 65G/225G 2ms | ||

Interfejs SATA 2 (3Gb/s) oferuje prędkość transferu

Uruchomienie polecenia msconfig w systemie Windows

Jakie oprogramowanie służy do sprawdzania sterowników w systemie Windows?

Jak w systemie Windows zmienić port drukarki, która została zainstalowana?

Aby poprawić wydajność procesora serii Intel za pomocą 'podkręcania' (ang. overclocking), należy użyć procesora oznaczonego

Konwencja zapisu ścieżki do udziału sieciowego zgodna z UNC (Universal Naming Convention) ma postać

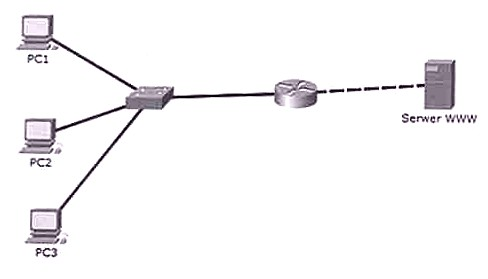

Użytkownicy w sieci lokalnej mogą się komunikować między sobą, lecz nie mają dostępu do serwera WWW. Wynik polecenia ping z komputerów bramy jest pozytywny. Który komponent sieci NIE MOŻE być powodem problemu?

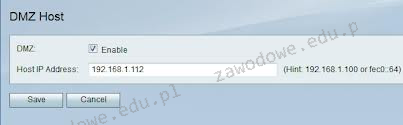

Na ilustracji widać zrzut ekranu ustawień strefy DMZ na routerze. Aktywacja opcji "Enable DMZ" spowoduje, że komputer z adresem IP 192.168.0.106

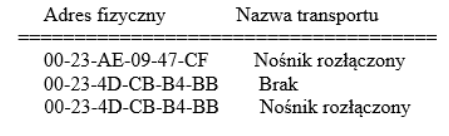

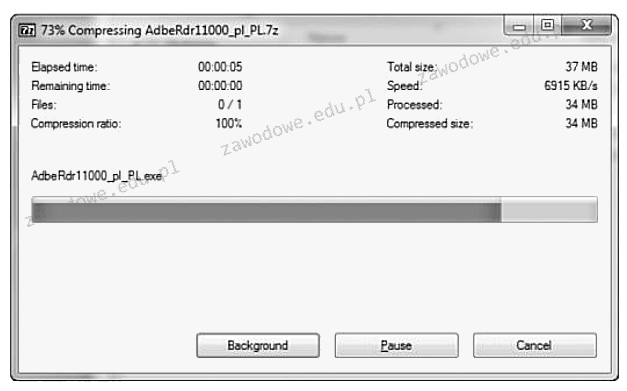

Jakie polecenie systemu Windows przedstawione jest na ilustracji?

Wskaż tryb operacyjny, w którym komputer wykorzystuje najmniej energii

Zgodnie z wytycznymi dotyczącymi karty graficznej, jej możliwości pracy z systemem AGP 2X/4X pozwalają na

Jakie urządzenie pozwala na połączenie lokalnej sieci komputerowej z Internetem?

W systemie Windows harmonogram zadań umożliwia przydzielenie

Aby zweryfikować mapę połączeń kabla UTP Cat 5e w sieci lokalnej, konieczne jest wykorzystanie

Wskaż program do składu publikacji

Główny sposób zabezpieczania danych w sieciach komputerowych przed dostępem nieautoryzowanym to

Który adres IPv4 odpowiada adresowi IPv6 ::1?

Do czego służy program firewall?

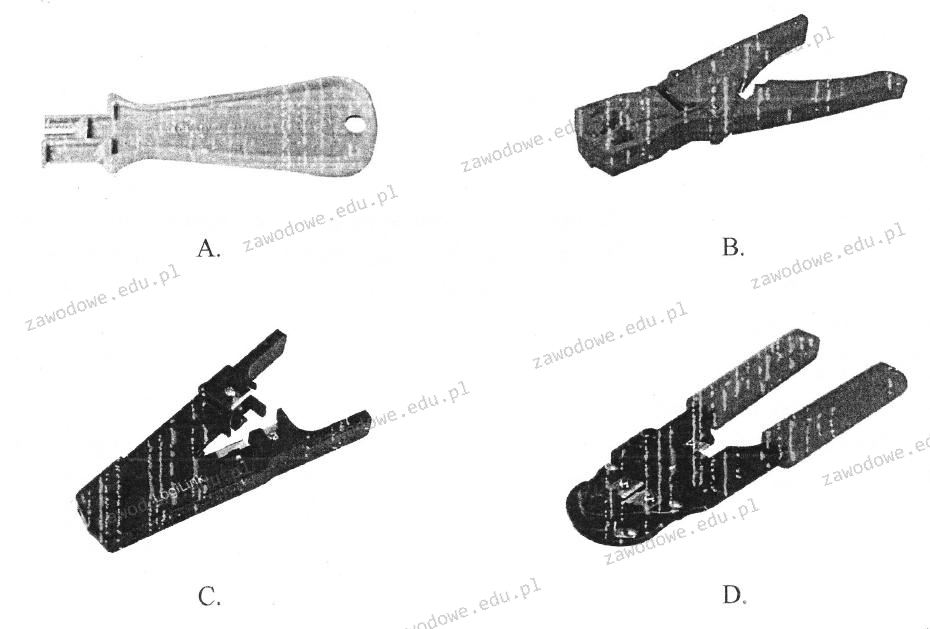

Na załączonym zdjęciu znajduje się

Jaki instrument jest używany do usuwania izolacji?

Technologia procesorów z serii Intel Core, wykorzystywana w układach i5, i7 oraz i9, umożliwiająca podniesienie częstotliwości w sytuacji, gdy komputer potrzebuje większej mocy obliczeniowej, to

Do jakiej grupy w systemie Windows Server 2008 powinien być przypisany użytkownik odpowiedzialny jedynie za archiwizację danych zgromadzonych na dysku serwera?

Z jaką informacją wiąże się parametr TTL po wykonaniu polecenia ping?

Na dołączonym obrazku pokazano działanie

Jakie będą całkowite koszty materiałów potrzebnych do stworzenia sieci lokalnej dla 6 komputerów, jeśli do budowy sieci wymagane jest 100 m kabla UTP kat. 5e oraz 20 m kanału instalacyjnego? Ceny komponentów sieci przedstawiono w tabeli.

| Elementy sieci | j.m. | cena brutto |

|---|---|---|

| Kabel UTP kat. 5e | m | 1,00 zł |

| Kanał instalacyjny | m | 8,00 zł |

| Gniazdo komputerowe | szt. | 5,00 zł |

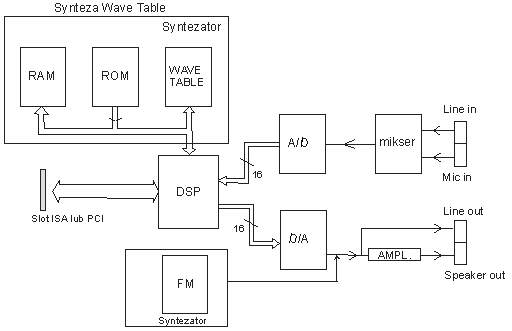

Na które wyjście powinniśmy podłączyć aktywne głośniki w karcie dźwiękowej, której schemat przedstawiony jest na rysunku?

Zgodnie z normą PN-EN 50174, okablowanie poziome w systemie okablowania strukturalnego to segment okablowania pomiędzy

Domyślnie dostęp anonimowy do zasobów serwera FTP umożliwia

Jaki protokół posługuje się portami 20 oraz 21?

W skanerze z systemem CIS źródłem światła oświetlającym skanowany dokument jest

Źródłem problemu z wydrukiem z przedstawionej na rysunku drukarki laserowej jest

Aby połączyć dwa przełączniki oddalone o 200 m i osiągnąć minimalną przepustowość 200 Mbit/s, jakie rozwiązanie należy zastosować?