Pytanie 1

Jakie jest najbardziej typowe dla topologii gwiazdy?

Wynik: 21/40 punktów (52,5%)

Wymagane minimum: 20 punktów (50%)

Jakie jest najbardziej typowe dla topologii gwiazdy?

Czynnikiem zagrażającym bezpieczeństwu systemu operacyjnego, który wymusza jego automatyczne aktualizacje, są

W sieci z maską 255.255.255.128 można przypisać adresy dla

Jakie polecenie w systemie operacyjnym Linux umożliwia sprawdzenie bieżącej konfiguracji interfejsu sieciowego na komputerze?

Jakie pasmo częstotliwości definiuje klasa okablowania D?

Firma Dyn, której serwery DNS zostały zaatakowane, przyznała, że część tego ataku … miała miejsce z użyciem różnych urządzeń podłączonych do sieci. Ekosystem kamer, czujników i kontrolerów określany ogólnie jako 'Internet rzeczy' został wykorzystany przez cyberprzestępców jako botnet − sieć maszyn-zombie. Jakiego rodzaju atak jest opisany w tym cytacie?

Co może być przyczyną problemów z wydrukiem z drukarki laserowej przedstawionych na ilustracji?

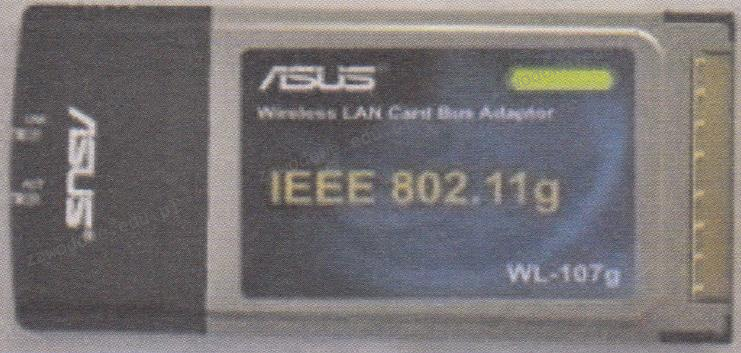

Karta sieciowa przedstawiona na ilustracji ma zdolność przesyłania danych z maksymalną prędkością

Jakie polecenie należy wydać, aby skonfigurować statyczny routing do sieci 192.168.10.0?

Jaką ochronę zapewnia program antyspyware?

Aby obserwować przesył danych w sieci komputerowej, należy wykorzystać program typu

Co oznacza standard ACPI w BIOSie komputera?

Jakie oprogramowanie nie jest przeznaczone do diagnozowania komponentów komputera?

Jaki standard Ethernet należy wybrać przy bezpośrednim połączeniu urządzeń sieciowych, które dzieli odległość 1 km?

Zainstalowanie w komputerze wskazanej karty pozwoli na

Jaki protokół jest używany do ściągania wiadomości e-mail z serwera pocztowego na komputer użytkownika?

Do czego służy nóż uderzeniowy?

Możliwą przyczyną usterki drukarki igłowej może być awaria

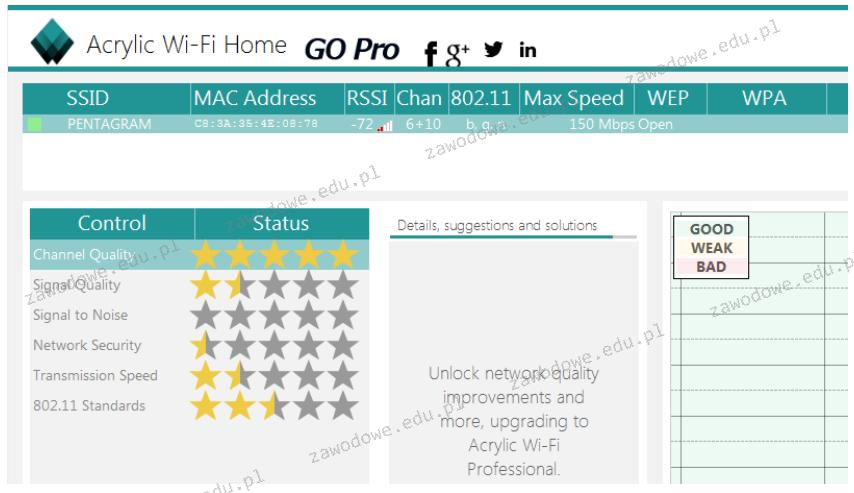

Wykonano test przy użyciu programu Acrylic Wi-Fi Home, a wyniki przedstawiono na zrzucie ekranu. Na ich podstawie można wnioskować, że dostępna sieć bezprzewodowa

Nośniki informacji, takie jak dysk twardy, gromadzą dane w jednostkach określanych jako sektory, których rozmiar wynosi

Jakie polecenie w systemie Linux pokazuje czas działania systemu oraz jego średnie obciążenie?

Która karta graficzna nie będzie kompatybilna z monitorem, który posiada złącza pokazane na zdjęciu, przy założeniu, że do podłączenia monitora nie użyjemy adaptera?

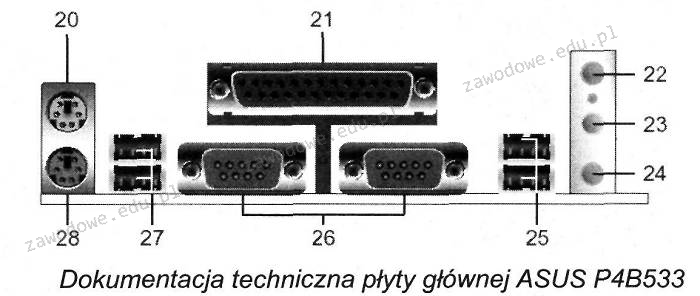

Na zaprezentowanej płycie głównej komputera złącza oznaczono cyframi 25 i 27

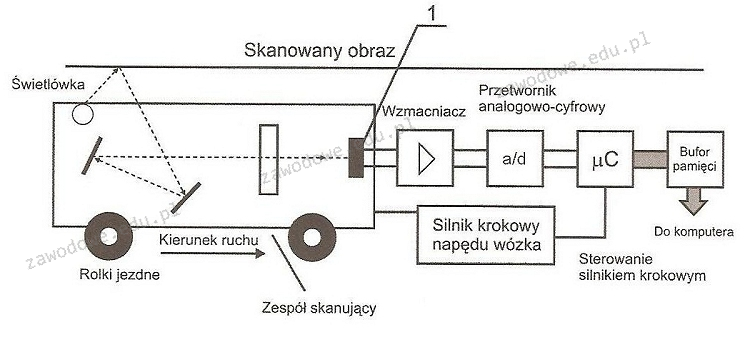

Na diagramie działania skanera, element oznaczony numerem 1 odpowiada za

Jakie składniki systemu komputerowego wymagają utylizacji w wyspecjalizowanych zakładach przetwarzania z powodu obecności niebezpiecznych substancji lub pierwiastków chemicznych?

Jakie polecenia należy zrealizować, aby zamontować pierwszą partycję logiczną dysku primary slave w systemie Linux?

Jaką rolę należy przypisać serwerowi z rodziny Windows Server, aby mógł świadczyć usługi rutingu?

Zidentyfikuj urządzenie przedstawione na ilustracji

Aby połączyć projektor multimedialny z komputerem, nie można zastosować złącza

Komputer zainstalowany w domenie Active Directory nie jest w stanie nawiązać połączenia z kontrolerem domeny, na którym znajduje się profil użytkownika. Jaki rodzaj profilu użytkownika zostanie stworzony na tym urządzeniu?

Jakie parametry otrzyma interfejs sieciowy eth0 po wykonaniu poniższych poleceń w systemie Linux?

Komunikat "BIOS checksum error" pojawiający się podczas uruchamiania komputera zazwyczaj wskazuje na

Aby poprawić organizację plików na dysku i przyspieszyć działanie systemu, co należy zrobić?

Adresy IPv6 są reprezentowane jako liczby

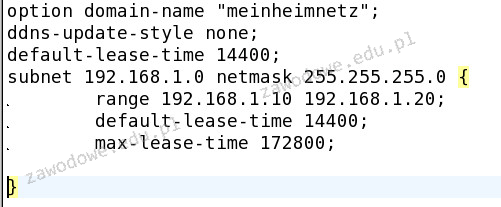

Poniżej zaprezentowano fragment pliku konfiguracyjnego serwera w systemie Linux. Jaką usługi dotyczy ten fragment?

Który z protokołów służy do weryfikacji poprawności połączenia pomiędzy dwoma hostami?

Na ilustracji pokazano końcówkę kabla

Jakie urządzenie sieciowe widnieje na ilustracji?

Podczas analizy ruchu sieciowego przy użyciu sniffera zauważono, że urządzenia przesyłają dane na portach 20 oraz 21. Przyjmując standardową konfigurację, oznacza to, że analizowanym protokołem jest protokół

Tworzenie zaszyfrowanych połączeń pomiędzy hostami przez publiczną sieć Internet, wykorzystywane w rozwiązaniach VPN (Virtual Private Network), to