Pytanie 1

Narzędzie służące do oceny wydajności systemu komputerowego to

Wynik: 27/40 punktów (67,5%)

Wymagane minimum: 20 punktów (50%)

Narzędzie służące do oceny wydajności systemu komputerowego to

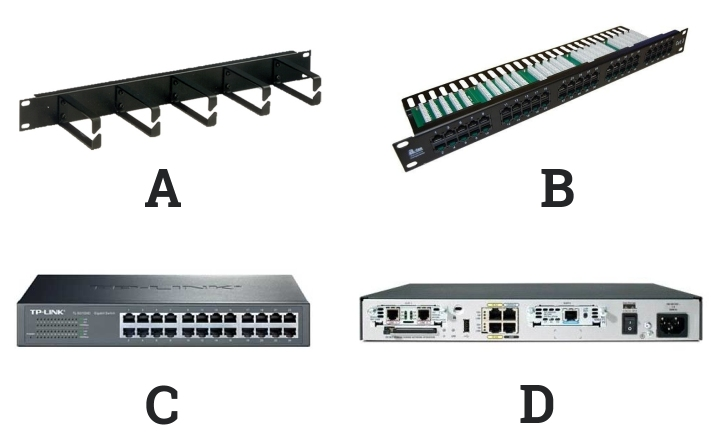

Na którym schemacie znajduje się panel krosowniczy?

Ile par przewodów miedzianej skrętki kategorii 5e jest używanych do transmisji danych w standardzie sieci Ethernet 100Base-TX?

Umowa, na podstawie której użytkownik ma między innymi dostęp do kodu źródłowego oprogramowania w celu jego analizy i ulepszania, to licencja

W tabeli zaprezentowano parametry trzech dysków twardych w standardzie Ultra320 SCSI. Te dyski są w stanie osiągnąć maksymalny transfer wewnętrzny

| Rotational Speed | 10,025 rpm | ||

| Capacity (Formatted) | 73.5GB | 147GB | 300GB |

| Number of Heads | 2 | 5 | 8 |

| Number of Disks | 1 | 3 | 4 |

| Internal Transfer Rate | Up to 132 MB/s | ||

| Interface Transfer Rate | NP/NC = 320MB/s, FC = 200MB/s | ||

| Buffer Size | |||

| Average Seek (Read/Write) | 4.5/5.0 ms | ||

| Track-to-Track Seek/Read/Write | 0.2ms/0.4ms | ||

| Maximum Seek (Read/Write) | 10/11 ms | ||

| Average Latency | 2.99 ms | ||

| Power Consumption (Idle) | NP/NC = 9.5W, FC = 10.5W | ||

| Acoustic Noise | 3.4 bels | ||

| Shock - Operating/Non-Operating | 65G/225G 2ms | ||

Jaką normę stosuje się w przypadku okablowania strukturalnego w sieciach komputerowych?

Wskaż symbol umieszczany na urządzeniach elektrycznych przeznaczonych do sprzedaży i obrotu w Unii Europejskiej?

Jakiej klasy adresów IPv4 dotyczą adresy, które mają dwa najbardziej znaczące bity ustawione na 10?

W jakiej topologii sieci fizycznej każdy komputer jest połączony z dokładnie dwoma sąsiadującymi komputerami, bez użycia dodatkowych urządzeń aktywnych?

Które z poniższych stwierdzeń odnosi się do sieci P2P - peer to peer?

W technologii Ethernet protokół dostępu do medium CSMA/CD jest metodą z

Który z standardów korzysta z częstotliwości 5 GHz?

W klasycznym adresowaniu, adres IP 74.100.7.8 przyporządkowany jest do

Jakie właściwości topologii fizycznej sieci zostały przedstawione w poniższej ramce?

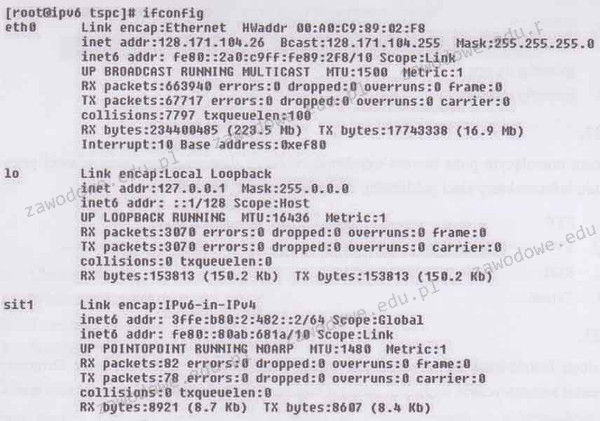

Jaki adres IP został przypisany do hosta na interfejsie sieciowym eth0?

Menedżer usług IIS (Internet Information Services) w systemie Windows stanowi graficzny interfejs do konfiguracji serwera

Jaką wartość ma największa liczba 16-bitowa?

W zestawieniu przedstawiono istotne parametry techniczne dwóch typów interfejsów. Z powyższego wynika, że SATA w porównaniu do ATA charakteryzuje się

| Table Comparison of parallel ATA and SATA | ||

|---|---|---|

| Parallel ATA | SATA 1.5 Gb/s | |

| Bandwidth | 133 MB/s | 150 MB/s |

| Volts | 5V | 250 mV |

| Number of pins | 40 | 7 |

| Cable length | 18 in. (45.7 cm) | 39 in. (1 m) |

Przed rozpoczęciem instalacji sterownika dla urządzenia peryferyjnego system Windows powinien weryfikować, czy dany sterownik ma podpis

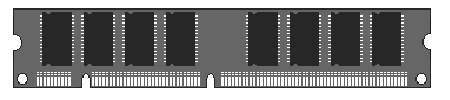

Ilustracja przedstawia rodzaj pamięci

W tabeli przedstawiono numery podzespołów, które są ze sobą kompatybilne

| Lp. | Podzespół | Parametry |

|---|---|---|

| 1. | Procesor | INTEL COREi3-4350- 3.60 GHz, x2/4, 4 MB, 54W, HD 4600, BOX, s-1150 |

| 2. | Procesor | AMD Ryzen 7 1800X, 3.60 GHz, 95W, s-AM4 |

| 3. | Płyta główna | GIGABYTE ATX, X99, 4x DDR3, 4x PCI-E 16x, RAID, HDMI, D-Port, D-SUB, 2x USB 3.1, 8 x USB 2.0, S-AM3+ |

| 4. | Płyta główna | Asus CROSSHAIR VI HERO, X370, SATA3, 4xDDR4, USB3.1, ATX, WI-FI AC, s- AM4 |

| 5. | Pamięć RAM | Corsair Vengeance LPX, DDR4 2x16GB, 3000MHz, CL15 black |

| 6. | Pamięć RAM | Crucial Ballistix DDR3, 2x8GB, 1600MHz, CL9, black |

Na wyświetlaczu drukarki widnieje komunikat "PAPER JAM". Aby zlikwidować problem, należy w pierwszej kolejności

Jaki adres IP w formacie dziesiętnym odpowiada adresowi IP 10101010.00001111.10100000.11111100 zapisanym w formacie binarnym?

Jaki jest maksymalny promień zgięcia przy montażu kabla U/UTP kat 5e?

Zastosowanie symulacji stanów logicznych w obwodach cyfrowych pozwala na

Najefektywniejszym sposobem dodania skrótu do aplikacji na pulpitach wszystkich użytkowników w domenie będzie

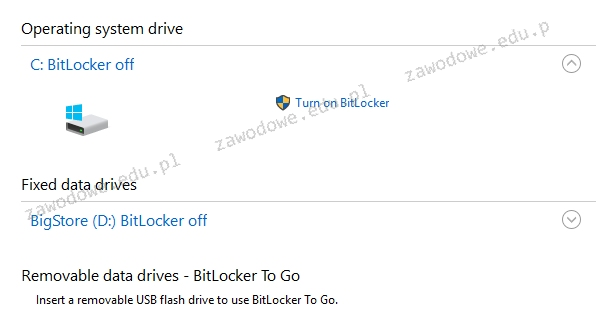

Prezentowane wbudowane narzędzie systemów Windows w wersji Enterprise lub Ultimate jest przeznaczone do

Shareware to typ licencji, który opiera się na

Wykonanie na komputerze z systemem Windows kolejno poleceń ```ipconfig /release``` oraz ```ipconfig /renew``` umożliwi zweryfikowanie, czy usługa w sieci funkcjonuje poprawnie

Osobiste prawo autorskie twórcy do software'u

Jakie informacje można uzyskać dzięki programowi Wireshark?

Oprogramowanie komputerowe, które można używać bezpłatnie i bez czasowych ograniczeń, jest udostępniane na mocy licencji typu

Brak zabezpieczeń przed utratą danych w wyniku fizycznej awarii jednego z dysków to właściwość

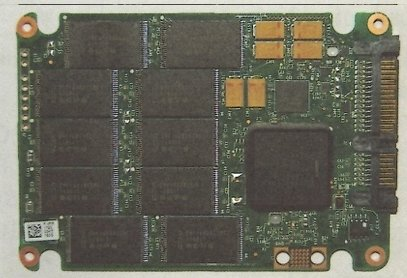

Element elektroniczny przedstawiony na ilustracji to:

Który standard złącza DVI pozwala na przesyłanie wyłącznie sygnałów analogowych?

Aby zapobiec uszkodzeniu układów scalonych, podczas konserwacji sprzętu komputerowego należy używać

Jakie znaczenie ma parametr NVP (Nominal Velocity of Propagation) podczas pomiarów okablowania strukturalnego?

W schemacie logicznym struktury okablowania, zgodnie z polską terminologią zawartą w normie PN-EN 50174, cechą kondygnacyjnego punktu dystrybucyjnego jest to, że

Które stwierdzenie opisuje profil tymczasowy użytkownika?

Element systemu komputerowego przedstawiony na ilustracji to