Pytanie 1

Kabel pokazany na ilustracji może być zastosowany do realizacji okablowania sieci o standardzie

Wynik: 22/40 punktów (55,0%)

Wymagane minimum: 20 punktów (50%)

Kabel pokazany na ilustracji może być zastosowany do realizacji okablowania sieci o standardzie

Na rysunku można zobaczyć schemat topologii fizycznej, która jest kombinacją topologii

Z analizy oznaczenia pamięci DDR3 PC3-16000 można wywnioskować, że ta pamięć:

Prawo osobiste twórcy do oprogramowania komputerowego

Jaki jest główny cel stosowania maski podsieci?

Użytkownik systemu Windows doświadcza komunikatów o niewystarczającej pamięci wirtualnej. Jak można rozwiązać ten problem?

Na którym z zewnętrznych nośników danych nie dojdzie do przeniknięcia wirusa podczas przeglądania jego zawartości?

Nie wykorzystuje się do zdalnego kierowania stacjami roboczymi

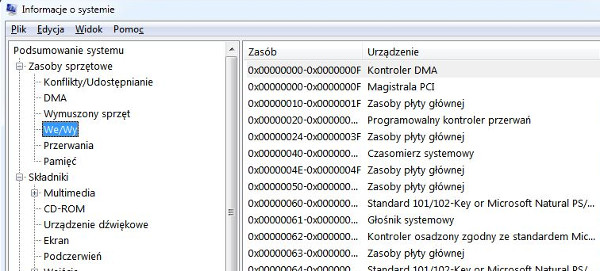

W jakim systemie numerycznym przedstawione są zakresy We/Wy na ilustracji?

Wyjście audio dla słuchawek lub głośników minijack na karcie dźwiękowej oznaczone jest jakim kolorem?

Jakie urządzenie pełni rolę wskaźnika?

Aby uniknąć różnic w kolorystyce pomiędzy zeskanowanymi zdjęciami na wyświetlaczu komputera a ich oryginałami, konieczne jest przeprowadzenie

Jaką zmianę sygnału realizuje konwerter RAMDAC?

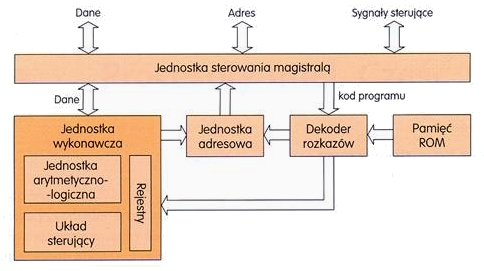

Na ilustracji przedstawiony jest schemat konstrukcji logicznej

Norma opisująca standard transmisji Gigabit Ethernet to

Nie jest możliwe tworzenie okresowych kopii zapasowych z dysku serwera na przenośnych nośnikach typu

W jakiej topologii sieci komputerowej każdy węzeł ma bezpośrednie połączenie z każdym innym węzłem?

Oprogramowanie, które często przerywa działanie przez wyświetlanie komunikatu o konieczności dokonania zapłaty, a które spowoduje zniknięcie tego komunikatu, jest dystrybuowane na podstawie licencji

Kluczowy sposób zabezpieczenia danych w sieci komputerowej przed nieautoryzowanym dostępem to

Symbol przedstawiony na ilustracji oznacza produkt

Który port stosowany jest przez protokół FTP (File Transfer Protocol) do przesyłania danych?

Jakie narzędzie w systemie Windows Server umożliwia zarządzanie zasadami grupy?

Aktywacja opcji Udostępnienie połączenia internetowego w systemie Windows powoduje automatyczne przydzielanie adresów IP dla komputerów (hostów) z niej korzystających. W tym celu używana jest usługa

Oprogramowanie diagnostyczne komputera pokazało komunikat NIC ERROR. Co ten komunikat wskazuje?

Jakie polecenie umożliwia uzyskanie danych dotyczących bieżących połączeń TCP oraz informacji o portach źródłowych i docelowych?

Która usługa pozwala na zdalne zainstalowanie systemu operacyjnego?

W jakiej topologii fizycznej sieci każde urządzenie w sieci posiada dokładnie dwa połączenia, jedno z każdym z sąsiadów, a dane są przesyłane z jednego komputera do drugiego w formie pętli?

W jakim systemie jest przedstawiona liczba 1010(o)?

Po przeprowadzeniu eksportu klucza HKCR zostanie utworzona kopia rejestru, zawierająca dane dotyczące konfiguracji

Jaka jest maksymalna ilość pamięci RAM w GB, do której może uzyskać dostęp 32-bitowa wersja systemu Windows?

Aby zminimalizować wpływ zakłóceń elektromagnetycznych na przesyłany sygnał w tworzonej sieci komputerowej, jakie rozwiązanie należy zastosować?

Urządzenie pokazane na ilustracji służy do

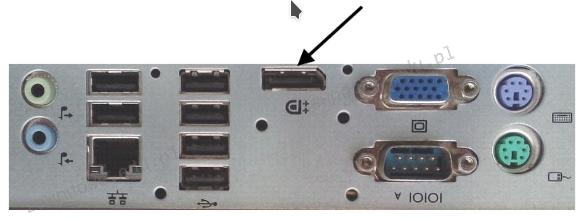

Na ilustracji ukazany jest tylny panel stacji roboczej. Strzałką wskazano port

W schemacie logicznym okablowania strukturalnego, zgodnie z terminologią polską zawartą w normie PN-EN 50174, cechą kondygnacyjnego punktu dystrybucyjnego jest to, że

Użytkownik systemu Windows może skorzystać z polecenia taskmgr, aby

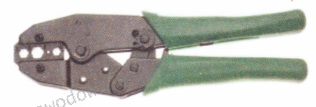

Do jakiego typu wtyków przeznaczona jest zaciskarka pokazana na ilustracji?

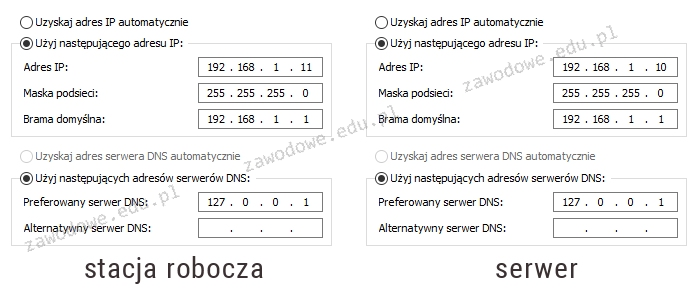

Na schemacie przedstawiono konfigurację protokołu TCP/IP pomiędzy serwerem a stacją roboczą. Na serwerze zainstalowano rolę DNS. Wykonanie polecenia ping www.cke.edu.pl na serwerze zwraca pozytywny wynik, natomiast na stacji roboczej jest on negatywny. Jakie zmiany należy wprowadzić w konfiguracji, aby usługa DNS na stacji funkcjonowała poprawnie?

Tworzenie obrazu dysku ma na celu

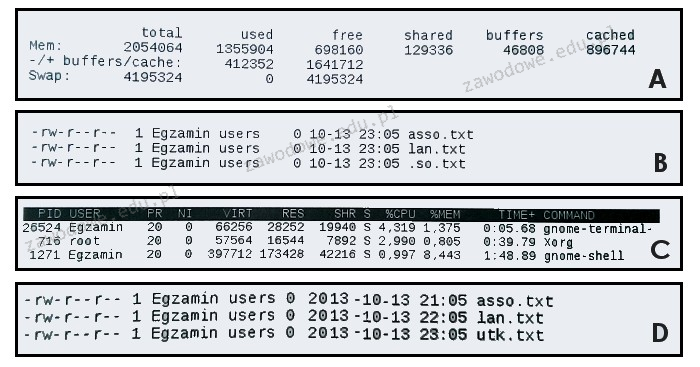

Wynik wykonania polecenia ```ls -l``` w systemie Linux przedstawia poniższy rysunek

Komputer jest podłączony do sieci Internet, a na jego pokładzie brak oprogramowania antywirusowego. Jak można sprawdzić, czy ten komputer jest zainfekowany wirusem, nie zmieniając ustawień systemowych?