Pytanie 1

Symbol "LGA 775" obecny w dokumentacji technicznej płyty głównej wskazuje na typ gniazda dla procesorów:

Wynik: 22/40 punktów (55,0%)

Wymagane minimum: 20 punktów (50%)

Symbol "LGA 775" obecny w dokumentacji technicznej płyty głównej wskazuje na typ gniazda dla procesorów:

Jakiego numeru kodu należy użyć w komendzie do zmiany uprawnień folderu w systemie Linux, aby właściciel miał dostęp do zapisu i odczytu, grupa miała prawo do odczytu i wykonania, a pozostali użytkownicy mogli jedynie odczytywać zawartość?

Która z wymienionych technologii pamięci RAM wykorzystuje oba zbocza sygnału zegarowego do przesyłania danych?

Aby wykonać ręczne ustawienie interfejsu sieciowego w systemie LINUX, należy użyć polecenia

Instalacja serwera stron www w rodzinie systemów Windows Server jest możliwa dzięki roli

Program fsck jest stosowany w systemie Linux do

Wartość sumy liczb binarnych 1010 i 111 zapisana w systemie dziesiętnym to

Wskaż rysunek ilustrujący kondensator stały?

Okablowanie pionowe w sieci strukturalnej łączy jakie elementy?

Aby telefon VoIP działał poprawnie, należy skonfigurować adres

Który protokół odpowiada za bezpieczne przesyłanie danych w sieciach komputerowych?

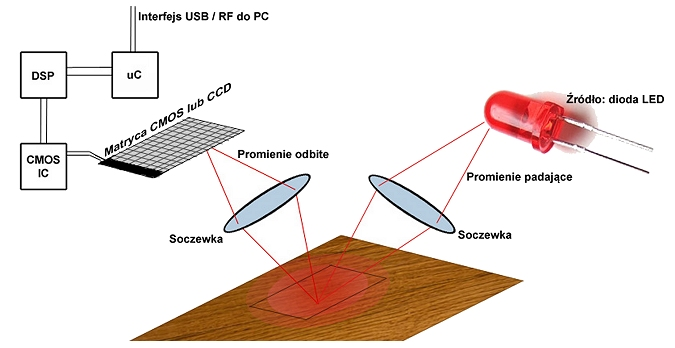

Zaprezentowany diagram ilustruje zasadę funkcjonowania

W trakcie normalnego funkcjonowania systemu operacyjnego w laptopie zjawia się informacja o potrzebie sformatowania wewnętrznego dysku twardego. Co to oznacza?

Na przedstawionym zdjęciu widoczna jest

Użytkownik systemu Windows napotyka komunikaty o niewystarczającej pamięci wirtualnej. Jak można rozwiązać ten problem?

W systemach Windows istnieje możliwość przypisania użytkownika do dowolnej grupy za pomocą panelu

Który z poniższych programów nie jest wykorzystywany do zdalnego administrowania komputerami w sieci?

W technologii Ethernet, protokół CSMA/CD do dostępu do medium działa na zasadzie

Jaką rolę pełni serwer FTP?

Podczas skanowania reprodukcji obrazu z magazynu, na skanie obrazu ukazały się regularne wzory, zwane morą. Jakiej funkcji skanera należy użyć, aby usunąć te wzory?

W systemie Linux polecenie touch jest używane do

AES (ang. Advanced Encryption Standard) to standard szyfrowania, który?

Tusz w żelu wykorzystywany jest w drukarkach

Funkcja System Image Recovery dostępna w zaawansowanych opcjach uruchamiania systemu Windows 7 pozwala na

Zasady filtrowania ruchu w sieci przez firewall określane są w formie

Switch jako kluczowy komponent występuje w sieci o strukturze

Jaką komendę należy wpisać w miejsce kropek, aby w systemie Linux wydłużyć standardowy odstęp czasowy między kolejnymi wysyłanymi pakietami przy użyciu polecenia ping?

Interfejs równoległy, który ma magistralę złożoną z 8 linii danych, 4 linii sterujących oraz 5 linii statusowych, nie zawiera linii zasilających i umożliwia transmisję na dystans do 5 metrów, gdy kable sygnałowe są skręcone z przewodami masy, a w przeciwnym razie na dystans do 2 metrów, jest określany mianem

W nowoczesnych ekranach dotykowych działanie ekranu jest zapewniane przez mechanizm, który wykrywa zmianę

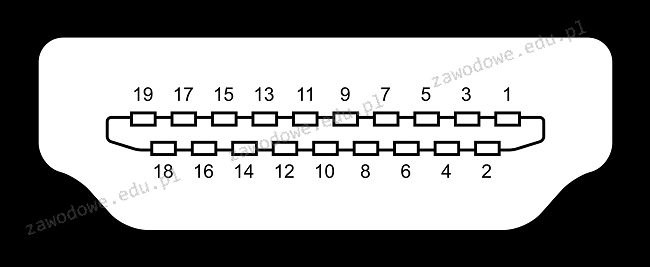

Zilustrowany na obrazku interfejs to

Który z wymienionych formatów płyt głównych charakteryzuje się najmniejszymi wymiarami?

Po uruchomieniu komputera, procedura POST wskazuje 512 MB RAM. Natomiast w ogólnych właściwościach systemu operacyjnego Windows wyświetla się wartość 480 MB RAM. Jakie są powody tej różnicy?

Zanim przystąpimy do prac serwisowych dotyczących modyfikacji rejestru systemu Windows, konieczne jest wykonanie

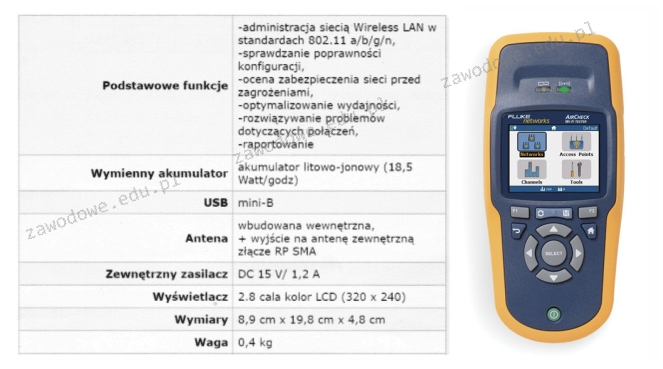

Jakie urządzenie diagnostyczne zostało zaprezentowane na ilustracji oraz opisane w specyfikacji zawartej w tabeli?

Adres MAC (Medium Access Control Address) to sprzętowy identyfikator karty sieciowej Ethernet w warstwie modelu OSI

Która norma odnosi się do okablowania strukturalnego?

Wykonanie polecenia fsck w systemie Linux spowoduje

Ile pinów znajduje się w wtyczce SATA?

Jednym z metod ograniczenia dostępu do sieci bezprzewodowej dla osób nieuprawnionych jest

Po przeprowadzeniu eksportu klucza HKCR zostanie utworzona kopia rejestru, zawierająca dane dotyczące konfiguracji