Pytanie 1

Aby zmienić ustawienia konfiguracyjne Menu Start oraz paska zadań w systemie Windows, która przystawka powinna być wykorzystana?

Wynik: 21/40 punktów (52,5%)

Wymagane minimum: 20 punktów (50%)

Aby zmienić ustawienia konfiguracyjne Menu Start oraz paska zadań w systemie Windows, która przystawka powinna być wykorzystana?

Zamieszczone atrybuty opisują rodzaj pamięci

| Maksymalne taktowanie | 1600 MHz |

| Przepustowość | PC12800 1600MHz |

| Opóźnienie | Cycle Latency CL 9,0 |

| Korekcja | Nie |

| Dual/Quad | Dual Channel |

| Radiator | Tak |

Jakie polecenie w systemie Linux służy do przypisania adresu IP oraz maski podsieci dla interfejsu eth0?

W systemie Windows, gdzie można ustalić wymagania dotyczące złożoności hasła?

Do instalacji i usuwania oprogramowania w systemie Ubuntu wykorzystywany jest menedżer

Jakim symbolem jest oznaczona skrętka bez ekranowania?

Na przedstawionym rysunku zaprezentowane jest złącze

Jaką topologię fizyczną sieci komputerowej przedstawia rysunek?

Aby zrealizować aktualizację zainstalowanego systemu operacyjnego Linux Ubuntu, należy wykonać polecenie

Aby zminimalizować główne zagrożenia dotyczące bezpieczeństwa podczas pracy na komputerze podłączonym do sieci Internet, najpierw należy

W nagłówku ramki standardu IEEE 802.3 w warstwie łącza danych znajduje się

Aby aktywować lub dezaktywować usługi w zainstalowanej wersji systemu operacyjnego Windows, należy wykorzystać narzędzie

Jaki typ zabezpieczeń w sieciach WiFi oferuje najwyższy poziom ochrony?

Jakim modułem pamięci RAM, który jest zgodny z płytą główną GIGABYTE GA-X99-ULTRA GAMING/ X99/8xDDR4 2133, ECC, maksymalnie 128GB/ 4x PCI-E 16x/ RAID/ USB 3.1/ S-2011-V3/ATX, jest pamięć?

Która z usług umożliwia rejestrowanie oraz identyfikowanie nazw NetBIOS jako adresów IP wykorzystywanych w sieci?

W przedsiębiorstwie zastosowano adres klasy B do podziału na 100 podsieci, z maksymalnie 510 dostępnymi adresami IP w każdej z nich. Jaka maska została użyta do utworzenia tych podsieci?

W jakiej warstwie modelu ISO/OSI wykorzystywane są adresy logiczne?

Która z możliwości konfiguracji ustawień dla użytkownika z ograniczonymi uprawnieniami w systemie Windows jest oferowana przez przystawkę secpol?

Według normy JEDEC, standardowe napięcie zasilające dla modułów pamięci RAM DDR3L o niskim napięciu wynosi

W systemie Linux komenda usermod -s umożliwia dla danego użytkownika

Aby procesor działał poprawnie, konieczne jest podłączenie złącza zasilania 4-stykowego lub 8-stykowego o napięciu

Który standard IEEE 802.3 powinien być użyty w sytuacji z zakłóceniami elektromagnetycznymi, jeżeli odległość między punktem dystrybucyjnym a punktem abonenckim wynosi 200 m?

Po zainstalowaniu systemu z domyślnymi parametrami, Windows XP nie obsługuje tego systemu plików.

Natychmiast po dostrzeżeniu utraty istotnych plików na dysku twardym, użytkownik powinien

Aby naprawić wskazaną awarię, należy

|

Użytkownik systemu Windows doświadcza problemów z niewystarczającą pamięcią wirtualną. Jak można temu zaradzić?

Jakim procesem jest nieodwracalne usunięcie możliwości odzyskania danych z hard dysku?

Jakie zdanie charakteryzuje SSH Secure Shell?

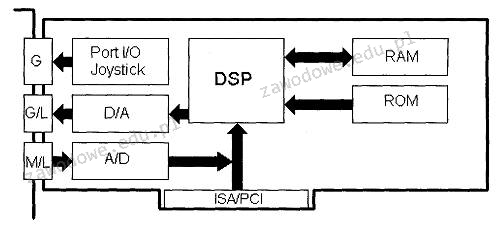

Element funkcjonalny opisany jako DSP w załączonym diagramie blokowym to

Komputer jest połączony z myszą bezprzewodową, a kursor w trakcie używania nie porusza się płynnie, tylko "skacze" po ekranie. Możliwą przyczyną awarii urządzenia może być

Tworzenie obrazu dysku ma na celu

Minimalna odległość toru nieekranowanego kabla sieciowego od instalacji oświetleniowej powinna wynosić

Jakie oprogramowanie opisuje najnowsza wersja wieloplatformowego klienta, który cieszy się popularnością wśród użytkowników na całym świecie, oferującego wirtualną sieć prywatną do nawiązywania połączenia pomiędzy hostem a lokalnym komputerem, obsługującego uwierzytelnianie z wykorzystaniem kluczy, certyfikatów, nazwy użytkownika i hasła, a także dodatkowych kart w wersji dla Windows?

Kabel typu skrętka, w którym pojedyncza para żył jest pokryta folią, a całość kabla jest osłonięta ekranem z folii i siatki, oznacza się symbolem

Rejestry procesora są resetowane poprzez

W systemie operacyjnym Linux, do konfigurowania sieci VLAN wykorzystuje się polecenie

Pamięć Intel® Smart Cache, która jest wbudowana w procesory o wielu rdzeniach, takie jak Intel® Core TM Duo, to pamięć

Ustawa z dnia 14 grudnia 2012 roku dotycząca odpadów zobowiązuje

Standardowe napięcie zasilające dla modułów pamięci RAM DDR4 wynosi

W systemie Linux komenda ifconfig odnosi się do